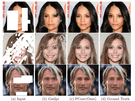

Nvidia heeft een eigen onderzoek gepresenteerd naar een manier om image inpainting uit te voeren, oftewel het wegwerken van gaten of beschadigde delen in een afbeelding. Het zet daarvoor deep learning in met een eigen techniek die voor betere resultaten zou zorgen.

Volgens Nvidia is de methode niet alleen te gebruiken om missende delen van een afbeelding op te vullen, maar juist ook om elementen van het beeld weg te halen. Het bedrijf heeft een video gepubliceerd waarin het de werking van zijn methode toont. Deze zou in beeldbewerkingssoftware toegepast kunnen worden, aldus Nvidia. Het bedrijf claimt dat zijn model 'gaten van elke vorm, grootte en afstand tot de beeldrand' aankan. De details van het onderzoek staan beschreven in een paper.

Daarin schrijven de onderzoekers dat hun onderzoek verschilt van eerder werk, dat zich vooral zou richten op rechthoekige beelddelen in het midden van de afbeelding. De nieuwe methode zou echter ook werken met onregelmatige vormen. Bovendien zouden de tot nu toe voorgestelde methodes vaak leiden tot visual artifacts in het uiteindelijke beeld. Die wil Nvidia tegengaan door output voor missende pixels niet afhankelijk te maken van de input voor die pixels, aldus het bedrijf.

De onderzoekers gebruikten een dataset van ongeveer 55.000 masks voor trainingsdoeleinden. Het gaat dan om missende delen in afbeeldingen. De gebruikte afbeeldingen kwamen uit andere datasets, namelijk ImageNet, Places2 en CelebA-HQ. Het trainen vond plaats op een Nvidia V100-accelerator met 16GB aan geheugen.

:strip_icc():strip_exif()/i/2001956863.jpeg?f=fpa_thumb)

/i/2000820476.png?f=fpa)

/i/1174394432.png?f=fpa)

/i/2001073393.png?f=fpa)

/i/2001877441.png?f=fpa)

:strip_exif()/i/1043851109.jpg?f=fpa)

/i/1300720051.png?f=fpa)

/i/2001673275.png?f=fpa)

/i/1349425400.png?f=fpa)