AMD brengt mogelijk eind juni zijn eerste videokaarten met Polaris-gpu op de markt. Het zou gaan om de R9 490X en R9 490. Volgens het gerucht worden de nieuwe videokaarten tijdens techbeurs Computex eind mei voor het eerst getoond.

Waarschijnlijk krijgen de videokaarten in de Radeon R9 400-serie gddr5x-geheugen. Micron gaf eerder al aan dat de eerste gpu's die van dat geheugen gebruik maken in de lente van 2016 zullen verschijnen. Het gerucht dat de kaarten eind juni verschijnen is afkomstig van HardwareBattle, schrijft VideoCardz. Eerder bracht die site het gerucht naar buiten dat de nieuwe gpu's van AMD de naam Polaris krijgen en dat bleek te kloppen.

De videokaarten zouden AMD Radeon R9 490X en R9 490 gaan heten en maken gebruik van de Polaris 10-gpu, die bedoeld is voor high-end videokaarten. Polaris 11, voor lager gepositioneerde kaarten, zou pas later uitgebracht worden.

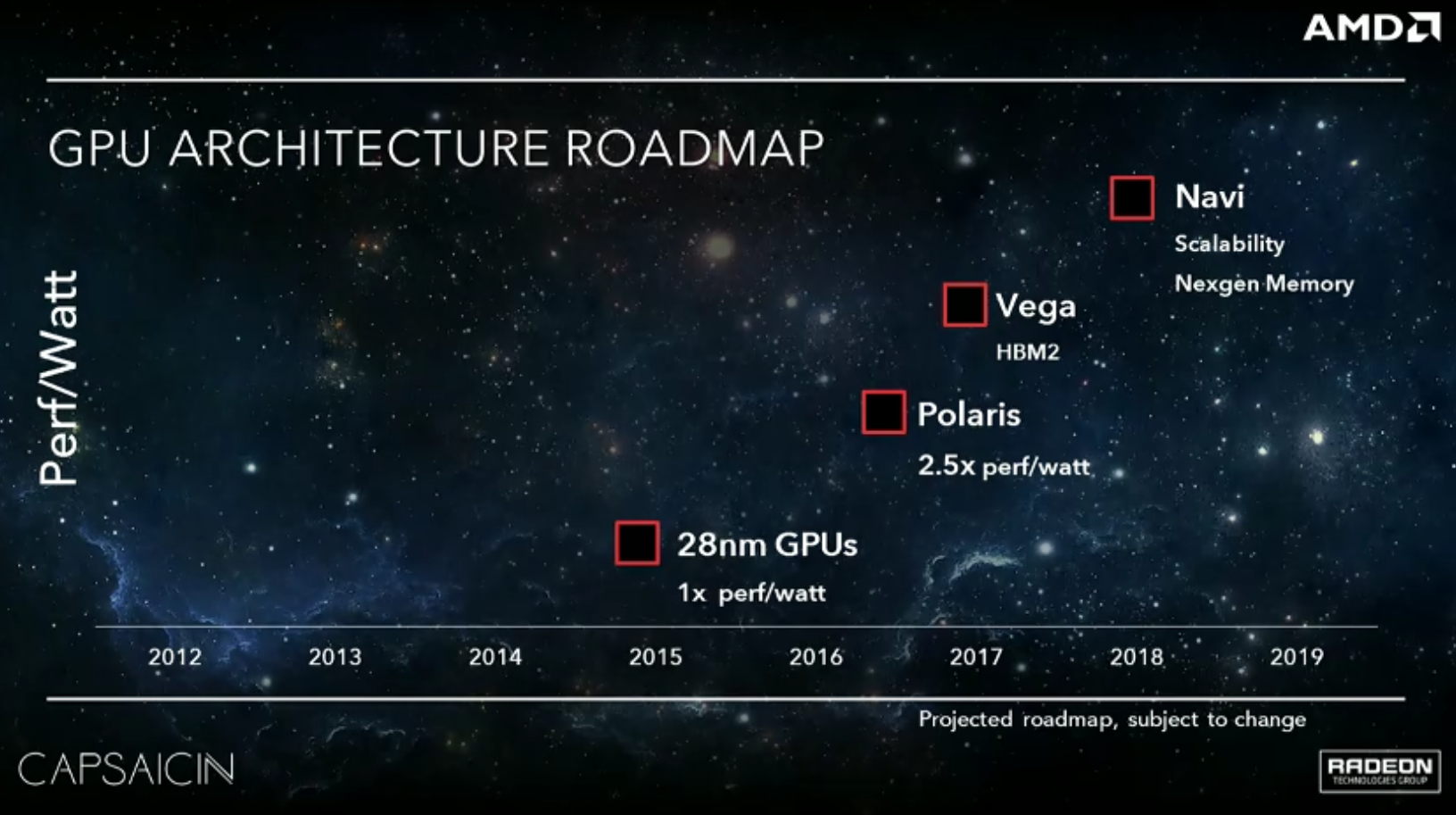

De fabrikant maakte onlangs zelf bekend dat Polaris-kaarten medio dit jaar zouden verschijnen door een roadmap te tonen tijdens het Capsaicin-evenement op de Game Developer Conference half maart.

AMD heeft zelf echter nog geen details gegeven over de naamgeving van de nieuwe kaarten. Ook is niet zeker welk geheugentype de kaarten krijgen. De roadmap maakt echter wel duidelijk dat hbm2 pas met de volgende generatie Vega-gpu's zal verschijnen, begin 2017.

De AMD Radeon R9 490X en 490 worden waarschijnlijk de tegenhangers van de Nvidia GeForce GTX 1080 en GTX 1070. Dat zijn eveneens modellen die officieel nog niet bestaan, maar volgens geruchten in mei worden aangekondigd.

Nvidia presenteerde dinsdag zijn GP100-gpu. Hoewel de fabrikant alleen een variant voor gpgpu-rekenwerk in servers heeft getoond, zal deze Pascal-chip ook de basis vormen voor de GeForce-kaarten voor gamers. Vermoedelijk gaat het echter om een aangepaste chip die gddr5x-geheugen gebruikt in plaats van hbm2.

Op 31 mei gaat in Taiwan de Computex van start. Waarschijnlijk zal deze beurs het toneel vormen voor de introductie van nieuwe videokaarten uit het rode en groene kamp. De daadwerkelijke marktintroductie volgt meestal later; volgens het gerucht zijn de AMD-kaarten een maand later te koop.

:strip_exif()/i/2000957445.jpeg?f=fpa)

:strip_exif()/i/1380099265.jpeg?f=fpa)

/i/2000868224.png?f=fpa)

/i/2000820476.png?f=fpa)