Uit gelekte code van een Linux-patch is af te leiden dat de AMD Zen-processors mogelijk maximaal 32 fysieke cores krijgen. De code kwam aan het licht via Dresdenboy die de code op het Linux Kernel Mailing List-archief of lkml.org tegenkwam.

Volgens de blogger Dresdenboy blijkt uit de patch op lkml.org nu ook dat de codenaam Zeppelin echt achter de nieuwe Zen-processors schuilgaat. In de code staat namelijk AMD Zeppelin (Family 17h, Model 00h). Ook eerdere patches verwezen al op naar een nieuwe processorserie. In die patch werd alleen aan AMD Fam17h gerefereerd.

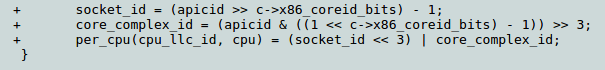

Het meest interessante deel in de oudere code van november vorig jaar is het deel waar gesproken wordt over hoe de last level cache ofwel llc id, wordt berekend van de op Zen-gebaseerde mpu's. Er staat in de code core complex, maar dit is volgens Dresdenboy vergelijkbaar met compute unit en werd al eerder in verschillende AMD-patenten gebruikt. Er staat in de code ook nog een >> 3, wat betekent dat er acht theoretische kernen aanwezig zijn per compute unit.

Daarna staat er dat de socket id met 3 naar links verplaatst wordt, waardoor er drie bits overblijven voor het core complex id, wat een maximum van acht core complexes per socket suggereert, ofwel 32 fysieke cores. Ondanks dat het getal in eerste instantie als tijdelijke gezien moet worden, doen er al verschillende geruchten de ronde dat 32 cores wel eens zou kunnen kloppen.

Code uit fix voor llc topology voor AMD Fam17h-systemen

Code uit fix voor llc topology voor AMD Fam17h-systemen

/i/2001237765.png?f=fpa)

/i/1242207182.png?f=fpa)

:strip_exif()/i/1295600046.gif?f=fpa)

:strip_exif()/i/1362392750.jpeg?f=fpa)

/i/1241443636.png?f=fpa)