Intel gaat in samenwerking met supercomputerbouwer Cray een machine bouwen voor het Argonne National Laboratory vlakbij Chicago. De computer, die in 2018 klaar moet zijn, zal naar verwachting 180 petaflops kunnen halen.

Het US Department of Energy betaalt 200 miljoen dollar voor de supercomputer Aurora. De machine is onderdeel van een project om verscheidene supercomputers in Argonne te bouwen die vijf tot zeven keer zo krachtig zijn als hedendaagse supercomputers. Ter vergelijking, de snelste supercomputer in de top-500 van november 2014 bereikt 33,9 petaflops. Aurora is de derde en laatste computer binnen het Coral-initiatief, dat in 2014 werd aangekondigd. In totaal is er 525 miljoen dollar mee gemoeid.

De onderzoeksdoelen waarvoor Aurora moet worden ingezet lopen uiteen. Zo moet gezocht worden naar nieuwe materiaalsoorten die krachtigere en duurzamere batterijen, en betere zonnepanelen opleveren. Ook zal onderzoek worden gedaan naar betere biobrandstoffen en de effecten van die brandstoffen op organismen, naar effectievere ziektebestrijding en naar hernieuwbare energiebronnen, zoals efficiëntere en stillere turbines voor windmolens, en betere ontwerpen van de wieken.

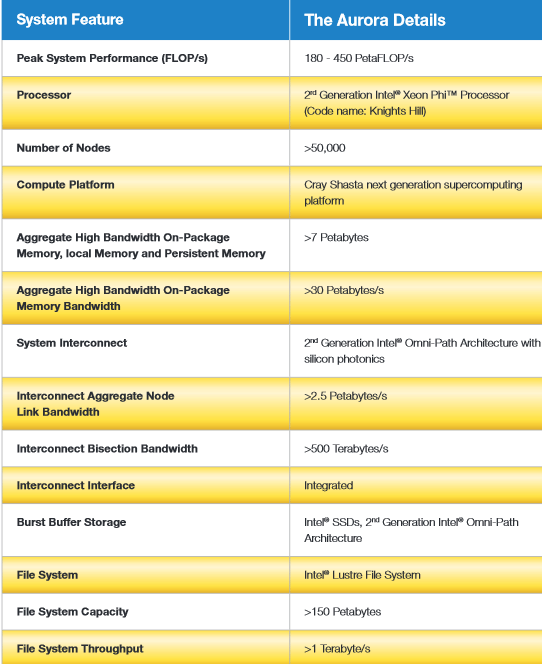

Het systeem zal gebruikmaken van deels nog te ontwikkelen Intel High Performance-bouwstenen, zoals toekomstige generaties van 10nm Intel Xeon Phi-processors, Intels Omni-Path Fabric hogesnelheidsverbindingstechnologie, een nieuwe, non-volatile geheugenarchitectuur en een bestandssysteem dat gebruikmaakt van Intels Lustre. Speculaties over hoe alles in elkaar moet zitten zijn te vinden op The Platform.

:strip_exif()/i/2001508675.jpeg?f=fpa)

/i/1340056824.png?f=fpa)

/i/1371467923.png?f=fpa)

/i/1242207182.png?f=fpa)

/i/1289644242.png?f=fpa)

/i/1194954230.png?f=fpa)