Onderzoekers hebben een methode ontwikkeld waarmee patiënten met het zogeheten locked-in syndroom toch kunnen communiceren met de buitenwereld. Een in de hersenen geïmplanteerde elektrode geeft spraaksignalen door aan een computer.

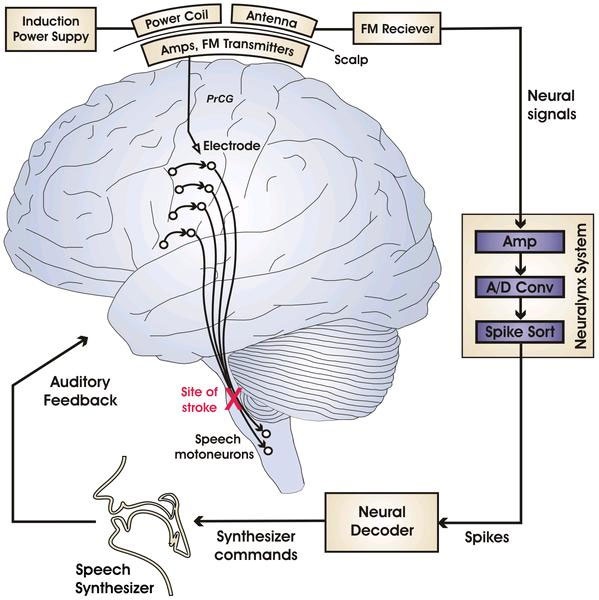

Na een herseninfarct kan een patiënt in een pseudocomateuze toestand raken, waarbij deze nog wel bij bewustzijn is, maar niet kan spreken of bewegen. Hoewel mensen vaak nog met oogbewegingen kunnen communiceren, zijn de patiënten vrijwel volledig van de buitenwereld afgesloten. Een groep onderzoekers van de Boston-universiteit en het MIT heeft echter een hersenimplantaat ontwikkeld dat elektrische signalen uit de spraakmotorcortex oppikt en deze via een fm-signaal naar een ontvanger stuurt.

De medewerkers van de onderzoeksinstituten implanteerden de elektrode vijf jaar geleden bij een toen 21-jarige patient met het locked-in syndroom. Uitlopers van hersencellen groeiden langzaam de elektrode in en produceerden daar elektrische signalen. Die signalen worden omgezet in een fm-signaal dat naar twee antenne-spoelen op het hoofd wordt gestuurd. Een derde spoel voorziet het implantaat via inductie van stroom. Daarmee is de brein-computer-interface geschikt voor langdurig gebruik en wordt de gebruiker niet gehinderd door bovenmatig veel externe hardware.

Drie elektrodes vangen de signalen van de neuronen op: deze zogenoemde formanten-frequenties, die coderen voor klinkers, worden door software geïnterpreteerd. Gedurende enkele maanden leerde de patiënt op basis van audio-feedback het systeem te gebruiken en hij haalt inmiddels een accuratesse van bijna negentig procent. Bovendien heeft het systeem slechts 50 milliseconde nodig om de signalen van de neuronen op te pikken, te versturen en te vertalen in spraak. Daarmee is het systeem ongeveer even snel als een persoon met intacte neurale paden.

Met meer elektrode-implantaten op meer dan één plaats in de motor-cortex zou het systeem ook in staat moeten zijn medeklinkers op te vangen en te synthetiseren. De onderzoekers denken met een volgende versie van het Neuralynx System, zoals het geheel van implantaat en externe hardware genoemd wordt, tenminste tien maal zoveel neuronen uit te kunnen lezen, wat het klankbereik moet verbeteren. Bovendien biedt het direct relateren van neuronale impulsen aan spraak mogelijkheden voor toekomstig onderzoek.

/i/1245595122.png?f=fpa)

:strip_exif()/i/1190903522.jpg?f=fpa)

/i/1236852193.png?f=fpa)

/i/1290589194.png?f=fpa)

:strip_exif()/i/1098602434.jpg?f=fpa)

/i/1187273135.png?f=fpa)

/i/1225133057.png?f=fpa)

:strip_exif()/i/1088692508.jpg?f=fpa)

/i/1198052698.png?f=fpa)

/i/1253887911.png?f=fpa)

/i/1238938082.png?f=fpa)

:strip_exif()/i/1227031420.gif?f=fpa)