Inleiding: geen natuurwet

Wie naar de Wet van Archimedes, de Wet van Ohm of de wetten van de thermodynamica vraagt, zal bij velen nul op het rekest krijgen. Noem je daarentegen de Wet van Murphy, dan kun je waarschijnlijk op meer begrip rekenen. Ook de Wet van Godwin zal, zeker bij forumbezoekers, zonder veel problemen opgedreund worden. De Wet van Moore bevindt zich tussen beide categorieën in, want als je daarnaar vraagt, is de kans groot dat je verschillende interpretaties hoort. Desalniettemin is het een uitspraak die de technologiesector als geen ander heeft gevormd en voortgedreven.

De gevleugelde uitspraak van Gordon Moore is in de loop der tijd hier en daar wat getweakt en viert op 19 april zijn vijftigste verjaardag. Moore deed zijn voorspelling, want zo begon de Wet van Moore, toen hij nog niet bij Intel werkte. Drie jaar na de uitspraak richtte hij met zijn compagnon Robert Noyce het bedrijf NM Electronics op, wat later Intel zou worden.

De wet is inmiddels bijna synoniem voor de snelheid waarmee processors evolueren, maar is eigenlijk veel meer dan dat. De Wet van Moore gaat niet alleen op voor processors, maar ook voor veel andere technologische ontwikkelingen. Bovendien is het niet zozeer een beschrijvende wet, maar eerder een drijvende kracht die innovatie en vooruitgang al decennia lang stimuleert en uitdaagt de grenzen te verleggen. Ter gelegenheid van de vijftigste verjaardag van de Wet van Moore bekijken we welke invloed deze wet had op een halve eeuw technologische vooruitgang.

Geschiedenis: de beginjaren van de halfgeleiderindustrie

Wie is toch die Gordon Moore die zomaar een wet die al vijftig jaar standhoudt naar zich vernoemd kreeg?

Gordon E. Moore studeerde scheikunde en natuurkunde aan de Caltech-universiteit en werkte na zijn promotieonderzoek korte tijd bij het Shockley Semiconductor Laboratory. Hij vertrok daar echter al snel en richtte met acht man, waaronder Robert Noyce, het bedrijf Fairchild Semiconductor op. Dat bedrijf pionierde onder meer met het gebruik van silicium als basismateriaal voor transistors en tweedimensionale, platte geïntegreerde circuits op substraten.

Gordon E. Moore studeerde scheikunde en natuurkunde aan de Caltech-universiteit en werkte na zijn promotieonderzoek korte tijd bij het Shockley Semiconductor Laboratory. Hij vertrok daar echter al snel en richtte met acht man, waaronder Robert Noyce, het bedrijf Fairchild Semiconductor op. Dat bedrijf pionierde onder meer met het gebruik van silicium als basismateriaal voor transistors en tweedimensionale, platte geïntegreerde circuits op substraten.

Uit het r&d-lab van Fairchild Semiconductor, waarvan Gordon Moore het hoofd was, kwamen ook ontwikkelingen op het gebied van mosfet-technologie en op-amps, en het bedrijf was verantwoordelijk voor de chips van de Apollo Guidance Computer die in de Apollo-missies gebruikt werd.

In de eerste helft van de jaren zestig ging het Fairchild Semiconductor voor de wind, maar vanaf 1967 ging het zowel organisatorisch als financieel minder. In 1968 besloot de tweede man van het bedrijf, Robert Noyce, om samen met Gordon Moore een nieuw bedrijf te beginnen. Aanvankelijk noemden ze hun bedrijf NM Electronics, met de eerste letters van de achternamen van beide oprichters. Het bedrijf zou die naam maar kort voeren. Moore en Noyce noemden het bedrijf voortaan Intel, een samentrekking van Integrated Electronics./i/2000601702.jpeg?f=imagenormal)

De Wet van Moore

/i/2000601703.jpeg?f=imagenormal) Het was nog tijdens zijn functie als hoofd r&d bij Fairchild Semiconductor dat Gordon Moore zijn inmiddels vermaarde wet opschreef. Hij deed dat in het aprilnummer van de vijfendertigste jaargang van het tijdschrift Electronics Magazine. Hij schreef in dat nummer, dat op 19 april 1965 uitkwam, een beschouwing over de toekomst van de halfgeleiderindustrie. De titel van het artikel luidde Cramming more components in electronic circuits. Daarin voorspelde hij hoe de industrie waarin hij werkzaam was er in 1975 zou uitzien.

Het was nog tijdens zijn functie als hoofd r&d bij Fairchild Semiconductor dat Gordon Moore zijn inmiddels vermaarde wet opschreef. Hij deed dat in het aprilnummer van de vijfendertigste jaargang van het tijdschrift Electronics Magazine. Hij schreef in dat nummer, dat op 19 april 1965 uitkwam, een beschouwing over de toekomst van de halfgeleiderindustrie. De titel van het artikel luidde Cramming more components in electronic circuits. Daarin voorspelde hij hoe de industrie waarin hij werkzaam was er in 1975 zou uitzien.

In zijn beschouwing voorspelde Moore de komst van personal computers, mobiele telefoons en zelfrijdende auto's, allemaal mogelijk gemaakt door steeds complexere geïntegreerde circuits. Bedenk dat dit ten tijde van de beginjaren van chips was. De siliciumchip was in 1959 uitgevonden en de eerste processor voor computers, de Intel 4004, zou pas in 1971 verschijnen, met 2300 transistors aan boord. Moore voorspelde chips met 65.000 transistors voor 1975. Ter vergelijking, rond 1965 liep het aantal componenten in chips in de tientallen transistors en passieve componenten.

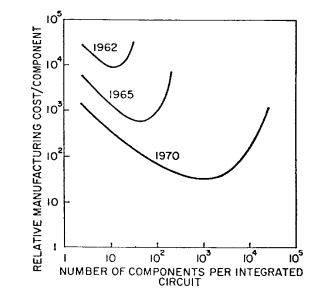

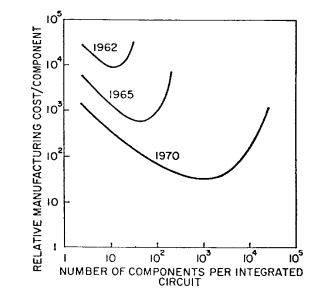

De eigenlijke Wet van Moore betreft niet zozeer de hoeveelheid componenten in een geïntegreerd circuit, maar het aantal componenten in zo'n chip, waarbij de kosten per component minimaal zijn. Naarmate de complexiteit, het aantal transistors dus, groeit, nemen de kosten per component af. Tegelijk leiden lagere aantallen correct functionerende chips, ook bekend als lagere yields, tot een kostenstijging.

Het optimale punt, waar de prijs per onderdeel het laagst is, afgezet tegen het aantal componenten, is waar de Wet van Moore vandaan komt. De eigenlijke wet zegt dat het aantal componenten dat tegen de laagste prijs geproduceerd kan worden elk jaar verdubbelt. Tot ten minste 1975 zou die trend aanhouden, zo voorspelde Moore. In 1975 corrigeerde Moore zijn voorspelling, met een tweejaarlijkse verdubbeling van chipcomplexiteit versus componentenprijs in plaats van een jaarlijkse verdubbeling.

Het optimale punt, waar de prijs per onderdeel het laagst is, afgezet tegen het aantal componenten, is waar de Wet van Moore vandaan komt. De eigenlijke wet zegt dat het aantal componenten dat tegen de laagste prijs geproduceerd kan worden elk jaar verdubbelt. Tot ten minste 1975 zou die trend aanhouden, zo voorspelde Moore. In 1975 corrigeerde Moore zijn voorspelling, met een tweejaarlijkse verdubbeling van chipcomplexiteit versus componentenprijs in plaats van een jaarlijkse verdubbeling.

Een makkelijkere verwoording van de Wet van Moore, zoals bovenstaande voorspelling vanaf 1975 bekend zou worden, is dat de transistordichtheid van chips elke twee jaar verdubbelt. Daarbij wordt de optimale verhouding tussen dichtheid en yields, en dus de productieprijs van een chip en de prijs per transistor, impliciet gehouden. Door ook de snelheid van processors in de vergelijking te betrekken, is de Wet van Moore inmiddels dan ook vooral bekend als de uitspraak dat processors elke anderhalf jaar in snelheid verdubbelen. De laatste interpretatie gaat niet echt meer op, maar tot op de dag van vandaag verdubbelt het aantal transistors in chips elke twee jaar.

Een voorbeeldje: stel, een chip kost 10 euro om te maken en er zitten 100 transistors op. De prijs per transistor is dan 10 cent, maar 20 procent van de chips functioneert niet goed. De kosten zijn dan 12,5 cent per transistor op een goed functionerende chip. Twee jaar later kunnen we 400 transistors op een chip kwijt. De chip maken kost inmiddels, omdat het procedé lastiger is, 20 euro. De toegenomen complexiteit heeft bovendien tot gevolg dat nog maar 64% van de chips goed functioneert. De kosten per 'goede' transistor zijn dan nog maar 4 cent. Twee jaar later kunnen er weer meer transistors op een duurdere chip, met iets lagere yields, maar de helft van de prijs per transistor. Deze versie van de Wet van Moore gaat tot op de dag van vandaag op.

Meer dan een observatie

De Wet van Moore mag dan in 1965 begonnen zijn als een observatie van de technologie-industrie, die destijds nog in de kinderschoenen stond, en als voorspelling voor de nabije toekomst, in zijn vijftigjarige bestaan is de wet veel meer dan dat gebleken.

Het is niet toevallig dat de wet al vijftig jaar, of na zijn revisie veertig jaar, overeind is gebleven. De technologie-industrie doet zijn uiterste best eraan vast te houden; hij is verworden tot een leidraad voor chipfabrikanten. Het is niet voor niets dat samenwerkende halfgeleiderbedrijven in de International Technology Roadmap for Semiconductors, kortweg ITRS, de Wet van Moore aanhouden voor de planning van de roadmap.

/i/2000601710.jpeg?f=imagenormal) Hoewel de afmetingen in die roadmap niet elke twee jaar halveren, zoals Moore's Law weleens foutief geïnterpreteerd wordt, verdubbelen de dichtheden van chips wel elke twee jaar. We zijn inmiddels bij de 14nm-node aangekomen, met dichtheden voor mlc-flashgeheugen van 128GB. Voor de 10nm-node is dat 256GB; voor 7nm 512GB. In hoeverre de nodes daarna nog haalbaar zijn, is lastig te schatten, maar de corresponderende dichtheden van de 5nm-node en de 3,5nm-node voor respectievelijk 2019 en 2021 verdubbelen nog steeds naar 1 en 2TB per chip.

Hoewel de afmetingen in die roadmap niet elke twee jaar halveren, zoals Moore's Law weleens foutief geïnterpreteerd wordt, verdubbelen de dichtheden van chips wel elke twee jaar. We zijn inmiddels bij de 14nm-node aangekomen, met dichtheden voor mlc-flashgeheugen van 128GB. Voor de 10nm-node is dat 256GB; voor 7nm 512GB. In hoeverre de nodes daarna nog haalbaar zijn, is lastig te schatten, maar de corresponderende dichtheden van de 5nm-node en de 3,5nm-node voor respectievelijk 2019 en 2021 verdubbelen nog steeds naar 1 en 2TB per chip.

De wet van Moore is ook de reden waarom onze elektronica niet alleen steeds goedkoper wordt, maar ook waarom in steeds meer apparaten processors zitten. Met het internet-of-things zou volgens sommigen bijna alles onderling verbonden zijn, maar we zijn al lang zo ver dat in apparaten waarin vroeger geen elektronica te bekennen was inmiddels een krachtige microprocessor zit. Denk aan auto's, waarin koplampen meedraaien met de weg, airbags zich opblazen bij ongelukken, de motor zuiniger is geworden dankzij precies gereguleerde brandstofmengsels en onboard-entertainmentsystemen passagiers bezighouden.

/i/2000601721.jpeg?f=imagenormal)

Of kijk naar je waterkoker, die je inmiddels via je smartphone kunt aanzetten. De tijd van cd's of dvd's branden ligt achter ons, mede doordat usb-drives zo goedkoop zijn geworden. Over prijsdalingen gesproken, voor enkele tientjes koop je nu 4GB werkgeheugen; in de jaren negentig betaalde je ettelijke honderden guldens voor een paar megabytes. We krijgen, dankzij de steeds verdere integratie van miljoenen en zelfs miljarden transistors op een chip en alsmaar dalende prijzen, steeds meer rekenkracht en opslag voor alsmaar dalende prijzen.

Dat is niet de enige invloed van de Wet van Moore. Elektronicabedrijven zijn inmiddels van enorme invloed op onze economie. Bedrijven als Apple, Google, IBM, HP, Dell, Microsoft, Foxconn en Samsung hebben omzetten van tientallen miljarden dollars, samen goed voor zo'n biljoen euro.

Ook in het dagelijks leven is de invloed van de Wet van Moore, of ten minste de exponent ervan, goed zichtbaar. Een mooi voorbeeld is de komst van draagbare elektronica, enerzijds met walkmans via diskmans naar mp3-spelers, anderzijds van 'draagbare' telefoons via gsm-telefoons naar smartphones. We hebben allemaal tablets, ultraportables, laptops, pc's en smart-tv's in huis, wat allemaal niet mogelijk zou zijn zonder steeds kleinere én goedkopere processors.

Self-fulfilling prophecy?

Als we van de eerste microprocessor, de Intel 4004 uit 1971, naar de nieuwste Broadwell-chips van 14nm uit 2015 gaan, zien we verschillende belangrijke innovaties die steeds kleiner wordende transistors mogelijk hebben gemaakt. Ten eerste zijn er in die 44 jaar geen 22 nodes geweest, maar slechts 19. Wel zijn we bijna duizendmaal zo kleine transistors gaan gebruiken. De 4004 was op een 10µm-procedé gemaakt, terwijl Broadwell op 14nm wordt gemaakt. Bovendien bevatte de 4004 slechts 2300 transistors op 12mm², terwijl een Broadwell-Y-processor zo'n 1,3 miljard transistors op een oppervlak van 82mm² herbergt. Kijken we naar de snelheid, dan zijn die getallen 740kHz tegen ruwweg 2GHz, waarmee de moderne processors zo'n drieduizend keer sneller zijn. Daarbij is het energiegebruik duizenden keren lager, terwijl de prijs zonder inflatiecorrectie ongeveer gelijk is gebleven. Dat betekent uiteraard dat de prijzen per transistor tienduizenden keren lager zijn geworden.

/i/2000601723.png?f=imagenormal)

Is het nu zo dat de Wet van Moore zonder moeite kan opgaan gedurende vijftig jaar halfgeleiderproductie? Een kwestie van elke twee jaar de transistors half zo groot maken zou je zeggen, maar zo eenvoudig is het uiteraard niet. Om de trend door te zetten worden fabrikanten gedwongen om steeds weer innovatieve trucjes te bedenken om transistors kleiner, goedkoper en zuiniger te maken. Al menigmaal is voorspeld dat de Wet van Moore toch echt niet langer kon opgaan en steeds is er een manier gevonden om de transistordichtheid te blijven schalen.

Om steeds kleinere transistors mogelijk te maken heeft de industrie door de jaren heen diverse innovaties ontwikkeld, zoals de overstap naar cmos-transistors, het gebruik van koperen interconnects en de ontwikkeling van betere isolatiematerialen als vervanging van siliciumdioxide voor de gates van transistors. Ook bekende ontwikkelingen zijn het gebruik van strained silicium en de overstap naar finfets. Deze hebben steeds kleinere transistors mogelijk gemaakt en elke keer heeft zo'n innovatie de Wet van Moore nieuw leven ingeblazen, waar volgens kenners de grenzen bij 90, 45 of 22nm echt bereikt zouden zijn.

/i/2000601724.png?f=imagenormal)

Inmiddels zijn we aangeland bij de 14/16nm-generatie processors en moeten producten die op een 10nm-procedé gemaakt worden in 2016 of 2017 verschijnen. Hoe houdt Moore's Law stand beneden de 10nm-grens?

De toekomst

Het ontwikkelen van processors en de bijbehorende technologie vergt vanzelfsprekend jaren werk. Aan de 10nm-node is al gewerkt en hoewel producten nog minstens een jaar op zich laten wachten, zijn er al 10nm-testchips geproduceerd. Ook aan de 7nm-node wordt al gewerkt, maar veel informatie is nog niet vrijgegeven. Intel heeft al wel aangegeven dat silicium waarschijnlijk niet het materiaal is dat voor dat proces zal worden gebruikt. In plaats daarvan zou een materiaal als indiumgalliumarsenide, uit de groep zogenoemde III-V-halfgeleiders, gebruikt kunnen worden.

/i/2000601722.png?f=imagenormal)

Een andere methode om de Wet van Moore langer in stand te houden is het gebruik van euv-licht om de wafers te belichten. Nu wordt daarvoor nog licht met een golflengte van 193nm gebruikt, maar met euv zouden kleinere structuren tijdens het belichten gerealiseerd kunnen worden. Het overstappen op grotere wafers kan eveeens de kosten per chip drukken. Nu worden nog 300mm-wafers gebruikt, maar de industrie maakt zich, overigens al geruime tijd, op voor wafers met een diameter van 450mm.

Voor nog kleinere transistors wordt ook gekeken naar andere materialen en transistorstructuren, buiten de III-V-halfgeleiders en finfets. Voor 7nm zouden fets met een ronde gate-structuur rond nanodraden gebruikt kunnen worden. IBM heeft al transistors gemaakt van koolstofnanobuisjes. Voor nog kleinere structuren zou uitgeweken kunnen worden naar grafeen en atomaire transistors. Ook technologieën als spintronics en zelfs bio-organische computers zouden in de toekomst de Wet van Moore in stand kunnen houden. Voor hoe lang, dat blijft een vraag.

/i/2000601702.jpeg?f=imagenormal)

/i/2000601703.jpeg?f=imagenormal)

/i/2000601710.jpeg?f=imagenormal)

/i/2000601721.jpeg?f=imagenormal)

/i/2000601723.png?f=imagenormal)

/i/2000601724.png?f=imagenormal)

/i/2000601722.png?f=imagenormal)

:strip_icc():strip_exif()/i/2003043920.jpeg?f=fpa_thumb)

/i/2001190117.png?f=fpa_thumb)

:strip_exif()/i/2005686012.jpeg?f=fpa)

/i/2001435495.png?f=fpa)

/i/1242207182.png?f=fpa)