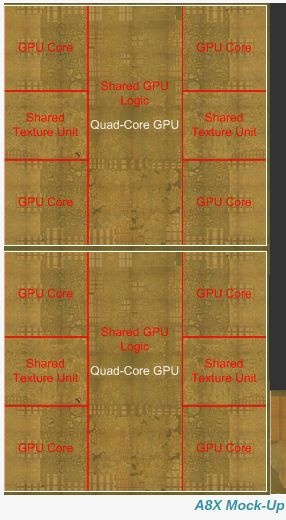

De A8X-soc in de iPad Air 2 heeft waarschijnlijk een gpu met acht cores. Dat heeft Anandtech afgeleid van een die shot. Het gaat vermoedelijk om een gpu die fabrikant Imagination nooit heeft aangekondigd en die Anandtech GXA6850 noemt.

De gpu zou daarmee tweemaal zoveel cores hebben als die in de iPhone 6 en 6 Plus, de GX6450. Hoewel Imagination de GXA6850 nooit heeft aangekondigd, wijst Anandtech erop dat Imagination bij de aankondiging van zijn nieuwe serie gpu's vorige week zei dat het topmodel 16 cores had, twee keer zoveel als het huidige topmodel in de Serie 6XT.

De gpu zou daarmee tweemaal zoveel cores hebben als die in de iPhone 6 en 6 Plus, de GX6450. Hoewel Imagination de GXA6850 nooit heeft aangekondigd, wijst Anandtech erop dat Imagination bij de aankondiging van zijn nieuwe serie gpu's vorige week zei dat het topmodel 16 cores had, twee keer zoveel als het huidige topmodel in de Serie 6XT.

Het is daarmee voor het eerst dat Apple een onaangekondigde gpu gebruikt in zijn soc. Dat wijst erop dat Apple nauw samenwerkt met fabrikant Imagination aan de implementatie van nieuwe gpu's. Anandtech hint erop dat Apple de gpu zelf zou hebben ontworpen op basis van de G6450. De soc zit alleen in de iPad Air 2.

Het is onbekend hoe Anandtech aan de informatie komt. De site staat bekend om zijn contacten binnen de afdelingen van bedrijven die verantwoordelijk zijn voor het maken van processors. De oprichter van de site, Anand Lal Shimpi, verliet eerder dit jaar de site waaraan hij zijn naam gaf om bij Apple te gaan werken.

/i/1243346069.png?f=fpa)

/i/1348755445.png?f=fpa)

/i/1304429433.png?f=fpa)

/i/1317305413.png?f=fpa)

/i/1309183882.png?f=fpa)