Microsoft werkt aan software om schokkerige timelapsevideo's die bijvoorbeeld tijdens sportactiviteiten zijn genomen te converteren naar soepel lopende actiebeelden. De zogeheten Hyperlapse-technologie moet onder andere beschikbaar komen in een Windows-applicatie.

Actiebeelden die geschoten zijn met bijvoorbeeld een GoPro-helmcamera en in een zogeheten timelapse versneld worden afgespeeld, hebben veelal een schokkerige video tot resultaat. Het toepassen van traditionele videoalgoritmen op de beelden, zoals beeld- en tijdstabilisatie, hebben weinig tot geen positieve impact. Microsoft Research stelt echter dat zij met hun zelfontwikkelde Hyperlapse-software, dat een aantal specifiek ontwikkelde algoritmen bevat, alsnog soepel lopende timelapses kan genereren

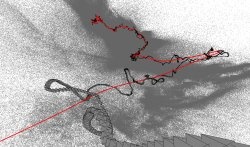

De ontwikkelaars van Microsoft gebruiken drie stappen om de schokkerige beelden te corrigeren. In de reconstructiefase wordt een 3d-model gegenereerd op basis van de videobeelden. Vervolgens wordt in de tweede fase door algoritmen een soepel lopend pad gegenereerd. Daarbij wordt op basis van meerdere frames een nieuw frame gegenereerd. Vervolgens wordt in een laatste stap het bronmateriaal gerenderd tot een nieuwe video.

De ontwikkelaars van Microsoft gebruiken drie stappen om de schokkerige beelden te corrigeren. In de reconstructiefase wordt een 3d-model gegenereerd op basis van de videobeelden. Vervolgens wordt in de tweede fase door algoritmen een soepel lopend pad gegenereerd. Daarbij wordt op basis van meerdere frames een nieuw frame gegenereerd. Vervolgens wordt in een laatste stap het bronmateriaal gerenderd tot een nieuwe video.

Een demonstratievideo van Microsoft Research toont een testversie van de Hyperlapse-software. De beelden zijn aanmerkelijker soepeler dan het origineel, al maken de algoritmes zo nu en dan nog foutjes waardoor 'pop-ups' ontstaan. Uiteindelijk wil Microsoft een app voor Windows gaan uitbrengen die gebruikmaakt van de Hyperlapse-technologie, al is nog onduidelijk wanneer deze beschikbaar zal komen.

:fill(white):strip_exif()/i/1321548326.jpeg?f=thumbmedium)

:strip_exif()/i/1350894765.png?f=thumbmedium)

:strip_exif()/i/1399535558.jpeg?f=fpa)

:fill(white):strip_exif()/i/1381842111.jpeg?f=thumbmedium)

:strip_exif()/i/2001148733.png?f=thumbmedium)

:strip_exif()/i/1334068637.jpeg?f=fpa)

/i/2000566602.png?f=fpa)

/i/1337696267.png?f=fpa)

/i/1319526793.png?f=fpa)

:strip_exif()/i/1296474747.gif?f=fpa)