Onderzoekers van Nvidia hebben een manier gevonden om de resolutie van een beeldscherm te verviervoudigen en de refreshrate te verdubbelen. Hiervoor stapelen zij meerdere schermen op elkaar, maakte het Amerikaanse bedrijf maandag bekend.

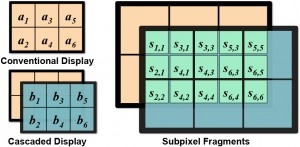

De onderzoekers pasten de techniek, die zij cascaded displays noemen, voor het eerst toe bij twee lcd-schermen van 7" met een resolutie van 1280 bij 800 pixels. Ze verwijderden de behuizing van beide panelen en plaatsten die op elkaar. Daarbij werd de backlight van één scherm, dat bovenop werd geplaatst, weggehaald.

Vanwege een polarisatieverschil werd er een afstand van een kwart pixel tussen beide schermen gehanteerd. Hierdoor besloeg iedere pixel van het bovenste lcd-scherm, die als 'sluiter' diende, vier pixel pixels van de onderste. Uit de eerste resultaten bleek het concept scherpere afbeeldingen op te leveren dan reguliere lcd-schermen, met name als er werd ingezoomd.

Bij een tweede experiment bootsten de onderzoekers het effect succesvol na bij een andere toepassing. Hiervoor gebruikten zij de lenzen van twee LCoS-projectoren en plaatsten zij die op een breadboard, waarbij de afbeelding van de eerste projector door middel van een zogeheten relay lens gelijktijdig met de afbeelding van de tweede zichtbaar werd. Door middel van een stralingsdeler en een projectielens kon de gecombineerde afbeelding vervolgens scherper worden getoond.

De techniek zou volgens Nvidia met name nuttig zijn voor vr-brillen, zoals de Oculus Rift. Bij die brillen valt een lage resolutie namelijk eerder op, omdat de ogen dichtbij het scherm zijn. Desondanks laat Nvidia niets los over eventuele producten die ook daadwerkelijk met de techniek worden uitgerust.

:strip_icc():strip_exif()/i/1392391650.jpeg?f=fpa_thumb)

/i/1208164214.png?f=fpa)

/i/1368542044.png?f=fpa)

/i/1303211688.png?f=fpa)