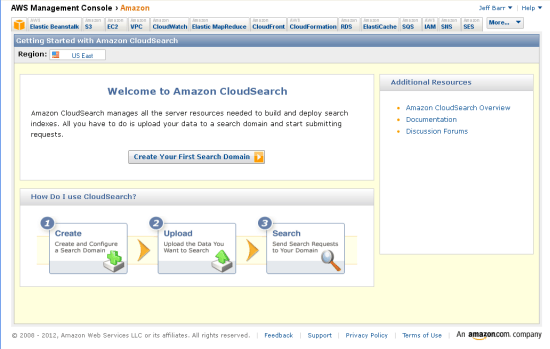

Amazon komt met een clouddienst voor het aanbieden van een zoekmachine. De gebruiker uploadt datasets en vervolgens levert Amazon de search-engine. Zoekresultaten kunnen vervolgens via een api worden opgevraagd.

De nieuwe Amazon-dienst kan worden gebruikt in combinatie met Amazons eigen storage-dienst S3, maar datasets kunnen ook op een andere wijze worden geüpload. Zoekresultaten kunnen worden opgevraagd als json- of xml-feed. Gebruikers betalen op basis van het aantal documenten dat moet worden doorzocht en de hoeveelheid data die heen en weer wordt geschoven.

De 'search instances' zijn beschikbaar in de smaken klein, groot en extra groot. Amazon schat dat, afhankelijk van de documentgrootte, in die instances respectievelijk 1, 4 en 8 miljoen documenten passen. Een kleine instance kost 12 dollarcent per uur; een grote 48 dollarcent en een extra grote 68 dollarcent. Daarbij moet worden aangetekend dat wanneer veel zoekresultaten worden opgevraagd, het nodig kan zijn om een extra instance te starten en gebruikers dus hogere prijzen betalen.

Voor inkomende gegevens, zoals datasets, hoeft niet te worden betaald; voor uitgaande data moet minimaal 7 en maximaal 12 dollarcent per gigabyte worden betaald, afhankelijk van het totale verbruik. Wel moet worden betaald voor batch-uploads, namelijk 10 dollarcent per 1000 batches, waarbij elke batch maximaal 5MB aan gegevens mag bevatten. Ook voor het opnieuw indexeren van gegevens moet worden betaald: 98 dollarcent per gigabyte aan data.

/i/1236173787.png?f=fpa)

/i/1341494729.png?f=fpa)

:strip_exif()/i/1336127074.jpeg?f=fpa)

/i/1225188467.png?f=fpa)

/i/1257765863.png?f=fpa)