De volgende maand te verschijnen Geforce 177.39-driver zal ondersteuning voor het Physx-platform bevatten. In eerste instantie zullen alleen de snelste kaarten van Nvidia hier baat bij hebben, andere volgen in een later stadium.

De donderdag onthulde Geforce 9800GTX+ zal medio juli in de winkels liggen, en Nvidia zal tegelijkertijd een nieuwe versie van de Geforce-drivers online zetten. In deze 177.39-versie van stuurprogramma's wordt Physx-support voor een aantal kaarten verwerkt, schrijft Hothardware. In eerste instantie zullen de 9800 GTX-, de 9800 GTX+-, en de GTX260/280-kaarten ondersteund worden, maar op termijn zal Nvidia alle videokaarten uit de 8- en de 9-serie ondersteunen.

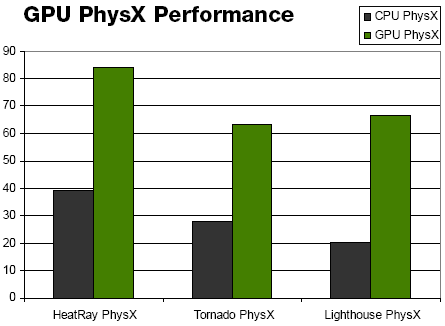

Software die van de Physx-middleware gebruikmaakt, kan met de nieuwe drivers een forse prestatiewinst tegemoet zien. Hothardware wist de hand op een benchmark voor Unreal Tournament 3 te leggen, waaruit blijkt dat de Physx-versie van het spel twee tot drie keer beter kan presteren als de gpu voor de natuurkundige berekeningen wordt ingezet - al is niet duidelijk wat er precies wordt gemeten. Onder druk van AMD, dat het 200-dollarsegment probeert te veroveren met de HD 4850, zal Nvidia de 9800GTX en de 9800GTX+ voor respectievelijk 199 en 229 dollar in de winkel leggen. Voor de liefhebbers van software met Physx-ondersteuning lijkt juli daarmee hoe dan ook een zonnige maand te worden.

/i/1237635048.png?f=fpa)

/i/1228815558.png?f=fpa)

/i/1208164214.png?f=fpa)

/i/1213881701.png?f=fpa)

:strip_exif()/i/1142869240.jpg?f=fpa)

:strip_exif()/i/1144679778.jpg?f=fpa)