Vlak voor de start van de CES-beurs in Las Vegas heeft nVidia details vrijgegeven over de hybride sli-techniek waaraan het bedrijf werkt. Onderdeel van de plannen is om alle nieuwe chipsets uit te rusten met geïntegreerde graphics.

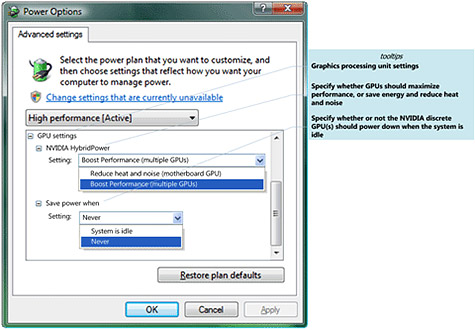

Traditioneel zijn moederborden met een geïntegreerde videocore alleen interessant voor mensen die geen belang hechten aan 3d-prestaties, maar met hybride sli gaat dit veranderen. Wanneer de videokaart niet zwaar belast wordt kan deze uitgezet worden en neemt de chipset het volledig over. Aangezien een snelle videokaart ook in idle-modus nog veel energie verbruikt kan dit resulteren in een aanzienlijke besparing op de elektriciteitsrekening.

Omdat de videokaart volledig uitgezet wordt wanneer de belasting laag is, moet de monitor aangesloten worden op het moederbord. Wanneer er werk aan de winkel is wordt de videokaart ingeschakeld en worden de beelden die weergegeven moeten worden via de pci express-bus naar het systeemgeheugen gekopieerd. Het moederbord zorgt er vervolgens voor dat dit bij het beeldscherm terechtkomt. Naast het besparen van energie kan de onboard gpu ook ingezet worden om de prestaties van een budgetvideokaart te versnellen.

Omdat de videokaart volledig uitgezet wordt wanneer de belasting laag is, moet de monitor aangesloten worden op het moederbord. Wanneer er werk aan de winkel is wordt de videokaart ingeschakeld en worden de beelden die weergegeven moeten worden via de pci express-bus naar het systeemgeheugen gekopieerd. Het moederbord zorgt er vervolgens voor dat dit bij het beeldscherm terechtkomt. Naast het besparen van energie kan de onboard gpu ook ingezet worden om de prestaties van een budgetvideokaart te versnellen.

Nvidia is van plan om de eerste producten die gebruik kunnen maken van de techniek in het eerste kwartaal van 2008 te introduceren. Alle toekomstige producten moeten hybride sli ook gaan ondersteunen, hetgeen betekent dat alle moederborden over geïntegreerde graphics moeten beschikken. De techniek maakt gebruik van enkele features van Windows Vista SP1 en zal initieel niet ondersteund worden door andere besturingssystemen.

AMD werkt overigens aan een gelijksoortige techniek die ook nog aan het begin van dit jaar het daglicht moet zien.

:strip_exif()/i/1123776957.jpg?f=fpa)

/i/1195127112.png?f=fpa)

:strip_exif()/i/1101429863.jpg?f=fpa)