Stroomgebruik kaart gebruikt dus dik 200W netjes als je het vergelijkt met 8800gtx/290xt. pci-e 2.0 kan idd 150W leveren en pci-e1 75W, daarom zijn er dus ook 2x 6/8pins kabels nodig. misschien bij een pci-e2.0 moederbord maar 1kabel nodig, maar wat maakt het uit? er zit heus wel een kabeltje bij zodat je hem op je 12v aansluiting van je voeding kan doen.

nog iets

in de 8pins aansluiting kan ook een 6pins connector (net zoals bij 20/24pins moederbord aansluitingen)

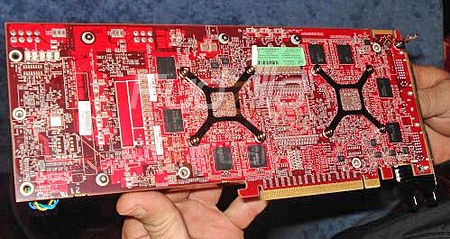

koeling De koeler die erop zit is heftiger als die van de 2900xt dus met de hitte komt het heus wel goed.

Der zit 1grote koeler op de kaart ipv 2 omdat dit gwoon veel beter is.

1: gemakkelijk om de lucht van de kaart buiten de kast te transporteren.

2: 1grote koeler is bijna altijd stiller/beter als 2 kleinere (+neemt minder ruimte in)

3: enz enz.

Prijs hij wordt vast ongeveer 2x zo duur als 2x 3870 in elk geval heus geen 200E duurder.

En Ik weet cker dat je wel prestatie verschil gaat merken op een pci-e2 moederbord als je hem tegenover een pci-e1 moederbord zet. Verschilt per spel +instellingen ofcourse.

pci-e2 geeft nu ook 5%+ meer performance tegenover pci-e1 (met single 3870).

edit: smiley toegevoegt

edit2: @redfish hieronder: Vergelijking met een zuinige duelcore gaat natuurlijk niet op, vergelijk het dan met een hoog geklokte quadcore (125W dus).

En Idle verbruik is ook een stuk verbetert omdat de kaart in 2d automatisch terugklokt in zowel voltage als snelheid. Power Play noemen ze het

Het kan nog zuiniger maar je kan het hoogstwaarschijnlijk met software ook zelf kunt aanpassen itt Nvidia kaarten. Dus een 3870 X2 zou dus met een beetje moeite idle zuiniger kunnen zijn als 1 8800gts. Groot pluspunt imo.

Ben het verder wel met je eens het kan nog veel beter, ik zou graag zien dat mijn pc automatisch switched tussen een onboard gpu en een vette 3dkaart zoals de 3870 X2

[Reactie gewijzigd door Powrskin op 23 juli 2024 09:33]

:strip_exif()/i/1163504062.gif?f=fpa)

/i/1195127112.png?f=fpa)

/i/1122632544.png?f=fpa)