HP en Nanolithosolutions zouden wel eens voor een doorbraak in de chipmarkt kunnen zorgen met een nieuwe lithografietechniek voor de fabricage van computerchips. HP werkt al tien jaar aan deze techniek en is inmiddels aanbeland bij de vierde generatie.

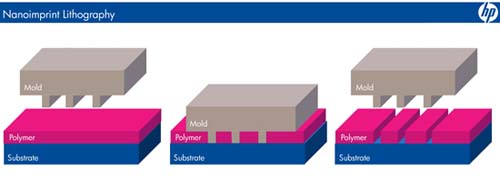

Met deze productietechniek is HP terug bij de roots van de lithografiekunst. In tegenstelling tot de huidige fabricagemethodes wordt bij nano-imprintlithografie geen gebruik gemaakt van licht, maar van een stempel die het gewenste patroon overbrengt op de wafer. De groeven in het kunststof beschermlaagje kunnen tot slechts 50 atomen breed zijn, veel dunner dan wat met conventionele technieken mogelijk is.

De nieuwe vinding is eenvoudig in te bouwen in een optische lithografiemachine. De 'mask aligner' kan binnen tien minuten vervangen worden door de drukvorm met ingebouwde pers, die dan direct in gebruik kan worden genomen. Desondanks denkt Bo Pi, algemeen directeur van Nanolitho, dat chipfabrikanten in eerste instantie de kat uit de boom zullen kijken. 'Chipfabrikanten zijn altijd erg terughoudend met nieuwe lithografietechnieken. Hardeschijffabrikanten zullen waarschijnlijk de early adopters zijn van deze productiemethode'. Deze markt loopt namelijk binnen vijf jaar tegen de grenzen van de huidige technieken aan en zoekt met spoed naar een methode waarmee de opslagcapaciteit ook na 2012 met vijftig procent per jaar kan worden verhoogd. HP is van mening dat zijn techniek uitermate geschikt is voor 'patterned media'-schijven, waar onder andere Hitachi en Fujitsu onderzoek naar doen. Bovendien hoopt HP dat universiteiten de nieuwe lithografietechniek voor onderzoeksdoeleinden zullen kiezen, waarbij met name de lage kosten als een belangrijk verkoopargument worden gezien.

Nanolitho zal niet alleen de techniek verkopen, het bedrijf gaat ook nanomatrijzen aan zijn klanten leveren. De NIL-mastermal is veruit het duurste onderdeel in de drukmachine omdat deze met elektronenbundellithografie wordt vervaardigd. Zodra deze master is gemaakt kan met imprintlithografie een patroon voor een nieuwe matrijs worden geperst. Door de groeven van deze kloon te vullen met vloeibaar metaal ontstaat een nieuwe mal. Inmiddels is de eerste order bevestigd en wordt bij diverse potentiële klanten een bètaprogramma opgezet.

/i/1204897246.png?f=fpa)