In een reeks presentaties op universiteiten heeft Intel zijn visie op de toekomst van de cpu gepresenteerd. Het bedrijf ziet de general-purpose gpu als een bedreiging voor de traditionele cpu.

Intel's chief architect van de Visual Computing Group, Douglas Carmean, heeft de afgelopen weken diverse universiteiten bezocht in de VS waarin hij een presentatie gaf over de toekomst van de gpu en cpu. Hierin legt hij uit waar de plotselinge interesse in gp-gpu's vandaan komt. Volgens Carmean heeft die plotselinge interesse alles te maken met de veranderende architectuur van gpu's waardoor de zeer snelle floating point units van een grafische chip interessant zijn om te gebruiken voor alternatieve toepassingen. De toenemende interesse in gp-gpu's is onder andere toe te schrijven aan 32-bit floating point ondersteuning, grotere shaderprogramma's en de mogelijkheid om ook loops en branches te gebruiken binnen shaderprogramma's.

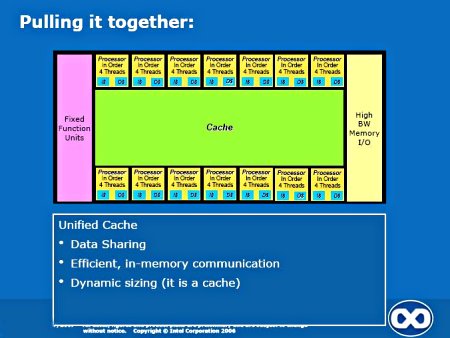

De Visual Computing Group van Intel blijkt plannen te hebben voor een gp-gpu die voorziet in zestien units die met 6,25 watt relatief energiezuinig zijn en in-order instructies kan uitvoeren. Hoewel de individuele units vrij traag zijn, vormen ze samen een potentieel snellere processor, mede dankzij het gedeelde cachegeheugen. Daarnaast worden fixed units toegevoegd die bepaalde bewerkingen zeer snel en efficiënt kunnen uitvoeren. Een dergelijke architectuur zou zowel voor gpu-toepassingen als voor de standaard cpu-toepassingen kunnen worden gebruikt. Dit vereist wel significante aanpassingen aan bestaande compilers en ontwikkeltools, aangezien de aansturing van de gp-gpu anders is dan die van de huidige processors. Een sterk punt van de architectuur is dat het de voordelen van threading combineert met de sterke punten van vector-processors. Threads werken efficienter wanneer er weinig synchronisatie nodig is, terwijl vector-processors geschikter zijn wanneer er wel veel synchronisatie vereist is tussen de verschillende codepaden. Het is duidelijk dat Intel de gp-gpu's als mogelijke bedreiging ziet voor zijn huidige cpu-business, maar aan de andere kant ook zijn best doet om zelf een graantje mee te pikken van deze nieuwe trend.

:strip_exif()/i/1174929063.jpg?f=fpa)

:strip_exif()/i/1166195218.jpg?f=fpa)