Een van de eisen die entertainmentbedrijven kunnen stellen voor het afspelen van een film, is dat een afspeelapparaat voorzien is van hdcp-technologie. Indien dat niet het geval is, kan besloten worden het beeld in een lagere resolutie door te sturen. AnandTech bekeek een collectie videokaarten die aan deze eis voldoen.

Voor de review heeft AnandTech een aantal doelen gesteld. Vooreerst wil men nagaan wat de beste videokaart voor gamers is die volledige hdcp-ondersteuning biedt. Daarnaast wil men ook nagaan hoe het met de videokwaliteit gesteld is en zijn energieconsumptie en geluidsproductie belangrijke onderwerpen. Blu-ray-films worden afgespeeld met een Pioneer BDR-101A en Cyberlinks PowerDVD-software. Niet alleen de videokaart en de speler moeten hdcp ondersteunen, maar ook de drivers moeten hiermee overweg kunnen. Met de laatste Catalyst- en ForceWare-drivers is echter ook die hindernis overwonnen. De hdcp-compatibele tv die als testobject mag dienen is een Westinghouse lvm-42w2.

Voor de review heeft AnandTech een aantal doelen gesteld. Vooreerst wil men nagaan wat de beste videokaart voor gamers is die volledige hdcp-ondersteuning biedt. Daarnaast wil men ook nagaan hoe het met de videokwaliteit gesteld is en zijn energieconsumptie en geluidsproductie belangrijke onderwerpen. Blu-ray-films worden afgespeeld met een Pioneer BDR-101A en Cyberlinks PowerDVD-software. Niet alleen de videokaart en de speler moeten hdcp ondersteunen, maar ook de drivers moeten hiermee overweg kunnen. Met de laatste Catalyst- en ForceWare-drivers is echter ook die hindernis overwonnen. De hdcp-compatibele tv die als testobject mag dienen is een Westinghouse lvm-42w2.

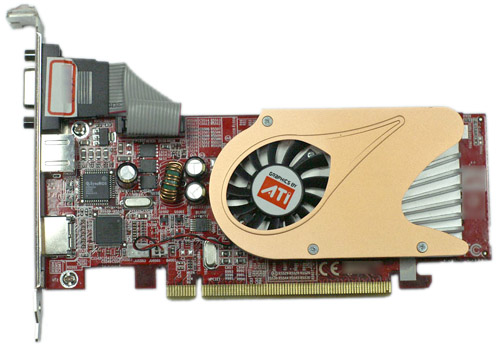

Maar liefst achttien vertegenwoordigers van het nVidia-merk en vier visuele krachtpatsers met een ATi-logo zullen zich in deze review moeten laten gelden. Vier van de gereviewde modellen zijn op het moment van schrijven echter nog niet gelanceerd. Twaalf pagina's lang worden de verschillende merken en modellen voorgesteld, maar daarna gaat men over naar het echte werk. Als opwarmertje krijgen de kaarten - in een Intel D975XBX-moederbord met Core 2 Duo E6300 en 2GB geheugen - een sessie Battlefield 2 te verwerken, gevolgd door een partijtje Oblivion. De resultaten uit deze test zijn weinig verrassend aangezien dit standaardonderdelen zijn van een benchmarksessie voor videokaarten.

Daarna komt echter het echte hdcp-werk en wordt het cpu-gebruik gemeten tijdens het afspelen van een Blu-ray-film. Aangezien de huidige films nog in mpeg-2-formaat gecodeerd zijn, is het nog niet mogelijk een uitgebreid beeld van het processorgebruik te geven. Codecs als VC-1 en H.264 vergen immers veel meer rekenkracht en het is dan ook nog afwachten geblazen hoe de kaarten het er daarmee vanaf zullen brengen. Bij nVidia-kaarten wordt het decoderen van de mpeg-2-stream volledig afgehandeld door de PureVideo-processor, die op zijn beurt gebonden is aan de kloksnelheid van de videocore. Een nVidia-kaart met meer pipelines zal dan ook beter presteren in videospellen, maar dat betekent niet dat ze als beste uit de bus zal komen in deze test. De ATi X1900 XT 256 valt op in positieve zin met een gemiddeld gebruik van 34,2 procent van de cpu-tijd. Bij nVidia zijn de 8800 GTX en 8800 GTS het mildst voor de processor. De slotconclusie voor dit onderdeel is volgens de reviewers echter dat cpu-gebruik weinig invloed zal hebben op de keuze voor deze of gene videokaart.

Ook de energieconsumptiemetingen brengen weinig verrassends boven water. High-end kaarten blijken opvallend meer energie te verbruiken, waarbij de nVidia 8800 GTX zelfs vereist dat er een vervangende voeding gebruikt wordt. Wanneer de industrie meer gebruik gaat maken van VC-1 of H.264, zal er echter beter gebruik gemaakt kunnen worden van hardwarematige acceleratie en dat zou de efficiëntie - en bijgevolg ook het energieverbruik - ten goede moeten komen.

Ook de energieconsumptiemetingen brengen weinig verrassends boven water. High-end kaarten blijken opvallend meer energie te verbruiken, waarbij de nVidia 8800 GTX zelfs vereist dat er een vervangende voeding gebruikt wordt. Wanneer de industrie meer gebruik gaat maken van VC-1 of H.264, zal er echter beter gebruik gemaakt kunnen worden van hardwarematige acceleratie en dat zou de efficiëntie - en bijgevolg ook het energieverbruik - ten goede moeten komen.

Het lijkt er bovendien op dat nVidia-kaarten de opgenomen energie enigszins efficiënter omzetten dan de ATi-modellen. De GeForce-chips worden over het algemeen iets minder warm dan hun concurrenten en ook wat geluidsproductie betreft doen deze videokaarten het niet slecht. De Asus EN7600 GT is dan weer wel de luidruchtigste kaart in het testveld. Het stilste model is de Leadtek Winfast PX7900GS TDH Extreme 520/700.

De conclusie van de reviewers begint duidelijk: de 8800 GTX levert onbetwistbaar de beste prestaties af, gevolgd door de 7950 GX2-kaarten van BFG en EVGA. Vervolgens komt men echter met de nuanceringen aanzetten. Zo leunen ATi-kaarten minder op de cpu tijdens het afspelen van Blu-ray-video, hoewel de 8800 GTX en GTS wel de nVidia-clan blijven aanvoeren. Bovendien zegt deze test niets voer de toekomstgerichtheid van de kaarten, aangezien er nog geen duidelijkheid is over prestaties bij decodering van H.264- of VC-1-materiaal, dat in de toekomst ongetwijfeld mpeg-2-video zal gaan vervangen. Wie hoge eisen stelt op zowel het gebied van gameprestaties als op hdcp-vlak, kan terecht bij de GeForce 8800 GTX, zo besluit de reviewer. Wie hdcp-ondersteuning wil, maar niet al te veel wil uitgeven, kan beter naar de NX 7600 GT kijken.