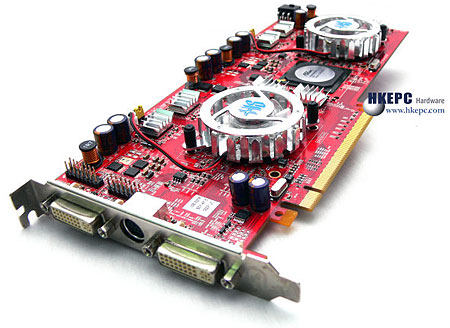

DailyTech bericht dat de ATi RV560 en RV570-chips hun weg zullen vinden richting videokaarten met twee gpu’s. De RV560 en RV570 zijn twee mainstream gpu’s die gebakken zullen worden met een 80nm-procédé en geïntroduceerd zullen worden in augustus. De gpu’s zijn uitgerust met logica om de pixels van twee verschillende kaarten te integreren tot één beeld waardoor een speciale chip hiervoor niet meer nodig is. Om de twee gpu's te laten werken op één kaart wordt gebruik gemaakt van een chip die de bandbreedte van een PCI Express x16-slot deelt door twee. Omdat de RV560 en RV570 mainstream gpu’s zijn zullen de prestaties van de kaart niet op absoluut topniveau komen te liggen, maar omdat er twee gpu’s aanwezig zijn kan de kaart wel een paar extra trucjes. Het is bijvoorbeeld mogelijk om één van de twee gpu’s te gebruiken voor natuurkundige berekeningen of om vier beeldschermen aan te sluiten (bij het gebruik van twee DMS59-aansluitingen). Bekend is dat in ieder geval HIS van plan is om een dual RV570-videokaarten op de markt te zetten.