De jongens van Guru 3d hebben een GeForce 7900 GTX XXX-editie in handen gekregen. Deze kaart is te koop voor 579 euro en is niet meer dan een standaard overgeklokte GeForce 7900 GTX met 512MB werkgeheugen. De videocore tikt daarbij op 700MHz, 50MHz sneller dan de standaardconfiguratie, en het geheugen doet zijn werk op 900MHz in plaats van 850MHz. De XXX uit de typenaam van de videokaart verwijst, tot spijt van wie het benijdt, dan ook enkel naar het eXtreme karakter van de kaart en heeft niets te maken met het weergeven van welgevormde dames.

In de uitgebreide review wordt om te beginnen de technologie uit de gebruikte G71-videocore uit de doeken gedaan. Ook Shader Model 3.0 en HDR komen daarbij aan bod. Na deze technische inleiding is het echter tijd voor de praktijk en begint de reviewer met het uitpakken van de kaart en meegeleverde onderdelen. In de doos vindt men naast de videokaart een S-Video-kabel, twee DVI-VGA-adapters, een kabel voor de stroomtoevoer en een HDTV Component Output Block.

Omdat moderne videokaarten al niet bekend staan om hun zuinigheid en het hier nog eens een overgeklokt exemplaar betreft, gaat de reviewer eerst en vooral aan de slag met een energiemeter. Hiermee meet hij het piekverbruik tijdens een 3DMark05-sessie. Daaruit blijkt dat de videokaart maar liefst 120W voor zijn rekening neemt van de 255W die in totaal door de computer verbruikt wordt. Een 350W-voeding met een minimum van 22A op de 12V-lijnen is dan ook vereist, maar meer is beter. De temperatuur die met een dergelijk verbruik gehaald wordt, klimt bij maximale belasting op tot 69°C, waarbij de koeling opmerkelijk stil blijft, zo stelt de reviewer.

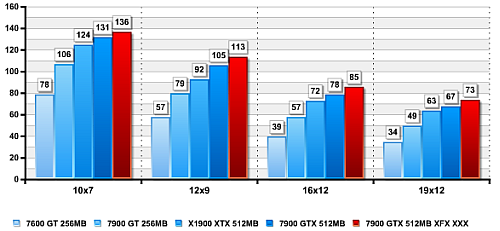

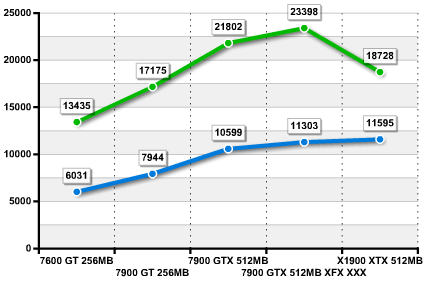

Voor het testen wordt een Gigabyte GA-K8NXP-SLI-moederbord gebruikt, voorzien van een Athlon 64 FX-57+ en 2GB geheugen. Als vergelijkingsmateriaal worden een GeForce 7600 GT en een GeForce 7900 GTX met 512MB ingezet. Het uitgebreide pakket testsoftware bestaat uit Serious Sam 2, Far Cry, Splinter Cell, Splinter Cell 3, Half-Life 2, Half-Life 2: Lost Coast, 3DMark03, 3DMark05, 3DMark06, Aquamark 3, Doom 3, Quake 4, F.E.A.R., Halo: Combat Evolved en X3: Reunion. Acht pagina's lang worden we verwend met screenshots, testconfiguraties en tabellen vol cijfers. Vooraleer over te gaan tot zijn conclusie, probeert de reviewer de kaart nog wat verder over te klokken. Daarbij bereikt de gpu 715MHz en blijft het geheugen steken op 915MHz.

Na het draaien van allerlei benchmarks en het meten van temperaturen en verbruik, komt de reviewer tot het besluit dat de GeForce 7900 GTX XXX snel is, zoals verwacht. Toch is hij niet helemaal zeker of hij de kaart zelf zou kopen. Hoewel de prestaties meer dan uitstekend te noemen zijn, is hij enigszins bezorgd over het feit dat de kaart werkelijk op het toppunt van zijn kunnen draait. Anderzijds is de standaardoverklok wel door de fabrikant uitgevoerd, wat betekent dat de twee jaar garantie geldig blijft. Dat is niet het geval als de gebruiker zelf met zijn kaart gaat klussen. Daartegenover staat dat deze kaart zowel sneller als goedkoper is dan de 7800 GTX met 512MB geheugen, zodat de keuze tussen die types snel gemaakt is.