Bij Tom’s Hardware is een vergelijking verschenen tussen drie Serial ATA RAID-controllers die overweg kunnen met RAID-level 6. RAID 6 gaat een stapje verder dan RAID 5 qua betrouwbaarheid. Wanneer bij een RAID 5-array een schijf de geest geeft is het array kwetsbaar voor gegevensverlies zolang het array niet gerepareerd is, een kans die lineair toeneemt met het aantal schijven in het array. RAID 6 verbetert de betrouwbaarheid door alle pariteitsdata redundant op te slaan waardoor twee schijven de geest kunnen geven voordat het array in gevaar komt. Logischerwijs moet voor deze extra veiligheid wel één schijf aan capaciteit opgeofferd worden.

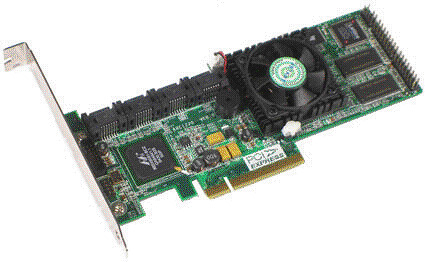

Tom’s Hardware vergelijkt de Adaptec 2820SA, de Areca ARC-1220 en de Promise SuperTrak EX8350, allen Serial ATA RAID-controllers met acht aansluitingen. Het blijkt dat alle drie een goede featureset weten te combineren met prima prestaties. Desondanks kan er maar één de winnaar zijn, en dat is de Areca ARC-1220. Deze controller weet in bijna alle benchmarks de beste prestaties neer te zetten, in standaard omstandigheden en wanneer één of twee schijven ontbraken uit het array. Dit wordt verder gecombineerd met een goede prijs, maar de goedkoopste oplossing is de Areca ARC-1220 echter niet.

:fill(white):strip_exif()/i/1256724812.jpeg?f=thumbmedium)