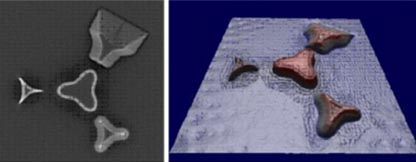

Onderzoekers bij Intel werken momenteel hard aan een technologie om extreem hoge resoluties mogelijk te maken voor opnames. Met het 'computational nanovision'-project wil Intel ons een stapje dichter brengen bij Hollywood-beelden van agenten die onrealistisch veel inzoomen op digitale beelden om zo het missende bewijs te ontdekken. Met computational nanovision wil men afbeeldingen herconstrueren door wiskundige algoritmes toe te passen en ontbrekende of foutieve data in een afbeelding te herstellen. Horst Haussecker, die het project leidt, stelt dat Intel in 2002 al begonnen is met deze technologie met de doelstelling heldere afbeeldingen te kunnen maken van voorwerpen kleiner dan 100nm. Om dit mogelijk te maken probeert zijn team de relatie te begrijpen tussen de eigenlijke structuur van een voorwerp, en de genomen foto. Kleine onvolkomendheden kunnen bijvoorbeeld door artifacts onzichtbaar zijn op een foto, maar wel gereconstrueerd worden.