Softwarebedrijf Microsoft is een project gestart onder de codenaam Boxwood, zo schrijft EE Times. Het doel van dit project is het onderzoeken van de (on)mogelijkheden op het gebied van storage wanneer er gebruikgemaakt wordt van een groot aantal relatief goedkope servers, meerdere honderden, in een cluster. Volgens Michael Schroeder, assistant director bij Microsofts Mountain View onderzoekscentrum dat zich bezighoudt met distributed computing, is het geen eenvoudige taak om dit op een goede manier uit te werken. Schroeder heeft zich al bijna tien jaar met deze materie beziggehouden bij het voormalige Compaq. Hij heeft daar toen samen met zijn collega's een werkbaar systeem ontwikkeld. Dat systeem bleek echter te low-level te zijn omdat ontwikkelaars hun eigen storage allocation maps moesten schrijven. Boxwood is echter op een hoger niveau ontwikkeld waardoor het gebruik eenvoudiger zou moeten zijn.

Om dit te bereiken wordt er gebruikgemaakt van data-abstracties in plaats van logische of virtual disk-abstracties die gebruikt werden in eerdere projecten. Dit stelt de ontwikkelaars in staat om op een hoger niveau dan blokgroottes te specificeren hoeveel ruimte ze nodig denken te hebben. Deze techniek maakt het ook eenvoudiger om load balancing, data prefetching en caching toe te passen. De onderliggende techniek maakt gebruik van variaties op B-Tree-datastructuren genaamd B-Link-trees. Op dit moment heeft Microsoft Boxwood draaien op een klein cluster van 4 pc's. De code is nog niet geoptimaliseerd voor load balancing en fouttolerantie. De onderzoekers zijn nu bezig met een prototype van de software voor een veel groter cluster dat binnen een jaar operationeel moet zijn. Wanneer de onderzoeken positief verlopen zal de kennis uit dit project gebruikt gaan worden in nieuwe generaties van Microsofts storagesoftware.

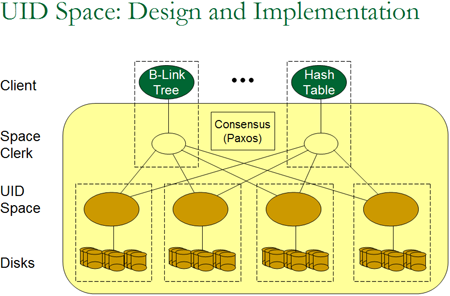

Design en Implementatie van de techniek uit het Boxwood Project

:strip_exif()/i/1303284382.gif?f=fpa)