Een professionele overklokker heeft met behulp van vloeibare stikstof een enkele core van de Threadripper 3990X op 5,55GHz laten draaien. Bij een andere overklok liepen alle cores op een kloksnelheid van 5,3GHz.

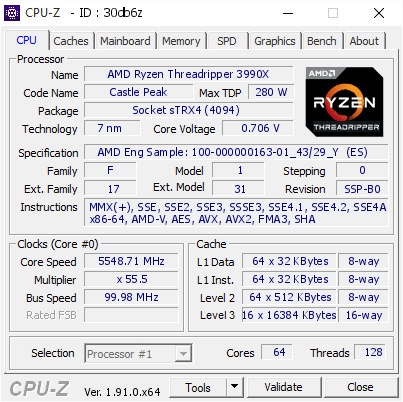

AMD heeft vrijdag de 3990X geïntroduceerd, de eerste processor voor consumenten die 64 cores en 128 threads heeft. Hij verbruikt flink wat stroom, maar er blijkt nog voldoende ruimte voor overklokken te zijn. De professionele overklokker Tsaik heeft een enkele core van dit model zelfs tot 5,55 GHz gekregen, schrijft Hardware Info.

De boostsnelheid van alle 64 cores van de Threadripper 3990X bedraagt bij volle belasting ongeveer 3,1GHz en Tweakers kreeg zijn exemplaar tot 4GHz op alle cores. De 5,55GHz van Tsaik slaat echter op één enkele core. Daarvoor maakte hij gebruik van vloeibare stikstof en slechts een enkele ddr4-module die op ddr4-1866 met cl13-timings draaide. Het gebruikte moederbord was een MSI TRX40 Creator.

Een andere overklokker genaamd Splave heeft alle cores naar 5,3GHz kunnen tillen, ook met de koude, vloeibare stikstof. Deze keer was het moederbord een TRX40 Taichi van ASRock, waar 32GB aan G.Skill's Trident Z Neo ddr4-3200-geheugen op geprikt zat in combinatie met cl11-timings. Om alles te voeden waren wel twee voedingen van 1250 watt nodig. Dit alles resulteerde in een score van 39.518 in de multithreaded test van Cinebench R20. In onze eigen test behaalde de 3990X op stocksnelheden 24.947 punten; de overklok zorgde dus voor een 58 procent hogere score.

/i/2003370120.jpeg?f=imagenormal)

:fill(white):strip_exif()/i/2003353328.jpeg?f=thumbmedium)

:strip_icc():strip_exif()/i/2003369020.jpeg?f=fpa_thumb)

:strip_exif()/i/2003723428.jpeg?f=fpa)

:strip_exif()/i/2001610695.jpeg?f=fpa)

/i/2001237765.png?f=fpa)