Inleiding

AMD heeft de reputatie om met bepaalde innovaties voorop te lopen. Zo wordt gpu-concurrent Nvidia keer op keer verslagen met het overstappen op een nieuw productieprocedé en waren het ook de Radeons die als eerste gddr5-geheugen aan boord kregen.

Met de introductie van DirectX 10 sloeg AMD echter de plank mis. AMD-dochter ATI kwam pas een half jaar na Nvidia met een DirectX 10-kaart die het bovendien ook nog eens aflegde tegen de concurrentie. Drie jaar later lijken de rollen echter weer omgedraaid. Woensdag liggen de eerste DirectX 11-kaarten in de winkel en ze komen uit de stal van ATI. Nvidia's DirectX 11-gpu's zijn in geen velden of wegen te bekennen.

De afgelopen weken heerste er een ware hype omtrent de HD 5870 van AMD. Op ons eigen forum werd de meeste informatie al gelekt, inclusief benchmarkscores die van AMD zelf afkomstig zouden zijn. In dit artikel gaat Tweakers.net niet alleen in op de technische achtergrond van het nieuwe DirectX 11-platform, maar zal de HD 5870 in een reeks benchmarks ook met de snelste videokaarten van de vorige generatie worden vergeleken.

Hoewel AMD met zijn HD 5870 voortborduurt op de architectuur van de RV770-gpu - die voor het overgrote deel weer op de R600-gpu was gebaseerd - is er een hoop veranderd aan de nieuwe kaart -niet in de laatste plaats omdat de gpu gebakken is op het 40nm-procedé.

Behalve DirectX 11 brengt de 5000-serie van ATI ook andere vernieuwingen met zich mee. Zo kunnen er met behulp van ATI Eyefinity zes schermen worden aangestuurd en is de anti-aliasing techniek 'super-sampling', waarmee de beeldkwaliteit een boost kan krijgen, weer terug van weggeweest. Ook het anisotropische filtering-algoritme werd onder handen genomen, wat de beeldkwaliteit eveneens ten goede moet komen. Zo mogelijk nog belangrijker is de vooruitgang die AMD heeft geboekt bij het terugdringen van het energieverbruik in idle-modus.

AMD's sweetspot-strategie

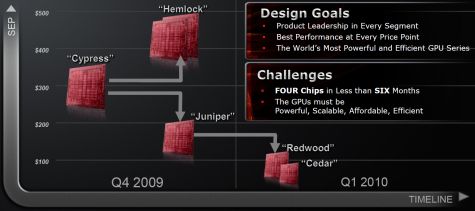

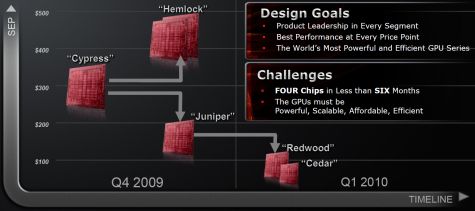

AMD zal in een periode van zes maanden vier verschillende gpu-chips op de markt brengen, waarvan Cypress - de codenaam van de chip waarop de HD 5870 en de HD 5850 zijn gebaseerd - nu de eerste is. AMD heeft met Cypress bewust gekozen voor een relatief kleine chip, die geschikt is voor mainstream en high-end videokaarten. Twee Cypress gpu's moeten de absolute high-end bedienen, terwijl afgeleide van Cypress gebruikt worden voor de budget- en goedkopere mainstreammodellen. Deze AMD-aanpak wordt ook wel de sweetspot-strategie genoemd.

Cypress wordt op een door TSMC ontwikkeld 40nm-procedé gefabriceerd en neemt met zijn 2,15 miljard transistors 334mm2 in beslag. Hoewel dit ruim twee keer zoveel transistors zijn als er op de RV770 zijn te vinden, is de die size met slechts 30 procent toegenomen.

De transitie van 55nm naar 40nm heeft voor AMD nogal wat voeten in de aarde gehad. De fabrikant begon medio 2006 al met de ontwikkeling van de RV740, die als vingeroefening zou dienen voor zowel AMD als TSMC om het 40nm-procedé onder de knie te krijgen door aan het procedé te blijven sleutelen. Uiteindelijk zijn 90 procent van de verbeteringen in RV740 gebruikt, terwijl de resterende 10 procent pas bij Cypress werd toegepast.

Het is nog niet bekend hoe goed of slecht de yields zijn van Cypress. In augustus bleek dat zo'n 75 procent van de gebakken RV740-chips in goede orde van de band rolden. Omdat de die van Cypress een stuk groter is, kan worden aangenomen dat de yields lager liggen. Het is niet ondenkbaar dat AMD als gevolg hiervan gebruikmaakt van harvesting, waarbij de 'afgekeurde' chips alsnog worden ingezet, bijvoorbeeld bij de HD 5850 die geen 1600 maar 1440 streamcores heeft.

Naast Cypress zal AMD dit jaar ook nog Hemlock en Juniper op de markt brengen, begin volgend jaar gevolgd door Redwood en Cedar. Hemlock zal waarschijnlijk de HD 5870X2 worden waarbij twee Cypress-gpu's op één videokaart zijn gezet. Deze videokaart wordt niet eerder dan half oktober verwacht.

Na Hemlock volgt Juniper. Over deze chip heeft AMD eigenlijk nog niets losgelaten. Naar verluidt betreft dit de HD 5700-serie die is voorzien van een 128bit-geheugenbus in combinatie met gddr5- of gddr3-geheugen. Het aantal streamprocessors - of threadprocessors zoals AMD ze nu noemt - zou rond de 800 liggen. Deze serie zal naar verwachting de huidige 4800-serie vervangen.

In het eerste kwartaal van 2010 is AMD van plan om Redwood en Cedar uit te brengen. Bij deze gpu's ligt de nadruk vooral op een zo laag mogelijk energieverbruik en minder op gaming.

Cypress: opgebouwd in blokjes

Cypress beschikt over 1600 streamcores. Voordat informatie de streamcores bereikt, heeft het technisch al een flinke route in de gpu afgelegd. Het begint allemaal bij de command processor, waar de driver calls binnen komen. Van daaruit vindt de data zijn weg naar de graphics engine, waarin zich de rasterizer, de geometry assembler en de vertex assembler bevinden.

De rasterizer levert de threads voor de pixel shaders, terwijl de geometry en de vertex assembler respectievelijk in threads voorzien voor de geometry en de vertex shaders. Ten opzichte van RV770 zijn er nu twee rasterizers aanwezig in plaats van slechts een. Het is niet duidelijk of de rasterizers tile-based hun werk doen of dat ze elk een eigen vaste deel van het te renderen beeld hebben (onder/boven, links/rechts). Niet helemaal nieuw maar toch zeer belangrijk is de tesselator, die nu verplicht onderdeel is van DirectX 11-hardware.

Alle threads vinden hun weg naar de ultra threaded dispatch processor, die tot wel enkele duizenden threads tegelijk in de gaten houdt en die al dan niet doorstuurt naar één van de 320 thread processors. De dispatch processors wordt op deze manier overgesimplicificeerd, want in feite is het een zeer complex stukje hardware, waar de effectieve werking van de processing engine mee kan vallen of staan.

De gehele processing engine ziet er vervolgens op deze manier uit. In totaal zijn er twintig single instructions multiple data-engines, die elk weer opgebouwd zijn uit 16 thread-processors, die weer uit 5 streamcores bestaan. Uiteindelijk kan AMD dan claimen dat de gpu 1600 streamcores aan boord heeft.

De threaded processor van dichtbij

De 320 threaded processors bestaan elk uit vijf alu's, die met een aantal verschillende instructies overweg kunnen. Eén van deze alu's is een special function unit. Deze sfu kan alles wat de andere alu's ook kunnen, maar kan aanvullend ook overweg met transcendentale instructies. AMD noemt de alu's stream cores.

Hoewel er tot hier nog niets wezenlijks is veranderd ten opzichte van RV770, zijn de streamcores wel op enkele punten verbeterd ten opzichte van die uit de RV770-gpu. Deze aanpassing moet de totale hoeveelheid instructies per clockcycle verhogen, al is AMD niet erg scheutig met details.

Opvallendste verbetering is waarschijnlijk de mogelijkheid om in dezelfde klokcycle een multiplicatie uit te voeren, die afhankelijk is van een add die ook nog uitgerekend moet worden. Hierdoor kunnen de stream cores efficiënter gebruikt worden. AMD voegde tevens de fused mad-instructie toe. Deze instructie is over het algemeen sneller dan eerst het uitvoeren van een multiply gevolgd door een add. Doordat er maar één keer een afronding plaatsvindt, is de fused mad ook nauwkeuriger. Er werden tevens DirectX 11 bit-level operations toegevoegd evenals de sad-instructie, sum of absolute differences, die vooral bruikbaar kan zijn bij video-encoding.

Door streamcores kunnen hooguit 1600 berekeningen tegelijk afhandelen. In de praktijk is dit echter nagenoeg niet haalbaar. De vijf streamcores kunnen namelijk alleen tegelijk actief zijn als ze exact dezelfde bewerking uitvoeren. In het ergste geval is er per clockcycle dus slechts één stream core actief, terwijl de andere niets doen. In de meest optimale situatie zijn alle vijf de stream cores actief waarbij een theoretische piek van 2,72 teraflops kan worden gehaald. Het aantal double precision flops ligt op 544 gigaflops.

Texture units en texture filtering

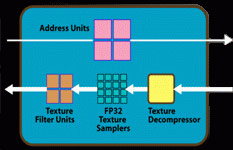

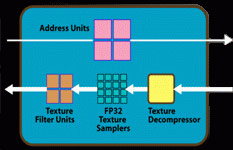

Behalve de verdubbeling van het aantal streamcores, heeft AMD ook het aantal texture units verdubbeld, van tien naar twintig. AMD lijkt deze texture units nauwelijks aangepast te hebben, aangezien ze op 68 miljard bilinear gefilterde texels per seconde uitkomen. Dat betekent dat er per texture unit vier texture filtering units zijn, wat goed is voor een totaal van tachtig texture filtering units.

Behalve de verdubbeling van het aantal streamcores, heeft AMD ook het aantal texture units verdubbeld, van tien naar twintig. AMD lijkt deze texture units nauwelijks aangepast te hebben, aangezien ze op 68 miljard bilinear gefilterde texels per seconde uitkomen. Dat betekent dat er per texture unit vier texture filtering units zijn, wat goed is voor een totaal van tachtig texture filtering units.

AMD hanteert een ratio van vier thread processors voor elke texture filtering unit. De nadruk ligt met deze 4:1-ratio meer op de compute-kant dan op de texture-kant. Nvidia hanteert met zijn GT200-architectuur een iets conservatievere 3:1-ratio, maar neigt evengoed meer naar de compute- dan de texture-kant. Dit is overigens niet altijd zo geweest: enkele jaren geleden lag de ratio bij Nvidia nog op 2:1.

Naast elke texture unit, bevindt zich een L1 texture-cache, die via de data request bus communiceert met een L2-cache. De L2-cache bevindt zich direct naast de memory controller om de communicatielijntjes kort te houden. De L1-cache heeft een texture fetch-bandbreedte van 1TB/s, ten opzichte van 480GB/s bij de RV770-gpu. Het dataverkeer tussen de L1- en L2-cache heeft een bandbreedte van 435GB/s ten opzichte van 384GB/s bij RV770. De grootte van de L1-cache is niet bekend, maar de L2-cache zou een verdubbeling hebben gehad van 64kB per blok naar 128kB per blok.

De texture units zijn ook uitgerust met een nieuwe anisotropic filtering algorithme. De kijkhoek doet er niet meer toe, waardoor er op nagenoeg perfecte wijze aniosotropic filtering toegepast kan worden. Het nieuwe algorithme zou niet meer rekenkracht vergen dan het voorgaande algorithme.

In de animatie valt te zien dat de voorgaande generatie in de vorm van de HD 4890 het moest doen met een vrij ruw algorithme, terwijl de GTX295 al een betere vorm van anisotropic filtering had. De HD 5870 doet er nog een schepje bovenop, door perfecte rondingen weer te geven.

De render back-ends

De rode draad bij Cypress zal ondertussen wel duidelijk zijn: AMD heeft waar mogelijk geprobeerd om alle rekeneenheden te verdubbelen. De render back-ends, ook wel bekend als rop's of raster processors, zijn ook verdubbeld. Bij elk van de vier geheugencontrollers bevinden zich nu twee rbe's om de rasterization-bewerkingen, zoals anti-aliasing, maar ook het uitlezen van de z-buffer en de stencil-buffer, af te handelen.

Ten opzichte van RV770 betekent de verdubbeling dat het aantal pixels dat verwerkt kan worden zowel met als zonder multi-sampling anti-aliasing is verdubbeld. Door de verdubbeling van het aantal rbe's heeft AMD tevens besloten om super-sampling anti-aliasing terug te laten keren, dat sinds de 8500-serie niet meer gebruikt kon worden. Deze ssaa-modus vergt veel rekenkracht en kan waarschijnlijk alleen op oudere games toegepast worden. Doordat de anti-aliasing op zowel de shaders als de textures en de polygoon-randen wordt toegepast, zal de beeldkwaliteit drastisch toenemen.

AMD's supersampling-techniek werkt niet op basis van oversampling, zoals de oude supersampling-techniek. Bij de oude techniek wordt het beeld op een veel hogere resolutie gerendered, om de resolutie vervolgens weer te verlagen naar de weer te geven resolutie. AMD maakt daarentegen gebruik van sample rate-shading: elke pixel wordt meerdere keren gerendered, maar het midden van de pixel wordt telkens verplaatst waardoor er een sample pattern ontstaat. De resultaten van elke sample worden verzameld, om uiteindelijk één kleur te vormen. De ssaa-modus kan gecombineerd worden met AMD's custom filter anti-aliasing. Alle berekeningen vinden plaats op de rbe's: alleen in combinatie met cfaa wordt er gebruikgemaakt van shaders.

De tesselator

De tesselator bevindt zich in de graphics engine en kan het aantal polygonen van een model drastisch verhogen, waardoor het eindresultaat een stuk gedetailleerder wordt. De tesselator bevond zich ook al in R600, RV670 en RV770, maar was nooit onderdeel van de Direct X-specificatie. Met DirectX 11 is daar verandering in gekomen. De tesselator kan aangesproken worden door middel van de Domain en Hull-shader, beide nieuwkomers in de DirectX 11-specificatie.

:fill(white)/i/1253564094.jpg?f=thumb)

:fill(white)/i/1253564092.jpg?f=thumb)

:fill(white)/i/1253564095.jpg?f=thumb)

:fill(white)/i/1253564093.jpg?f=thumb)

Het eerste dak is een simpel model, met weinig polygonen, waar enkele textures overheen gelegd zijn. Het tweede model heeft het eerste model als uitgangspunt, maar door middel van tesselation is het aantal polygonen dramatisch verhoogd. Het simpelweg toevoegen van triangles in de reeds bestaande driehoeken heeft weinig nut. De tesselator kan de bestaande driehoeken echter later onderverdelen in veel meer kleinere driehoeken op basis van wiskundige formules, zoals Béziercurves. Door middel van displacement mapping wordt er nog meer detail toegevoegd in de vorm van relief.

Behalve een flinke vooruitgang in de hoeveelheid detail is tesselation ook nog eens zeer efficiënt. De geheugen footprint kan met een low-polygon-model een fractie van een megabyte zijn, terwijl een model met evenzoveel polygonen als een getesseleerd model meerdere tientallen megabytes in beslag zou kunnen nemen. Om het onnodig renderen van een grote hoeveelheid driehoeken tegen te gaan kan de mate van tesselation ook aangepast worden naargelang het te renderen object verder weg of juist dichterbij is. Een object dat zich dichtbij bevindt is goed zichtbaar en het extra detail is dan ook goed te zien. In de verte is dat echter minder van belang, omdat het toch niet te onderscheiden is.

Direct Compute

Behalve de tesselator is ook Direct Compute 5.0 een vereiste voor DirectX 11-videokaarten. Direct Compute is een open standaard waarmee de gpu ingezet kan worden voor general purpose-applicaties. De mogelijkheden variëren van artifical intelligence en physics tot meer grafisch gerelateerde opties zoals image post processing en order independant transparancy. Vooral order independent transparancy biedt visuele effecten die eerder niet mogelijk waren met videokaarten.

In de DirectX-pijplijn bevindt de compute shader zich helemaal aan het eind. Het beeld wordt eerst helemaal berekend en samengesteld, waarna een compute shader wordt toepast. Uiteindelijk wordt dan het beeld weergegeven op het beeldscherm.

Tijdens een persevenement in Londen werd order independant transparancy vrij eenvoudig omschreven. Zo zouden de ontwikkelaars van Blizzard maar al te graag een doorzichtige draak renderen in een stromende rivier die ook nog eens vuur uit spuwt. Daar zijn tal van transparante textures voor nodig en overlappende transparante textures konden niet realistisch gerendered worden. De techniek alpha-blending doet een poging, maar komt niet in de buurt van de resultaten die er neergezet kunnen worden met order independent transparency. Het verschil tussen beide onderstaande plaatjes spreekt voor zich. Behalve deze DX11-demo, waren er geen andere DirectX 11-functies die getest konden worden.

:fill(white)/i/1253660094.jpeg?f=thumb)

:fill(white)/i/1253660095.jpeg?f=thumb)

ATI Eyefinity: de doodsteek voor Matrox

Videokaarten konden over het algemeen maximaal twee beeldschermen tegelijk aansturen, op enkele videokaarten na die meer dan één gpu aan boord hebben. ATI Eyefinity is de benaming voor AMD's techniek om maar liefst zes beeldschermen tegelijk aan te sturen.

Het reference design van HD 5870 heeft twee dual-link dvi-poorten, een hdmi- en een displayport-uitgang. Daarmee is het mogelijk om maximaal drie beeldschermen aan te sturen. Het theoretische maximum zou op 8192x8192 pixels liggen, maar met drie 30"-beeldschermen op rij, met een resolutie van 2560x1600, is 7680x1600 pixels de hoogst haalbare resolutie, althans totdat AMD de HD 5870 Six, met zes mini-display-poorten, introduceert. Overigens is het ook mogelijk om twee HD 5870's te gebruiken, maar slechts één van de videokaarten voorziet de beeldschermen dan ook daadwerkelijk van pixels. CrossfireX werkt dus nog niet, iets waar het Catalyst-team hard aan zou werken.

De displayport-uitgangen zijn de sleutel tot de nieuwe Eyefinity-techniek omdat één clock-generator meerdere displayport-uitgangen kan aansturen. Tevens zou het aantal pinnen dat in beslag wordt genomen gelijk zijn aan een single link dvi-poort, terwijl de bandbreedte veel hoger ligt. Een vga-uitgang daarentegen vereist een dac, die energie verbruikt en ruimte inneemt op de die. Een dvi-uitgang heeft op zijn beurt een toegewijde clock-generator nodig en zou volgens AMD te veel input/output-pinnen van de gpu in beslag nemen.

Met behulp van Eyefinity zijn er tal van mogelijkheden voor beeldscherm-opstellingen. Behalve voor toepassingen op kantoor is het gebruik van meerdere beeldschermen ook bij geschikt voor games. Matrox richt zich op een niche-markt met zijn Dualhead2go en de Triplehead2go, maar ziet die nu feitelijk overbodig geworden. AMD testte ATI Eyefinity reeds in tal van games, die zonder problemen resoluties als 5760 bij 2160 pixels herkenden. De rekenkracht die daarvoor nodig is moet echter niet onderschat worden. Zelfs drie 1680x1050-schermen hebben al ongeveer 30 procent meer pixels dan een enkel 2560x1600-beeldscherm.

Helaas!

Helaas!

De video die je probeert te bekijken is niet langer beschikbaar op Tweakers.net.

Testsysteem

Het testsysteem is opgetrokken rond een Core i7 920-processor, die voor deze review op 3,8GHz werd geklokt door de bclk tot 180MHz te verhogen. We streven ernaar om altijd de nieuwste drivers te gebruiken, en als er bèta-drivers gebruikt zijn, wordt dat vermeld. Bij deze review zijn de ATI-kaarten met versie 9.9 van de Catalyst-drivers aangestuurd en de Nvidia-kaarten met versie 190.62 van de Nvidia-drivers. Voor de benchmarks zijn de volgende games van de plank gehaald: Call of Duty: World at War, Crysis: Warhead, Far Cry 2, Stalker: Clear Sky, Race Driver: GRID, Tom Clancy's H.A.W.X en Batman: Arkham Asylum. Ook van deze games zijn, voor zover beschikbaar, alle patches geïnstalleerd. Indien mogelijk is van de interne benchmarks van de games gebruikgemaakt.

| Testsysteem |

| Moederbord |

EVGA X58 Classified

|

| Processor |

Intel Core i7 920 @ 3,8GHz |

| Geheugen |

6GB ddr3: 3x OCZ3X1333LV6GK 8-8-8 |

| Harde schijven |

500GB Samsung Spinpoint F1 HD502IJ |

| Videokaarten |

Asus HD 5870

Asus GTX 295

Asus GTX 285

Asus HD 4870X2

Asus HD 4890

|

| Koeler |

Thermalright Ultra Extreme 120

|

| Voeding |

Corsair 850HX

|

Intels X58-platform zal naar verwachting nog geruime tijd de prestatiekroon in handen houden. Dit platform zal bij het uitvoeren van de benchmarks niet snel een bottleneck vormen. Ook biedt het platform de mogelijkheid om videokaarten in sli- en in CrossFire-modus te draaien.

Elke game is getest op de resoluties 1680x1050, 1920x1200 en 2560x1600. De instellingen verschillen per game en zullen daarom telkens vermeld worden. In principe wordt altijd anti-aliasing toegepast, tenzij dit resulteert in onspeelbaar lage framerates. Hetzelfde geldt voor sommige ingame-settings, die naar beneden worden bijgesteld als de videokaart anders onvoldoende fps produceert. Ook wordt er altijd 16xAF toegepast, behalve bij HAWX; bij games die dat niet ondersteunen is deze instelling afgedwongen met behulp van ATI's CCC of Nvidia's Control Panel.

In het Catalyst Control Center staat de adaptive aliasing op multi-sampling, wordt de toepassing van AA/AF waar mogelijk aan de applicatie overgelaten, en is mipmapping op de hoogste kwaliteit ingesteld. In Nvidia's Control Panel staat de anti-aliasing transparancy-modus op multisampling en is de texture quality op high quality ingesteld. Ook hier wordt AA/AF waar mogelijk door de applicatie verzorgd.

Bij alle tests wordt zowel het minimale als het gemiddelde aantal frames per seconde gegeven, waarbij een hogere score uiteraard altijd beter is.

Call of Duty: World at War

Voor de benchmark met Call of Duty: World at War zijn er - bij gebrek aan een ingebouwde benchmark - handmatige runs uitgevoerd in het eerste level.

| Call of Duty: World at War - 1680x1050 - Maximum - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

*******

+

**

73,2 / 90,3 |

| HD 5870 |

******

+

**

60,3 / 84,4 |

| HD 4870X2 |

*****

+

**

58,0 / 81,9 |

| GTX 285 |

*****

+

***

54,3 / 80,4 |

| HD 4890 |

***

+

**

36,7 / 59,4 |

World at War is al sinds tijden een titel waarin Nvidia-kaarten domineren. Zelfs de HD 5870 kan Nvidia's machtspositie niet doorbreken, maar laat wel zien dat het een kaart is om serieus te nemen door HD 4870X2 te verslaan.

| Call of Duty: World at War - 1920x1200 - Maximum - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

******

+

***

62,8 / 88,8 |

| HD 5870 |

*****

+

***

51,6 / 77,7 |

| HD 4870X2 |

*****

+

***

49,0 / 75,7 |

| GTX 285 |

****

+

**

47,8 / 69,8 |

| HD 4890 |

***

+

**

32,0 / 54,2 |

Op 1920x1200 laat de HD 5870 nogmaals zijn spierballen zien. De resultaten beloven wat voor andere spellen, aangezien de HD 5870 nu al goed mee kan komen met de GTX 295. Ten opzichte van de vorige generatie, de HD 4890, is de HD 5870 bijna 1,5 keer zo snel.

| Call of Duty: World at War - 2560x1600 - Maximum - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

*****

+

****

43,3 / 77,7 |

| HD 4870X2 |

****

+

***

33,2 / 57,5 |

| GTX 285 |

****

+

**

34,0 / 51,6 |

| HD 5870 |

***

+

**

31,2 / 46,8 |

| HD 4890 |

**

+

**

19,7 / 33,8 |

Bij de allerhoogste resolutie moet de HD 5870 het - hoewel marginaal - afleggen tegen zowel de HD 4870X2 als de GTX285. Hier is niet echt een verklaring voor: de HD 5870 werd op alle fronten verbeterd, waardoor een tekort aan bandbreedte of texture throughput uitgesloten kunnen worden.

Race Driver: GRID

Race Driver: GRID is al sinds tijden een van de mooiere race-spellen op de computer. Binnenkort zal GRID afgelost worden door ofwel DIRT 2 of Need for Speed: Shift, maar voor deze review werden nog gewoon enkele rondes gereden op het Long Beach-circuit in GRID.

Op de laagste resolutie zijn de HD 5870 en de HD 4870X2 aan elkaar gewaagd. De minima liggen iets hoger, terwijl de gemiddelde fps iets lager ligt. De GTX285 wordt met gemak verslagen. Ten opzichte van de HD 4890 zien we een verbetering van ongeveer 50 procent.

| Race Driver: Grid - 1920x1200 - Maximum - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 4870X2 |

******

+

**

94,4 / 124,8 |

| GTX 295 |

******

+

**

94,2 / 122,3 |

| HD 5870 |

*******

+

**

98,6 / 121,8 |

| HD 4890 |

*****

+

*

68,5 / 84,3 |

| GTX 285 |

****

+

*

67,0 / 84,1 |

Op 1920x1200 weet de GTX295 iets van zijn achterstand goed te maken, maar de drie videokaarten zijn nagenoeg even snel. Niet slecht voor een videokaart, die zoals later zal blijken, veel minder verbruikt.

| Race Driver: Grid - 2560x1600 - Maximum - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 4870X2 |

*******

+

**

73,4 / 93,1 |

| GTX 295 |

******

+

**

72,0 / 87,3 |

| HD 5870 |

******

+

**

67,8 / 84,7 |

| HD 4890 |

****

+

*

46,0 / 57,6 |

| GTX 285 |

****

+

*

46,3 / 57,6 |

Op 2560 bij 1600 beeldpunten worden de jongens van de mannen gescheiden. De HD 5870 loopt nu iets achter op de GTX 295 en de HD 4870X2. Hieruit blijkt dat het hebben van twee gpu's soms toch voordelen heeft, waardoor we vermoeden dat de HD 5870 toch baat zou hebben bij meer geheugenbandbreedte.

Crysis Warhead

Een van de meest voorkomende vragen is met welke videokaart Crysis in volle glorie gespeeld kan worden. De HD 5870 waagt in deze review een poging tijdens een aantal testruns met Crysis Warhead.

| Crysis Warhead - 1680x1050 - Enthusiast - 0xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

*******

+

**

34,3 / 41,7 |

| HD 4870X2 |

******

+

**

28,2 / 35,3 |

| HD 5870 |

*****

+

**

26,7 / 33,9 |

| GTX 285 |

*****

+

*

22,6 / 27,4 |

| HD 4890 |

****

+

*

19,0 / 23,8 |

Op de laagst geteste resolutie gaat het meteen mis. De HD 5870 moet het tegen zowel de HD 4870X2 als de GTX 295 afleggen. De GTX295 steekt wel met kop en schouders boven de rest uit. Ten opzichte van de HD 4890 boekt de HD 5870 minder winst dan verwacht.

| Crysis Warhead - 1920x1200 - Enthusiast - 0xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

*******

+

**

27,2 / 34,3 |

| HD 4870X2 |

*****

+

***

21,7 / 32,7 |

| HD 5870 |

*****

+

**

22,3 / 28,6 |

| GTX 285 |

*****

+

*

18,6 / 23,2 |

| HD 4890 |

****

+

*

16,3 / 20,6 |

Op 1920x1200 kan de HD 5870 iets beter meekomen met de HD 4870X2, maar de GTX 295 blijft heer en meester. De HD 5870 stelt enigszin teleur in Crysis Warhead.

| Crysis Warhead - 2560x1600 - Enthusiast - 0xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

******

+

**

17,7 / 23,4 |

| HD 4870X2 |

******

+

**

16,3 / 21,6 |

| HD 5870 |

*****

+

**

14,5 / 18,8 |

| GTX 285 |

****

+

*

12,0 / 14,5 |

| HD 4890 |

****

+

*

10,3 / 13,0 |

2560 bij 1600 beeldpunten is te veel van het goede voor alle geteste videokaarten. Ook hier weet de HD 5870 geen records te breken.

Far Cry 2

Far Cry 2 is een van de weinige games waarin nog steeds gebruikgemaakt wordt van dezelfde benchmark. De ingebouwde benchmarker voorziet in een aantal runs van de Small Ranch-benchmark, waarbij alle settings op zijn hoogst staan terwijl 4xAA en 16xAF zijn ingeschakeld.

| Far Cry 2 - 1680x1050 - Ultra high - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

******

+

**

65,6 / 85,4 |

| HD 5870 |

*****

+

**

55,9 / 75,3 |

| HD 4870X2 |

*****

+

**

53,6 / 73,7 |

| GTX 285 |

****

+

*

45,6 / 58,6 |

| HD 4890 |

***

+

*

35,3 / 46,1 |

De HD 5870 verslaat de HD 4870X2. Hoewel dit niet helemaal onverwacht is, beide kaarten beschikken immers effectief over evenveel streamcores, is het een toch prestatie op zich. Het verschil ten opzichte van de HD 4890 bedraagt ruim 50 procent.

| Far Cry 2 - 1920x1200 - Ultra high - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

******

+

**

58,4 / 77,8 |

| HD 4870X2 |

*****

+

**

47,3 / 67,5 |

| HD 5870 |

*****

+

**

47,3 / 66,2 |

| GTX 285 |

****

+

*

41,0 / 52,7 |

| HD 4890 |

****

+

*

32,9 / 43,6 |

De HD 4870X2 en de HD 5870 zijn wederom zeer aan elkaar gewaagd. Het verschil ten opzichte van de GTX 285 stelt wel enigszin teleur.

| Far Cry 2 - 2560x1600 - Ultra high - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 4870X2 |

*****

+

***

31,2 / 48,8 |

| HD 5870 |

*****

+

***

31,8 / 46,0 |

| GTX 295 |

****

+

***

24,4 / 40,4 |

| GTX 285 |

*****

+

**

29,7 / 39,7 |

| HD 4890 |

***

+

**

19,9 / 29,0 |

De GTX 295 stort helemaal in op 2560x1600. Zelfs de GTX 285 heeft hogere minima. De HD 5870 doet niet onder voor de HD 4870X2, maar de GTX 285 komt wel erg dicht in de buurt. Het lijkt erop dat er een limiterende factor is, maar die is niet zomaar aan te wijzen. Geheugenbandbreedte is, zoals eerder geopperd, een mogelijkheid.

Tom Clancy's: HAWX

In Tom Clancy's: HAWX wordt ook gebruikgemaakt van de ingebouwde benchmark. Anisotropic filterering is uitgeschakeld omdat dit een onevenredig grote performance-hit oplevert bij ATI-kaarten. AF wordt van nature ook niet door HAWX ondersteund, waardoor het forceren van AF met behulp van de drivers geen garantie biedt.

| Hawx - 1680x1050 - Maximum - 4xAA/0xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 4870X2 |

******

+

**

84,3 / 113,5 |

| GTX 295 |

******

+

**

87,2 / 112,1 |

| HD 5870 |

*****

+

*

74,6 / 85,7 |

| HD 4890 |

****

+

*

56,4 / 72,4 |

| GTX 285 |

****

+

*

54,5 / 68,7 |

In HAWX moet de HD 5870 de HD 4870X2 en de GTX 295 aan zich voorbij laten gaan, en ruim ook. Het verschil ten opzichte van de HD 4890 is aanzienlijk, maar lang geen 50 procent zoals in veel andere benchmarks.

| Hawx - 1920x1200 - Maximum - 4xAA/0xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 4870X2 |

******

+

**

79,6 / 106,4 |

| GTX 295 |

******

+

**

76,0 / 93,6 |

| HD 5870 |

****

+

*

63,3 / 78,8 |

| HD 4890 |

****

+

*

47,3 / 62,7 |

| GTX 285 |

***

+

*

42,0 / 58,8 |

Hetzelfde resultaat herhaalt zich op 1920x1200: het verschil tussen de 5870 en de 4890 neemt zelfs af naar ongeveer 33 procent.

| Hawx - 2560x1600 - Maximum - 4xAA/0xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 4870X2 |

*****

+

***

49,0 / 74,8 |

| GTX 295 |

*****

+

**

48,2 / 64,9 |

| HD 5870 |

****

+

**

44,2 / 59,6 |

| HD 4890 |

***

+

**

28,2 / 42,8 |

| GTX 285 |

***

+

**

27,2 / 39,8 |

De HD 5870 weet iets van zijn achterstand goed te maken en is nu net geen 50 procent sneller dan de HD 4890. In HAWX hadden we meer verwacht van de DirectX 11-kaart.

Stalker: Clear Sky

Net zoals Crysis Warhead is Stalker: Clear Sky een echte videokaart-killer. Met de hoogste instelling worden zelfs de snelste videokaarten op hun knieën gedwongen, waardoor een sli of CrossfireX-setup bijna noodzakelijk is. Met handmatige testruns kijken we hoe het de HD 5870 vergaat.

| Stalker: Clear Sky - 1680x1050 - High - 0xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

******

+

***

29,2 / 42,3 |

| HD 4870X2 |

******

+

**

32,0 / 39,6 |

| HD 5870 |

*****

+

**

27,7 / 38,8 |

| GTX 285 |

****

+

**

22,6 / 30,8 |

| HD 4890 |

****

+

*

20,3 / 25,8 |

De drie crème-de-la-crème-kaarten weten stuk voor stuk speelbare framerates tevoorschijn te toveren, al is het maar net aan. De HD 5870 kan aardig meekomen, maar overtuigt alleen als er gekeken wordt naar het verschil van zo'n 50 procent met de HD 4890.

| Stalker: Clear Sky - 1920x1200 - High - 0xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 4870X2 |

*******

+

**

29,0 / 37,2 |

| GTX 295 |

******

+

**

26,2 / 34,5 |

| HD 5870 |

*****

+

**

23,3 / 33,4 |

| GTX 285 |

****

+

**

18,8 / 25,4 |

| HD 4890 |

****

+

*

17,2 / 21,8 |

De HD 4870X2 zet een sterke prestatie neer, terwijl de GTX 295 behoorlijk afzwakt. De HD 5870 laat nu wel en erg groot gat vallen en ook het verschil met de HD 4890 neemt af.

| Stalker: Clear Sky - 2560x1600 - High - 0xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 4870X2 |

******

+

**

17,0 / 23,3 |

| GTX 295 |

******

+

***

15,4 / 22,6 |

| HD 5870 |

******

+

**

17,6 / 22,3 |

| GTX 285 |

*****

+

*

12,9 / 16,1 |

| HD 4890 |

****

+

*

11,0 / 13,9 |

Pas op de allerhoogste resolutie weet de HD 5870 zich positief te onderscheiden. De minima zijn het hoogst van alle videokaarten en de gemiddelden zijn slechts marginaal lager.

Batman: Arkham Asylum

Batman: Arkham Asylum is een nieuwe benchmark. Het spel is een port van de consoles naar de pc en er wordt gebruikgemaakt van de populaire Unreal 3 Engine. Het spel is een zogenaamde The Way it's Meant to be Played-titel van Nvidia. AMD heeft al te kennen geven dat het de performance van zijn kaarten tegen vindt vallen, waardoor er in de toekomst misschien patches komen voor betere prestaties.

Het spel werd getest met 4xAA en met 8xAA en 8xqAA in het geval van Nvidia, zodat het aantal samples identiek is aan dat van ATI.

| Batman: Arkham Asylym - 1680x1050 - Max - xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

****

+

*****

88,0 / 181,0 |

| GTX 295 8xAA |

***

+

***

75,7 / 139,7 |

| HD 4870X2 |

****

+

***

76,7 / 132,0 |

| GTX 285 |

***

+

***

72,0 / 128,3 |

| HD 5870 |

***

+

**

72,7 / 115,7 |

| HD 5870 8xAA |

***

+

***

62,3 / 115,7 |

| HD 4870X2 8xAA |

***

+

***

61,3 / 111,0 |

| GTX 285 8xAA |

***

+

**

55,0 / 98,7 |

| HD 4890 |

***

+

*

55,0 / 80,0 |

| HD 4890 8xAA |

**

+

*

45,7 / 70,0 |

De HD 5870 moet het met 4xAA afleggen tegen de GTX 285. Daar staat tegenover dat de HD 5870 met 8xAA sneller is dan zowel de HD 4870X2 als de GTX 285. Het verdubbelen van de render back-ends heeft ervoor gezorgd dat 8xAA nauwelijks invloed heeft op de framerates.

| Batman: Arkham Asylym - 1920x1200 - Max - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

*****

+

****

83,3 / 150,7 |

| HD 4870X2 |

***

+

***

61,0 / 105,7 |

| GTX 285 |

***

+

***

61,3 / 104,7 |

| GTX 295 8xAA |

***

+

**

53,7 / 92,3 |

| HD 4870X2 8xAA |

***

+

**

51,7 / 91,3 |

| HD 5870 |

***

+

**

59,7 / 90,0 |

| HD 5870 8xAA |

***

+

**

56,3 / 86,7 |

| HD 4890 |

***

+

*

46,6 / 65,0 |

| GTX 285 8xAA |

**

+

**

38,7 / 64,0 |

| HD 4890 8xAA |

**

+

*

37,0 / 56,0 |

De GTX 295 is wederom te sterk voor al zijn opponenten. De HD 5870 presteert echter nog vrij aardig, met redelijk hoog minima. Vooral met 8xAA laat de HD 5870 zijn kracht zien ten opzichte van de HD 4890.

| Batman: Arkham Asylym - 2560x1600 - Max - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 295 |

*****

+

***

51,7 / 82,0

|

| HD 4870X2 |

****

+

***

39,9 / 66,0

|

| HD 5870 |

****

+

**

40,7 / 58,7

|

| GTX 285 |

****

+

**

35,7 / 55,7

|

| HD 4870X2 8xAA |

***

+

***

25,7 / 51,3

|

| GTX 295 8xAA |

**

+

**

24,0 / 44,3

|

| HD 4890 |

***

+

*

26,0 / 38,0

|

| GTX 285 8xAA |

**

+

*

20,0 / 31,7

|

| HD 4890 8xAA |

*

+

**

14,3 / 30,3

|

Op 2560x1600 kwam de eerste grote bug tevoorschijn bij de HD 5870. Met 8xAA werd het spel een ware slideshow, met 2 tot 3 frames per seconde. De HD 4890 kon de benchmark echter gewoon afspelen. Met slechts 4xAA kan de 5870 prima meekomen met de HD 4870X2.

Energieverbruik en geluid

De Cypress-gpu wordt op 40nm gebakken, waardoor er niet alleen meer transistors in elke vierkante millimeter gepropt kunnen worden, maar er ook meer prestaties per watt geleverd zouden moeten kunnen worden.

AMD claimt zelf een tdp van 188W, maar nog veel opvallender is het idle-verbruik dat op slechts 28W zou liggen. Ten opzichte van de geteste HD 4890 zou de HD 5870 dus 2W minder verbruiken onder load en 32W minder in de idle-stand. De winst werd voornamelijk behaald bij het gddr5-geheugen, dat bij de voorgaande generatie niet teruggeklokt kon worden, zonder dat dit problemen, zoals flikkeringen van het beeldscherm, met zich meebracht.

Volgens Joe Macri, binnen AMD een voorvechter van de gddr5-standaard, is het nu gelukt om de snelheid van het geheugen zo snel te schakelen dat het niet langer merkbaar is: het geheugen schakelt terug in de fractie van een seconde waarin een monitor zichzelf ververst. De resterende 28W die de gpu verbruikt, is voornamelijk afkomstig van lekstroom, een noodzakelijk kwaad bij elke uit transistors opgebouwde chip.

Energieverbuik

Het energieverbruik is gemeten door de videokaarten eerst de desktop van Windows weer te laten geven, waarna de videokaarten vol werden belast met behulp van de stability-test in Furmark. Het opgenomen vermogen in Furmark ligt overigens hoger dan in games, maar voor de absolute verschillen voldoet Furmark prima.

| Vermogensopname systeem - Idle |

| | Verbruik (Watt) |

| HD 5870 |

*******

159 |

| GTX 285 |

*********

194 |

| HD 4890 |

*********

194 |

| GTX 295 |

**********

203 |

| HD 4870X2 |

**********

213 |

De HD 5870 verbruikt 35W minder dan zowel de HD 4890 als de GTX 285. Hierbij moet worden opgemerkt dat de waarden voor onder andere de GTX 285 en de GTX 295 hoger dan verwacht uitvallen. Deze kaarten scoorden op dit onderdeel in voorgaande reviews beter. Een mogelijke verklaring hiervoor kan de gewijzigde kloksnelheid van de cpu zijn, die ditmaal met een spanning van 1,35V op 3,8GHz liep in plaats van 3,2GHz bij een spanning van 1,275V.

| Vermogensopname systeem - Load |

| | Verbruik (Watt) |

| HD 4890 |

*******

325 |

| HD 5870 |

*******

359 |

| GTX 285 |

********

374 |

| HD 4870X2 |

**********

461 |

| GTX 295 |

**********

482 |

Onder load presteert de HD 5870 ogenschijnlijk minder goed. Als we echter rekening houden met de prestaties, die ruimschoots hoger liggen dan bij zowel de HD 4890 als de GTX 285, kan er geconcludeerd worden dat de HD 5870 per watt de meeste prestaties weet te leveren.

Geluidsproductie

AMD koos ervoor om de HD 5870 met een dualslot-koeler uit te rusten, waarbij een radiale ventilator de lucht de kast uitblaast. Aan de achterkant zijn vrij weinig ventilatiegaten te zien. De videokaarten werden wederom volledig met rust gelaten om de geluidsproductie in de idle-stand te bepalen. Vervolgens werd Furmark gedraaid, om de maximale geluidsproductie te leren kennen. Het omgevingsgeluid bedroeg 39,2dBA.

| Geluidsproductie systeem - Idle |

| | Geluidsdruk (dBA) |

| HD 4870X2 |

*********

42,3 |

| HD 5870 |

*********

42,4 |

| HD 4890 |

*********

45 |

| GTX 285 |

**********

47,0 |

| GTX 295 |

**********

47,5 |

AMD lijkt in ieder geval in de idle-modus een vrij stille videokaart af te hebben geleverd met de HD 5870. De Nvidia-kaarten maken hoorbaar meer herrie, terwijl de HD 4890 er precies tussenin zit. De HD 4870X2 wordt erg heet met de ventilator op de automatische stand.

| Geluidsproductie systeem - Load |

| | Geluidsdruk (dBA) |

| HD 5870 |

*********

55,2 |

| HD 4870X2 |

*********

57,8 |

| GTX 285 |

**********

60 |

| HD 4890 |

**********

60,2 |

| GTX 295 |

**********

61,7 |

Onder load weet de HD 5870 zich wederom positief te onderscheiden. De videokaart maakt waarschijnlijk gebruik van zijn extra lengte om efficiënter te kunnen koelen. De GTX 295 is zonder meer het luidste kaart van de vijf, maar dat is niet verwonderlijk aangezien deze ook de meeste warmte af moet voeren. De GTX 285 heeft een eigen koeler van Asus en is onnodig luid.

Conclusie

De HD 5870 is zeker niet de snelste videokaart, maar heeft wel de snelste gpu aan boord die er te koop is. AMD heeft het zelf over een verbetering van ongeveer 60 procent ten opzichte van de HD 4870, waar wij ons wel in kunnen vinden. Uit onze benchmarks blijkt dat de HD 5870 regelmatig 50 procent sneller is dan de HD 4890. In enkele gevallen kan de HD 5870 zelfs direct concurreren met de HD 4870X2.

Het mag duidelijk zijn dat het verdubbelen van de rekeneenheden niet voor een verdubbeling in frames per seconde zorgt. Dat is ook logisch, omdat het toevoegen van rekeneenheden praktisch nooit 100 procent schaalt. Dat de HD 5870 niet sneller is dan de GTX 295, doet eigenlijk niets af aan de prestatie die AMD neer heeft gezet. De prestaties per watt liggen vele malen hoger en ook het idle verbruik is overtuigend.

Niet te verwaarlozen is dat de gpu behalve verbeterde prestaties ook DirectX 11-functionaliteit met zich meebrengt. Op het moment dat er DirectX 11-games uitkomen zou de videokaart een ware inhaalslag kunnen maken ten opzichte van de DirectX 10-kaarten. De ATI Eyefinity-technologie kan ook een reden zijn om de videokaart te kopen, alhoewel er met drie beeldschermen met een resolutie van 1680x1050 pixels al meer gerendered moet worden dan bij een enkel 2560x1600-scherm.

Met een adviesprijs van 399 dollar, dat in Nederland waarschijnlijk een prijskaartje van iets meer dan 300 euro zal betekenen, is de HD 5870 een aanrader. Zelfs met een prijs van ruim 320 euro zou de HD 5870 goedkoper zijn dan de GTX 295. De prestaties mogen dan iets minder zijn: DirectX 11, het verbruik en ATI Eyefinity maken de kaart erg aantrekkelijk. Nvidia zal dan waarschijnlijk ook reageren met een prijsverlaging.

In de chaos van al het grafische geweld zou de eveneens woensdag geïntroduceerde HD 5850 bijna over het hoofd worden gezien. Deze kaart moet het door het uitblijven van een reviewexemplaar echter nog zonder benchmarks doen. De HD 5850 kost 299 dollar en kan naar verwachting de concurrentie met de GTX 285 van 240 euro aan.

CrossFire

CrossFire

Als voorbode van wat er komen gaat, volgt hieronder nog een enkele benchmark met twee HD 5870's in CrossFire, die met grof geweld door de Far Cry 2 benchmark heen ploegden.

Gallery

Behalve de verdubbeling van het aantal streamcores, heeft AMD ook het aantal texture units verdubbeld, van tien naar twintig. AMD lijkt deze texture units nauwelijks aangepast te hebben, aangezien ze op 68 miljard bilinear gefilterde texels per seconde uitkomen. Dat betekent dat er per texture unit vier texture filtering units zijn, wat goed is voor een totaal van tachtig texture filtering units.

Behalve de verdubbeling van het aantal streamcores, heeft AMD ook het aantal texture units verdubbeld, van tien naar twintig. AMD lijkt deze texture units nauwelijks aangepast te hebben, aangezien ze op 68 miljard bilinear gefilterde texels per seconde uitkomen. Dat betekent dat er per texture unit vier texture filtering units zijn, wat goed is voor een totaal van tachtig texture filtering units.

:fill(white)/i/1253564094.jpg?f=thumb)

:fill(white)/i/1253564092.jpg?f=thumb)

:fill(white)/i/1253564095.jpg?f=thumb)

:fill(white)/i/1253564093.jpg?f=thumb)

:fill(white)/i/1253660094.jpeg?f=thumb)

:fill(white)/i/1253660095.jpeg?f=thumb)

:fill(white)/i/1253661142.jpg?f=thumb)

:fill(white)/i/1253661143.jpg?f=thumb)

:fill(white)/i/1253661144.jpg?f=thumb)

:fill(white)/i/1253661145.jpg?f=thumb)

:fill(white)/i/1253661146.jpg?f=thumb)

:fill(white)/i/1253661147.jpg?f=thumb)

:fill(white)/i/1253661148.jpg?f=thumb)

:fill(white)/i/1253661149.jpg?f=thumb)

:fill(white)/i/1253661150.jpg?f=thumb)

:fill(white)/i/1253661151.jpg?f=thumb)

:fill(white)/i/1253661152.jpg?f=thumb)

:fill(white)/i/1253661153.jpg?f=thumb)

:fill(white)/i/1253661154.jpg?f=thumb)

:fill(white)/i/1253661155.jpg?f=thumb)

:fill(white)/i/1253661156.jpg?f=thumb)

:fill(white)/i/1253661157.jpg?f=thumb)

:fill(white)/i/1253661158.jpg?f=thumb)

:fill(white)/i/1253661159.jpg?f=thumb)

:fill(white):strip_exif()/i/1253698907.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1253698816.jpeg?f=thumbmedium)

:strip_icc():strip_exif()/i/1292407062.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/1267027322.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/u/123739/crop5f9ddcde3b3f4_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/158542/crop5bfe71948be6d_cropped.jpeg?f=community)

:fill(white):strip_exif()/i/1278502272.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1253694624.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1253693202.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1253695527.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1253694418.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1253693943.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1253691341.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1253692614.jpeg?f=thumbmedium)

/i/1256543826.png?f=fpa_thumb)

/i/1255376492.png?f=fpa_thumb)

/i/1206089508.png?f=fpa)

/i/1256810574.png?f=fpa)

/i/1253654536.png?f=fpa)

/i/1254469918.png?f=fpa)

/i/1195127112.png?f=fpa)