Woensdag kondigde Apple de iPhone 7 en iPhone 7 Plus aan, waarbij het wederom veel aandacht legde op de camerakwaliteit van de telefoons. Dat is goed te begrijpen, dankzij grote sensoren en grote diafragma-openingen zit de kwaliteit van veel high-end-smartphones al op het niveau van een traditionele compactcamera. Daarbij zijn ook de videomogelijkheden de laatste jaren toegenomen, met 4k-kwaliteit en fraaie slowmotionmogelijkheden. Het is dus niet gek dat de smartphone in veel gevallen onze primaire camera is geworden: prima kwaliteit en altijd bij de hand. Daarmee is de camera een van de belangrijkste elementen van de smartphone geworden.

Er is alleen één front waarop hij nog tekortschiet: optische zoom. Er zijn enkele smartphones die optisch kunnen zoomen, zoals de Samsung Galaxy K zoom, en modellen met een opklikcamera, zoals de Moto Z Play, maar dat is het wel. Door de bewegende lenselementen in het objectief wordt zo'n product al snel relatief groot en zwaar. Huidige smartphones kunnen enkel digitaal zoomen; dit levert niet meer details op, maar gaat juist ten koste van de beeldkwaliteit.

De oplossing lijkt te liggen in het simpelweg toevoegen van een tweede camera, zoals Apple nu heeft gedaan bij de iPhone 7 Plus, maar zoals we ook al eerder zagen bij verschillende Android-telefoons. Twee camera's maken echter meer zaken mogelijk dan enkel inzoomen zonder kwaliteitsverlies, zoals diepte meten, 3d-foto's en -video's maken, verschillende belichtingen samenvoegen, de beeldkwaliteit verbeteren en verschillende brandpuntsafstanden gebruiken. In dit artikel kijken we naar de recente geschiedenis van de dubbele camera, de technieken erachter en de mogelijke toepassingen.

Niet nieuw

Nieuw is het concept van de dubbele camera dus niet. Begin 2014 kwam HTC met de M8, die met twee camera's was uitgerust. De tweede camera werd niet gebruikt om beeld vast te leggen, maar om diepte te meten. Daarmee zou je achteraf kunnen scherpstellen, maar de implementatie was erg mager. Er werd simpelweg een blurfilter toegepast, waarmee het effect van beperkte scherptediepte nagebootst werd. De Honor 6 Plus gebruikte hetzelfde uitgangspunt, maar dan met twee identieke camera's en twee verschillende scherpstelpunten. Die implementatie bleek evenmin revolutionair.

De LG G5 en V20 zijn eveneens uitgerust met twee verschillende camera's. Het gaat in dit geval om twee verschillende brandpuntsafstanden: standaardgroothoek en supergroothoek. Je kunt dus niet inzoomen, maar wel schakelen tussen de twee. In bepaalde situaties kan dat van pas komen, al blijkt uit onze review dat de camera met supergroothoek een wat minder goede beeldkwaliteit aflevert.

/i/2000573983.jpeg?f=imagenormal) De Nokia Pureview 808 en Lumia 1020 zijn uitgerust met slechts een enkele lens, maar Nokia had wel iets bedacht om te kunnen 'zoomen'. De sensor heeft een resolutie van maar liefst 41 megapixel. Deze resolutie wordt echter standaard als bronmateriaal gebruikt om foto's van 5 megapixel uit te destilleren, zodat je kunt zoomen zonder zichtbaar kwaliteitsverlies. Dit heet oversampling en werkt best goed, waarbij de negatieve aspecten van digitale zoom beperkt blijven.

De Nokia Pureview 808 en Lumia 1020 zijn uitgerust met slechts een enkele lens, maar Nokia had wel iets bedacht om te kunnen 'zoomen'. De sensor heeft een resolutie van maar liefst 41 megapixel. Deze resolutie wordt echter standaard als bronmateriaal gebruikt om foto's van 5 megapixel uit te destilleren, zodat je kunt zoomen zonder zichtbaar kwaliteitsverlies. Dit heet oversampling en werkt best goed, waarbij de negatieve aspecten van digitale zoom beperkt blijven.

Monochrome sensor

Huawei koos met de P9 voor een iets andere implementatie van de tweede camera, net zoals bij de Honor 8. Hier zijn de sensor, lensconstructie en resolutie identiek. Bij de tweede camera is het Bayer-kleurfilter weggelaten, waardoor de sensor monochrome foto's produceert. Een sensor bevat alleen lichtgevoelige diodes en is feitelijk kleurenblind. Door een kleurfilter te gebruiken, 'zien' de pixels ineens kleur, waarbij ze worden onderverdeeld in 50 procent groene, 25 procent blauwe en 25 procent rode pixels.

Door zo'n kleurfilter verlies je resolutie, want er worden vier pixels gebruikt om één kleur te produceren. Dit wordt deels gecompenseerd door interpolatie, oftewel het kunstmatig vergroten van de resolutie, maar dit heeft altijd een verlies van detail tot gevolg, circa de helft van de resolutie ten opzichte van een monochrome sensor. Vergeleken met een op Bayer gebaseerde sensor zou dat resulteren in gedetailleerdere beelden. Het kan ook de details in schaduwpartijen en hooglichten ten goede komen. Bovendien is kleurruis afwezig, luminantieruis overigens niet.

De claim van Huawei is dat de beelden van de twee sensoren worden samengesmolten tot een enkele afbeelding, die dan het beste van twee werelden combineert: kleurenfoto's met meer detail, dynamisch bereik en een hogere lichtopbrengst.

Het werkt het?

Huawei doet nogal mysterieus over hoe dit precies tot stand komt, maar technisch kan het op twee manieren. Met de simpelste methode worden de beelden niet samengevoegd, maar slim geanalyseerd. Het monochrome beeld wordt dan als uitgangspunt gebruikt om verschillen te detecteren tussen de monochrome en de kleurenfoto, bijvoorbeeld wat scherpte, details in schaduwen en ruis betreft. Die informatie wordt vervolgens gebruikt om bepaalde delen van de kleurenfoto te optimaliseren. Dergelijke technieken worden nu ook al toegepast om bijvoorbeeld ruis te verminderen, met multi-shot noise reduction, en dat is bijvoorbeeld voor astrofotografie zeer nuttig. Voor reguliere foto's valt het nut te betwijfelen, al is dat ook afhankelijk van de implementatie.

Het samenvoegen van het beeld van twee camera's tot één foto

Een andere methode komt neer op het samenvoegen van beelden door middel van blending. Dit is vergelijkbaar met de manier waarop hdr-foto's gemaakt worden. Drie of meer foto's met verschillende belichtingen worden dan samengevoegd tot één foto, die meer dynamisch bereik bevat en daardoor meer details in schaduwen en hooglichten toont. Bij hdr zijn de drie beelden redelijk gelijkwaardig aan elkaar, maar bij een monochrome en een kleurenfoto is dat niet het geval; het resultaat moet immers kleur blijven, dus de zwart-wittoon mag eigenlijk niet zichtbaar zijn in de foto. Met slimme algoritmen is dit mogelijk, maar een te voorzichtige methode heeft slechts een matig of geen effect.

De praktijk valt tegen

In theorie klinkt het misschien overtuigend, want een sensor zonder kleurfilter kan daadwerkelijk meer scherpte vastleggen; de Leica M Monochrom is daar een goed voorbeeld van. Toch zien we er vooralsnog in de praktijk weinig van terug. Tijdens onze review van de Huawei P9 bleken de twee camera's geen significant voordeel op te leveren. Van extra scherpte bleek niet tot nauwelijks sprake en ook de geclaimde extra lichtopbrengst, minder ruis of meer dynamisch bereik door de dubbele constructie zagen we niet terug in de praktijk. Sterker nog, de zwart-witfoto's lijken meer ruis te bevatten, wat doet vermoeden dat de kleurenfoto's meer bewerkt worden.

De monochrome foto lijkt niet significant meer details te tonen dan de kleurenfoto

Corephotonics en Linx

Twee bedrijven hebben in het recente verleden hard geroepen dat de combinatie van twee camera's daadwerkelijk tot betere beeldkwaliteit leidt. Corephotonics en Linx, beide toevallig Israëlische bedrijven, hebben in diverse demo's en white papers indrukwekkende resultaten laten zien. Start-up Linx specialiseert zich in modulaire cameramodules, oplopend tot vier stuks, waarbij monochrome en kleurensensoren kunnen worden gecombineerd, maar waarmee ook dieptemeting en verbeterde scherpstelling mogelijk zijn. Dit bedrijf werd begin 2015 overgenomen door Apple.

Concurrent Corephotonics claimt hetzelfde te kunnen, al beperkt men zich vooralsnog nog tot het gebruik van twee camera's. Het bedrijf is gespecialiseerd in beeldoptimalisatie door middel van computational photography. Net als Linx claimt Corephotonics betere, gedetailleerdere foto's mogelijk te maken, dankzij de toevoeging van een monochrome sensor, waarbij de beelden 'gefuseerd' worden.

Verschillende brandpuntsafstanden

Eén van de meer simpele, maar wel interessante toepassingen van twee camera's is natuurlijk het gebruik van verschillende brandpuntsafstanden. Zoals eerder beschreven past LG dit al toe, maar dan alleen met groothoek. Apple doet hetzelfde met de net aangekondigde iPhone 7 Plus, maar dan met een 28mm f/1.8 groothoek en een 56mm f/2.8 telelens. Voor foto's en video's kun je dan dus kiezen uit deze twee standen en dus feitelijk inzoomen - gelijk aan 2x optische zoom.

De beeldkwaliteit daarvan zal vele malen beter zijn dan bij digitale zoom, doordat het beeld niet kunstmatig wordt vergroot, maar er daadwerkelijk sprake is van een kleinere beeldhoek en dus meer details. Oftewel, een dergelijke implementatie zal de beeldkwaliteit van smartphones nog een stapje verhogen. Daarbij is een camera met langer brandpunt bijvoorbeeld geschikter voor het nemen van portretten, omdat gezichten minder vervormd worden dan bij een groothoeklens.

Computational Photography

Er is ook nog een tussenvariant denkbaar, waarbij computational photography wordt ingezet om het verschil tussen de twee brandpuntsafstanden te overbruggen. Dit is eveneens een specialisatie van Corephotonics, dat in het recente verleden al twee modules aankondigde met een equivalent bereik van respectievelijk 3 en 5x optische zoom.

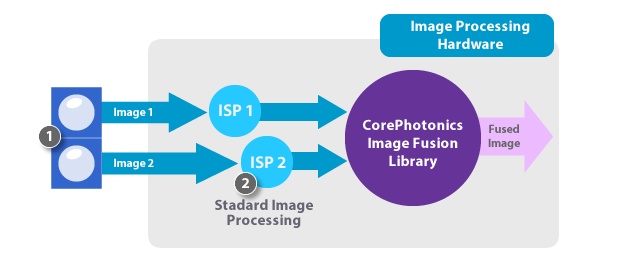

De fusiemethode van Corephotonics

Het bedrijf stelt dat dit als volgt werkt. De gebruiker kiest eerst een bepaalde brandpuntsafstand door op de reguliere manier te zoomen op het scherm. Als op de ontspanknop gedrukt wordt, produceert de camera eerst twee losse beelden op de twee verschillende brandpuntsafstanden. Vervolgens worden deze via een eigen 'fusion engine' samengevoegd tot een enkel beeld, dat daarna op de reguliere manier via de image signal processor wordt verwerkt.

Over hoe het fuseren van de twee brandpuntsafstanden exact werkt, doet het bedrijf geen concrete uitspraken. Het moet in principe ten koste gaan van de scherpte en het detail, maar Corephotonics stelt dat de effectieve resolutie gelijk of zelfs beter is dan het resultaat via mechanische optische zoom. Daar stellen we wat vraagtekens bij, want als je bijvoorbeeld een beeldhoek van 35mm wil laten zien op basis van een groothoek- en telelens, dan zou zou het beeld in het midden zeer gedetailleerd zijn door de details van de telefoto, maar daarbuiten beduidend minder scherp. Daarvoor wordt immers interpolatie van het groothoekbeeld gebruikt.

Dubbele camera in de iPhone 7 Plus

De iPhone 7 Plus is de eerste smartphone met zowel een groothoek- als een telelens en had het zoomprincipe dat CorePhotonics voorstelt dus kunnen toepassen. Apple heeft immers concurrent Linx overgenomen, dat eveneens gespecialiseerd is in computational photography. Toch lijkt Apple het niet te hebben aangedurfd om dit toe te passen, al dan niet doordat interne tests niet aan de eventuele verwachtingen voldeden. Hoewel Apple claimt dat de prestaties van digitale zoom nu vier keer zo goed zijn als voorheen, waardoor je nu tot 10x digitaal kunt inzoomen, is het onduidelijk in hoeverre daar vergelijkbare technologie voor is gebruikt. Apple gebruikt overigens wel computational photography om een kunstmatig scherptediepte-effect met bokéh te creëren, want dankzij de dubbele camera is dieptemeting mogelijk. Dit is iets dat we eerder gezien hebben in Android-smartphones.

Tot slot

Smartphones met dubbele camera's lijken nu echt aan een opmars bezig te zijn. Na HTC, LG, Huawei, Honor en nu Apple is het wachten op de modellen van andere fabrikanten, zoals Samsung en Sony. Kenichiro Toshida, de cfo van Sony, sprak onlangs de verwachting uit dat smartphones met twee camera's een grote opmars maken in 2017. Als de meerwaarde blijkt en de consument bereid is om hiervoor extra in de buidel te tasten, is wat we nu zien nog maar het begin. Want een smartphone met meer dan twee camera's is niet ondenkbaar, zeker niet als de verschillende implementaties, diepte, brandpuntsafstanden, beeldoptimalisatie en slimme zoom, worden gecombineerd.

/i/2001222695.jpeg?f=imagenormal)

/i/2001221699.png?f=imagenormal)

:strip_exif()/i/2001221695.jpeg?f=imagemedium)

:strip_exif()/i/2001221697.jpeg?f=imagemedium)

/i/2001221755.png?f=imagenormal)

/i/2001221753.png?f=thumbmedium)

/i/2001221747.png?f=thumbmedium)

/i/2001221749.png?f=thumbmedium)

/i/2001221751.png?f=thumbmedium)

/i/2001222659.jpeg?f=imagenormal)

:strip_icc():strip_exif()/i/2001347097.jpeg?f=fpa_thumb)

:strip_exif()/i/1377062847.jpeg?f=fpa)