Inleiding

Stel: je smartphone laat tijdens het hardlopen weten dat je niet hard genoeg loopt. Jij kijkt teleurgesteld en uitgeput naar het scherm. Het toestel ziet dat, begrijpt dat je al moe bent en past automatisch het doel voor die dag aan. Toekomstmuziek? Ja. Maar is het ver weg? Absoluut niet.

Specialisten op het gebied van kunstmatige intelligentie zijn druk bezig met toepassingen die emoties en andere signalen van het lichaam interpreteren en de software daarop aanpassen. Het is een kwestie van tijd voordat die toepassingen in mobiele apparaten, zoals smartphones en fitnessarmbanden, zitten.

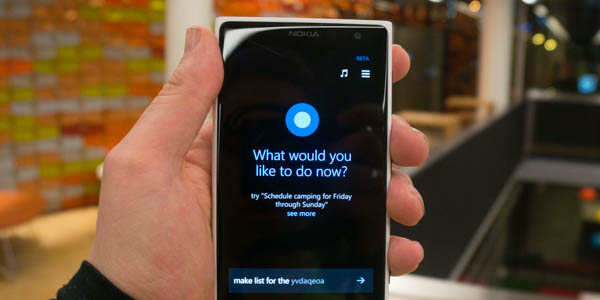

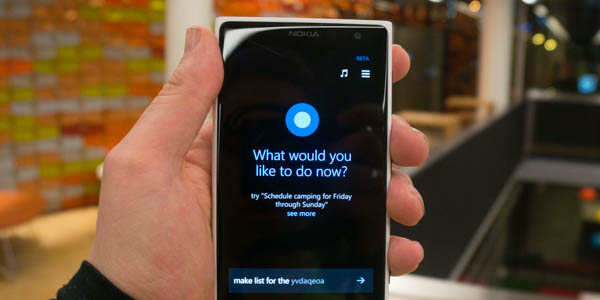

Grote bedrijven willen de smartphone slimmer maken door digitale assistenten, zoals Google Now, Cortana en Siri, door te ontwikkelen. Uiteraard willen Google, Microsoft en Apple meer dan dat: data over gebruikers is waardevol voor het serveren van gerichte advertenties - er zit immers aan vrijwel elke ontwikkeling op smartphonegebied op een of andere manier wel een financieel voordeel voor de maker naast de marge op de hardware.

Maar hoe slim is de huidige generatie digitale assistenten? Welke functies krijgen ze in de toekomst en hoe kunnen ze ons leven nog verder beïnvloeden? Tweakers dook in de wereld achter de nuttige, soms grappige en altijd wondere wereld van digitale assistenten om uit te vinden hoe het verder gaat.

/i/1383480636.jpeg?f=imagenormal)

Intelligent of juist oliedom

Hoe intelligent zijn systemen als Siri, Cortana en Google Now nu echt? Die vraag legden we voor aan enkele vooraanstaande Nederlandse wetenschappers op het gebied van kunstmatige intelligentie.

Tjeerd Andringa, een onderzoeker op het gebied van kunstmatige intelligentie aan de Rijksuniversiteit Groningen, vergelijkt het met het keuzemenu dat je krijgt als je een telefoonnummer van bijvoorbeeld een bedrijf belt. "Wilt u een restaurant in een hotel, toets 1. Voor een hotel, toets 2. Vervolgens kun je nieuwe opties en informatie krijgen op basis van de keuze die je maakt." Heel geavanceerd is het dus volgens Andringa niet.

Volgens David van Leeuwen, hoogleraar forensische toepassingen van spraak- en taaltechnologie aan de Radboud Universiteit in Nijmegen, is het nu vooral cool. "In mijn ogen is die coolness factor vooral te danken aan de intelligentie, en ik vind die zelf al redelijk geavanceerd, al doorzie je soms wel snel de onderliggende algoritmes."

Wessel Kraaij, hoogleraar informatiefiltering en -aggregatie aan diezelfde Radboud Universiteit, is minder onder de indruk. "Ik heb alleen enkele maanden ervaring met Google Now. Mijn indruk is dat de kunstmatige intelligentie daarin nog erg dun is."

Dit soort systemen hebben echter wel veel potentie, denkt Kraaij. "Bij Google worden honderden ideeën tegelijk ontwikkeld, vervolgens gepitcht aan de directie, waarna er weer veel zaken afvallen. Ik kan me voorstellen dat dit ook gebeurt op kleine schaal bij Google Now. De potentie voor het gebruik van de informatie is groot, en ik denk dat we nu pas het topje van de ijsberg van de mogelijkheden zien."

Wat er nu gebeurt, is volgens Kraaij nog niet zo ingewikkeld, al proberen bedrijven als Google daar wel verandering in te brengen. Google werkt aan geavanceerdere mogelijkheden door zeer gerenommeerde wetenschappers in te huren en hen toegang te geven tot de enorme hoeveelheden data. Zo heeft Google Jeff Hinton aangenomen, expert op het gebied van deep learning, waarmee systemen zichzelf dingen kunnen leren als neuraal netwerk. "Ik heb niet het idee dat Google Now al gebruik maakt van deep learning, maar dat zou in de toekomst zeker kunnen gebeuren."

Google experimenteert al enkele jaren met deep learning. Zo heeft het een systeem met zestienduizend processorcores gebouwd dat zichzelf leerde om katten te herkennen op foto's. De zoekgigant heeft daarmee veel ervaring opgedaan met deep learning. Deep learning vereist nu nog relatief veel krachtige hardware, maar vermoedelijk zullen de kosten daarvoor in de komende jaren dalen.

Google experimenteert al enkele jaren met deep learning. Zo heeft het een systeem met zestienduizend processorcores gebouwd dat zichzelf leerde om katten te herkennen op foto's. De zoekgigant heeft daarmee veel ervaring opgedaan met deep learning. Deep learning vereist nu nog relatief veel krachtige hardware, maar vermoedelijk zullen de kosten daarvoor in de komende jaren dalen.

De volgende stap is onder meer het toevoegen van het herkennen van emoties en reacties, denkt Kraaij. Hij is zelf bezig met een project onder de naam Swell, waarvan het doel is om te verkennen hoe een burn-out voorkomen kan worden door fysieke en mentale coaching. "Je kunt het vergelijken met de quantified self-beweging die sterke links heeft met de sportwereld, waar mensen zichzelf proberen te verbeteren door minutieuze analyse van bewegingen. Aan de andere kant kun je het aflezen van emoties gebruiken voor andere doeleinden."

Als voorbeeld noemt hij S Health van Samsung, de sport-app die op diverse Galaxy-toestellen staat. "Samsung ziet nu al of je naar je telefoon kijkt om het scherm aan te houden. Volgende stap is het aflezen van je reactie op een coachingsbericht van je persoonlijke e-coach, om op die manier de coachingstijl aan te passen."

Dat vereist een goede frontcamera en een manier om dat beeld te analyseren en de reactie te interpreteren. Andringa wijst erop dat deze manier van emotieherkenning niets te maken heeft met kunstmatige intelligentie. "Het systeem is zo geprogrammeerd dat bepaalde input, bijvoorbeeld analyse van bewegingen of lichaamsreacties, zorgt voor bepaalde output. Dat is niet hetzelfde als de emotie erachter begrijpen, dat kunnen deze systemen nog lang niet."

En misschien gaat het wel nooit kunnen, meent hij. "Deze software kan echter nooit de kennis vergaren die wij in de loop van ons leven automatisch leren. Neem bijvoorbeeld het begrip warm. Baby’s kennen warm als gevoel bij de moeder, bij peuters komt daar het woord ‘warm’ bij. Vervolgens duurt het nog jaren voor kinderen door krijgen dat warm ook een figuurlijke betekenis heeft. Een computer kan die ervaring nooit opdoen, die leert niet hoe we bij het leren interacteren met de wereld en mist dus die fundamentele kennis. Simpelweg de synoniemen van het woord 'warm' aanleren is dan niet genoeg."

En misschien gaat het wel nooit kunnen, meent hij. "Deze software kan echter nooit de kennis vergaren die wij in de loop van ons leven automatisch leren. Neem bijvoorbeeld het begrip warm. Baby’s kennen warm als gevoel bij de moeder, bij peuters komt daar het woord ‘warm’ bij. Vervolgens duurt het nog jaren voor kinderen door krijgen dat warm ook een figuurlijke betekenis heeft. Een computer kan die ervaring nooit opdoen, die leert niet hoe we bij het leren interacteren met de wereld en mist dus die fundamentele kennis. Simpelweg de synoniemen van het woord 'warm' aanleren is dan niet genoeg."

Een figuur als Marvin uit The Hitchhiker's Guide to the Galaxy, die dankzij een 'genuine people personality' dus emoties begrijpt, heeft en kan uiten, is dus volgens Andringa voorlopig nog een utopie. Wel zijn de digitale assistenten goed voor herhaalde commando's en gesprekken, denkt de hoogleraar. "Met alles wat routinematig gaat, werkt Siri verrassend goed. Met het vraag&antwoord-spel kan het goed werken, omdat veel mensen dezelfde vragen stellen aan Siri. Vanuit menselijk oogpunt zijn ze nog dom, maar het zijn technische hoogstandjes."

Interpreteren van spraak

Gesprekken met je smartphone

Een van de meest centrale elementen van de huidige digitale assistenten is spraakherkenning. Een van de elementen waarmee Siri in 2011 bij de release opviel was dat het voor het eerst mogelijk was om 'gesprekken' te voeren met een iPhone; Siri kan een vervolgvraag stellen en begrijpt bovendien 'natuurlijke taal'. Het heeft ertoe geleid dat digitale assistenten voor veel mensen een persoonlijkheid hebben.

Fabrikanten maken dankbaar gebruik van die personalisatie van deze digitale assistenten: Microsoft noemde daarom zijn versie Cortana en verwijst doorlopend naar de dienst als een vrouw. Google doet daar niet aan mee.

Een van de grootste problemen met spraakherkenning is weten wat gebruikers echt bedoelen, zegt Van Leeuwen. "Een van de grootste obstakels is gebrek aan kennis over de context. Als je een idee hebt waar iemand het over heeft, kun je zijn geproduceerde taal beter verwerken en als je weet waar iemand mee bezig is kun je beter begrijpen wat hij wil." Omdat de systemen op smartphones veel context hebben door alle informatie in smartphones, zouden ze die context sneller kunnen begrijpen dan veel andere systemen.

Andringa voegt daaraan toe dat systemen voor spraakherkenning het menselijke systeem van perceptie missen. "Een spraakherkenner deelt spraak op in kleine stukjes, vertaalt de input naar getallen en zoekt tussen miljoenen combinaties naar de combinatie die het meeste lijkt op de naar getallen omgezette input. Bij mensen werkt dat anders: wij horen van alles, taal, toonhoogte, emotie en we vormen in ons hoofd hypothese over welk deel spraak kan zijn en wat die spraak dan betekent. Vervolgens checken we in diverse delen van de hersenen die hypotheses en zo interpreteren wij spraak. Klopt de voorkennis die ik heb toegepast op deze spraak? Spraakherkenners ontberen die voorkennis. Zelfs als je kwakende kikkers laat horen, zal een spraakherkenner proberen daar wat van te maken."

Andringa voegt daaraan toe dat systemen voor spraakherkenning het menselijke systeem van perceptie missen. "Een spraakherkenner deelt spraak op in kleine stukjes, vertaalt de input naar getallen en zoekt tussen miljoenen combinaties naar de combinatie die het meeste lijkt op de naar getallen omgezette input. Bij mensen werkt dat anders: wij horen van alles, taal, toonhoogte, emotie en we vormen in ons hoofd hypothese over welk deel spraak kan zijn en wat die spraak dan betekent. Vervolgens checken we in diverse delen van de hersenen die hypotheses en zo interpreteren wij spraak. Klopt de voorkennis die ik heb toegepast op deze spraak? Spraakherkenners ontberen die voorkennis. Zelfs als je kwakende kikkers laat horen, zal een spraakherkenner proberen daar wat van te maken."

Maar hoe komt dat? Andringa heeft een theorie daarover. "Het komt denk ik mede door de wetenschappers die eraan werken. De mensen die nu aan spraakherkenning werken, weten veelal veel van databases en machine learning, maar weten weinig van perceptie. Mensen die veel van perceptie weten en aan spraakherkenning werken, raken teleurgesteld in hoe moeilijk het is om de huidige state-of-the-art te benaderen en stoppen dus snel. Daarom zitten we met de soort spraakherkenning die er nu is. Ik ben daarom niet positief over fundamentele verbeteringen, maar het huidige systeem zal nog wel beter worden."

Waarom het niet werkt in het Nederlands

Google Now heeft wat functionaliteit in het Nederlands, maar Siri en Cortana werken nog in zijn geheel niet in onze moedertaal. Hoe komt dat toch? Het ligt niet aan de spraakherkenning zelf, denkt Van Leeuwen. "Spraak naar tekst is niet zozeer ingewikkeld, we weten wel ongeveer hoe het moet. Ik heb zelf indertijd een systeem voor het Nederlands ontwikkeld en er zijn nu verscheidene systemen verkrijgbaar, het kost wel veel inspanning." Het belangrijkste is volgens Van Leeuwen om databases aan te leggen met zoveel mogelijk sprekende Nederlanders, zodat het systeem om kan gaan met accenten.

Dat is waar bijvoorbeeld Google mee bezig is geweest: de zoekgigant heeft rondgereden in Nederland en op veel plekken mensen gevraagd om een vaste set zinnen in te spreken. Bovendien leren systemen van spraakherkenning door te vragen wat mensen bedoelen. Op die manier blijft het systeem zich verbeteren, zo is de gedachte.

Dat is waar bijvoorbeeld Google mee bezig is geweest: de zoekgigant heeft rondgereden in Nederland en op veel plekken mensen gevraagd om een vaste set zinnen in te spreken. Bovendien leren systemen van spraakherkenning door te vragen wat mensen bedoelen. Op die manier blijft het systeem zich verbeteren, zo is de gedachte.

Voor het interpreteren van natuurlijke taal geldt min of meer hetzelfde. "Het taalkundige stuk van spraakherkenning wordt steeds meer computationeel van aard." Daardoor is het steeds makkelijker om dat te verbeteren.

Systemen als Google Now, Siri en Cortana hebben naast veel kennis over het individu ook algemene kennis nodig: als het heeft gedetecteerd dat een gebruiker bijvoorbeeld houdt van honkbal, moet het weten waar het uitslagen van honkbalwedstrijden kan vinden om die te tonen en weten hoe de competitie in elkaar steekt om die te interpreteren.

Dat soort kennis is een van de obstakels waarom de systemen van Apple en Microsoft helemaal niet en die van Google slechts deels in Nederland werkt. "Maar ik kan me voorstellen dat er met betrekking tot de ontologie wel een soortgelijke inspanning moet worden gedaan om Amerikaanse systemen in Nederland te laten werken. Wij zijn niet geïnteresseerd in de Boston Red Sox of de New York Yankees, maar in Vitesse of Ajax. Maar ik vermoed dat een deel van deze kennis wel kan worden verkregen uit het automatisch doorspitten van websites in Nederland."

Dat soort kennis is een van de obstakels waarom de systemen van Apple en Microsoft helemaal niet en die van Google slechts deels in Nederland werkt. "Maar ik kan me voorstellen dat er met betrekking tot de ontologie wel een soortgelijke inspanning moet worden gedaan om Amerikaanse systemen in Nederland te laten werken. Wij zijn niet geïnteresseerd in de Boston Red Sox of de New York Yankees, maar in Vitesse of Ajax. Maar ik vermoed dat een deel van deze kennis wel kan worden verkregen uit het automatisch doorspitten van websites in Nederland."

Dat de systemen niet of beperkt werken in het Nederlands, lijkt vooral te komen doordat er weinig Nederlands sprekenden zijn. "Maar wij hebben wel een hoge smartphonepenetratie, dus bedrijven slaan ons niet altijd over bij dit soort ontwikkelingen."

Tot slot

Het zou te ver voeren om de huidige versies van de digitale assistenten in smartphones aan te duiden als geavanceerde kunstmatige intelligentie. Hedendaagse smartphones genereren simpelweg enorme hoeveelheden data. De bedrijven die de data ontvangen maken daar dankbaar gebruik van door diensten te maken die vertrouwen op die data om gebruikers relevante informatie te tonen.

Het is een haast magisch effect als je voor het eerst een notificatie krijgt dat je eerder weg moet voor een afspraak, omdat de digitale assistent op je smartphone doorheeft dat je een afspraak hebt op een bepaalde locatie en er file staat op de weg daarnaar toe. Als je beseft hoeveel data de smartphones doorsturen naar de servers van Apple, Google en Microsoft, is het helemaal niet zo wonderlijk meer dat het kan.

Het blijft volgens de hoogleraren die wij spraken wel een technisch hoogstandje, maar er zijn nog veel stappen te zetten voordat we dit soort systemen echt intelligent kunnen noemen. Misschien zal het begrijpen van en reageren op emoties uiteindelijk kunnen. Wat Google Now, Siri en Cortana uiteindelijk allemaal zullen kunnen, is nog in het ongewisse, maar hoewel je smartphone niet ineens een Marvin of HAL9000 zal worden, is hij dankzij deze systemen wel een stukje slimmer dan voorheen.

/i/1383480636.jpeg?f=imagenormal)

Google experimenteert al enkele jaren met deep learning. Zo heeft het een systeem met zestienduizend processorcores

Google experimenteert al enkele jaren met deep learning. Zo heeft het een systeem met zestienduizend processorcores  En misschien gaat het wel nooit kunnen, meent hij. "Deze software kan echter nooit de kennis vergaren die wij in de loop van ons leven automatisch leren. Neem bijvoorbeeld het begrip warm. Baby’s kennen warm als gevoel bij de moeder, bij peuters komt daar het woord ‘warm’ bij. Vervolgens duurt het nog jaren voor kinderen door krijgen dat warm ook een figuurlijke betekenis heeft. Een computer kan die ervaring nooit opdoen, die leert niet hoe we bij het leren interacteren met de wereld en mist dus die fundamentele kennis. Simpelweg de synoniemen van het woord 'warm' aanleren is dan niet genoeg."

En misschien gaat het wel nooit kunnen, meent hij. "Deze software kan echter nooit de kennis vergaren die wij in de loop van ons leven automatisch leren. Neem bijvoorbeeld het begrip warm. Baby’s kennen warm als gevoel bij de moeder, bij peuters komt daar het woord ‘warm’ bij. Vervolgens duurt het nog jaren voor kinderen door krijgen dat warm ook een figuurlijke betekenis heeft. Een computer kan die ervaring nooit opdoen, die leert niet hoe we bij het leren interacteren met de wereld en mist dus die fundamentele kennis. Simpelweg de synoniemen van het woord 'warm' aanleren is dan niet genoeg." Andringa voegt daaraan toe dat systemen voor spraakherkenning het menselijke systeem van perceptie missen. "Een spraakherkenner deelt spraak op in kleine stukjes, vertaalt de input naar getallen en zoekt tussen miljoenen combinaties naar de combinatie die het meeste lijkt op de naar getallen omgezette input. Bij mensen werkt dat anders: wij horen van alles, taal, toonhoogte, emotie en we vormen in ons hoofd hypothese over welk deel spraak kan zijn en wat die spraak dan betekent. Vervolgens checken we in diverse delen van de hersenen die hypotheses en zo interpreteren wij spraak. Klopt de voorkennis die ik heb toegepast op deze spraak? Spraakherkenners ontberen die voorkennis. Zelfs als je kwakende kikkers laat horen, zal een spraakherkenner proberen daar wat van te maken."

Andringa voegt daaraan toe dat systemen voor spraakherkenning het menselijke systeem van perceptie missen. "Een spraakherkenner deelt spraak op in kleine stukjes, vertaalt de input naar getallen en zoekt tussen miljoenen combinaties naar de combinatie die het meeste lijkt op de naar getallen omgezette input. Bij mensen werkt dat anders: wij horen van alles, taal, toonhoogte, emotie en we vormen in ons hoofd hypothese over welk deel spraak kan zijn en wat die spraak dan betekent. Vervolgens checken we in diverse delen van de hersenen die hypotheses en zo interpreteren wij spraak. Klopt de voorkennis die ik heb toegepast op deze spraak? Spraakherkenners ontberen die voorkennis. Zelfs als je kwakende kikkers laat horen, zal een spraakherkenner proberen daar wat van te maken."

Dat soort kennis is een van de obstakels waarom de systemen van Apple en Microsoft helemaal niet en die van Google slechts deels in Nederland werkt. "Maar ik kan me voorstellen dat er met betrekking tot de

Dat soort kennis is een van de obstakels waarom de systemen van Apple en Microsoft helemaal niet en die van Google slechts deels in Nederland werkt. "Maar ik kan me voorstellen dat er met betrekking tot de

:strip_exif()/i/2005500190.jpeg?f=fpa)

:strip_exif()/i/1393494037.jpeg?f=fpa)

/i/1233670851.png?f=fpa)

/i/1393853269.png?f=fpa)

:strip_exif()/i/1321341466.jpeg?f=fpa)