Google Chrome experimenteert met een nieuwe functie die de impact van ddos-aanvallen en overbelasting moet helpen verminderen. Zodra de browser detecteert dat een server problemen heeft, neemt hij een stapje terug.

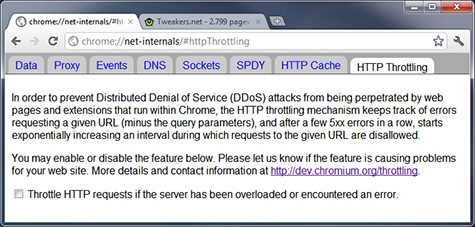

Om te voorkomen dat webservers die met een overdaad aan verkeer kampen nog zwaarder worden belast, heeft versie 12 van Google Chrome een functie aan boord die overbelaste servers ontziet. Als een webserver vier keer achter elkaar een http-statuscode met een waarde hoger dan 500 teruggeeft, treedt een beschermingsmechanisme in werking. Het gaat daarbij onder meer om 'internal server error'-, 'bad gateway'- en 'service unavailable'-meldingen.

Als het beschermingsmechanisme is geactiveerd, worden de gebruikers ervan verhinderd om al te vaak te refreshen. Aanvankelijk wordt het bezoeken van een getroffen webserver voor 0,7 seconde geblokkeerd, maar als de problemen aanhouden, groeit dit interval exponentieel. Uiteindelijk kunnen verzoeken naar een webserver voor 15 minuten worden geblokkeerd, als deze 48 minuten niet te bereiken is geweest. Daarna neemt het interval weer af.

Op deze manier wordt voorkomen dat webservers met trafficproblemen, bijvoorbeeld door een plotselinge piek in bezoekersaantallen of door een ddos-aanval, nog zwaarder worden belast. ConceivablyTech ontdekte de nieuwe feature, die is geïntegreerd in het canary-channel van Chrome, waar nieuwe features het eerst worden getest. De functie moet nu nog handmatig worden aangezet. Onbekend is of en wanneer deze standaard wordt ingeschakeld.

:fill(white):strip_exif()/i/2002189289.jpeg?f=thumbmedium)

/i/2000658159.png?f=fpa)

/i/1260868188.png?f=fpa)

:strip_exif()/i/1303198807.gif?f=fpa)

:strip_exif()/i/1265360824.gif?f=fpa)

:strip_exif()/i/1297759428.gif?f=fpa)

/i/1258653501.png?f=fpa)

/i/1300877312.png?f=fpa)

/i/1220343617.png?f=fpa)

/i/1195461505.png?f=fpa)

/i/1292098739.png?f=fpa)

/i/1248683747.png?f=fpa)

/i/1252498398.png?f=fpa)

:strip_exif()/i/1043500222.gif?f=fpa)