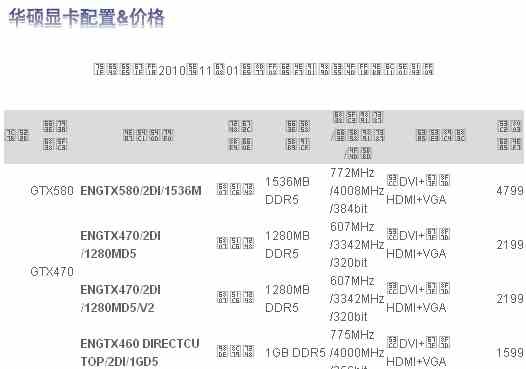

Op de Chinese website van Asus heeft kortstondig een tabel gestaan waarin melding werd gemaakt van de GTX 580. De gpu krijgt een kloksnelheid van 772MHz en beschikt over 1,5GB geheugen met een kloksnelheid van 4002MHz.

De website hardware.info merkte de tabel op en maakte er een screenshot van. De tabel maakt melding van een 384bit-geheugenbus, die in contact staat met 1,5GB gddr5-geheugen. Het geheugen tikt op 4002MHz, ongeveer 8 procent sneller dan bij de GTX 480, waarvan het geheugen een kloksnelheid van 3696MHz heeft.

Het aantal Cuda-cores wordt niet genoemd, maar volgens de geruchten en een anonieme bron heeft de GTX 580 er 512. Eveneens volgens geruchten krijgt de gpu een kloksnelheid van 772MHz, wat betekent dat de Cuda-cores hun werk doen op 1552MHz. Daarmee is de gpu 10 procent hoger geklokt dan de GTX 480.

De videokaart zoals Asus die zal uitbrengen heeft verder een vga-, een dvi- en een hdmi-poort, maar de eerstgenoemde wordt waarschijnlijk gerealiseerd middels een dvi naar vga-adapter. De GTX 480 beschikt bijvoorbeeld ook over twee dvi-poorten en een mini-hdmi-poort. Als laatste staat er een prijs van 4800 Yuan in de tabel, omgerekend goed voor 509 euro.

/i/1291105625.png?f=fpa)

/i/1208164214.png?f=fpa)

/i/1269100785.png?f=fpa)

:strip_exif()/i/1277371338.jpeg?f=fpa)

/i/1269640903.png?f=fpa)