De Pci Special Interest Group heeft verschillende details vrijgegeven over de pci-express 3.0-standaard. De standaard biedt tweemaal zoveel bandbreedte en ondersteunt videokaarten tot 300W.

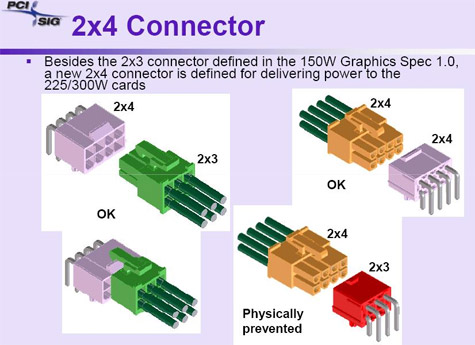

Naast een hoger energieverbruik voorziet de organisatie achter de pci-express-standaard ook grotere videokaarten. In plaats van twee slots, zoals nu gebruikelijk is bij high-end videokaarten, mogen de kaarten in toekomst drie sloten in beslag nemen. De nieuwe standaard zal ook vergezeld worden door een nieuw type stroomaansluiting om de energiehonger van 225W- en 300W-videokaartenkaarten te kunnen stillen.

Pci-express 3.0 zal tweemaal zoveel bandbreedte kunnen leveren als pci-express 2.0, maar tegelijkertijd backwards compatibel blijven. De fysieke specificatie blijft ongewijzigd, alleen de elektrische specificatie verandert. Hoewel de plannen voor de nieuwe pci-express-standaard in grote lijnen bekend zijn, zijn deze nog niet definitief. Verwacht wordt dat de specificatie eind 2009 afgerond zal worden en dat de eerste producten rond 2010 het daglicht zullen zien.

:strip_exif()/i/2005832456.jpeg?f=fpa)

/i/1284627183.png?f=fpa)

:strip_exif()/i/1036340716.gif?f=fpa)