Hoewel over het algemeen de high-end videokaarten de meeste aandacht krijgen in de media, kiezen veel computergebruikers toch voor een goedkoper model. HardOCP heeft daarom een tweetal videokaarten bekeken die verkrijgbaar zijn voor onder de 80 euro.

De twee videokaarten zijn voorzien van gpu's afkomstig van de twee belangrijkste spelers in de videokaartenmarkt: ATi en nVidia. De GeForce 7300 GT neemt de strijd op voor nVidia, terwijl de Radeon X1300 XT de eer van ATi moet verdedigen. Beide chips worden geproduceerd op 90nm en ondersteunen DirectX 9.0c, Shaders Model 3.0 en ddr2- of gddr3-geheugen. De videokaarten die zijn getest, onderscheiden zich van de competitie met dezelfde gpu door een hogere kloksnelheid dan gebruikelijk. Bovendien zijn de twee videokaarten nog niet beschikbaar.

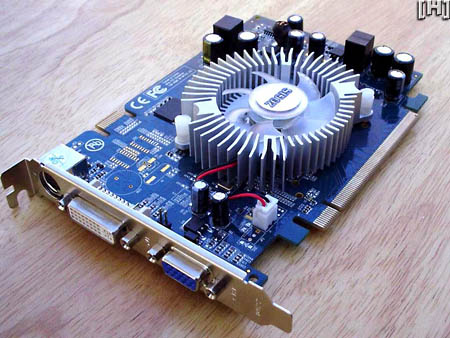

Het nVidia-kamp wordt vertegenwoordigd door de Zogis GeForce 7300 GT Turbo 256MB. Zogis is een nieuwe speler op de markt van videokaarten en wordt gedistribueerd door PowerColor. Zogis maakt alleen videokaarten, en alleen videokaarten met een nVidia-gpu. De GeForce 7300 GT Turbo 256MB werkt op een kloksnelheid van 500MHz, 150MHz boven de referentiekloksnelheid van 350MHz. De videokaart maakt verder gebruik van 256MB gddr3-geheugen op een kloksnelheid van 700MHz (1400MHz ddr), terwijl de meeste andere GeForce 7300 GT-videokaarten ddr2-geheugen op een kloksnelheid van 533MHz gebruiken. Een dual-link dvi-aansluiting, een 15-pin vga-connector en een hdtv-poort zorgen voor de overdacht van de videosignalen naar een monitor of tv. Een actieve koeler zorgt voor voldoende luchtstroom over de gpu; veel andere GeForce 7300GT-videokaarten zijn echter passief gekoeld.

De Sapphire Radeon X1300 XT vertegenwoordigt het ATi-kamp en is, evenals de Zogis, nog niet verkrijgbaar. De videokaart van dit bedrijf, dat alleen ATi-chips gebruikt voor zijn videokaarten, maakt gebruik van een X1300XT-gpu op een kloksnelheid van 575MHz, 75MHz-boven de referentiekloksnelheid van 500MHz. Het 256MB-grote gddr3-geheugen werkt op een kloksnelheid van 690MHz, 290MHz hoger dan de kloksnelheid op de meeste X1300XT-videokaarten. Net als de Zogis-videokaart heeft ook deze kaart een dual-link dvi-connector, een 15-pin vga-connector en een hdtv-aansluiting. Ook deze videokaart wordt door een koelblok met fan van koeling voorzien.

Uit de bespreking van beide videokaarten blijkt dat ze goed presteren voor hun relatief lage prijs. Uiteraard zijn het geen kaarten die topsnelheden leveren in moderne spellen, maar populaire games zoals World of Warcraft zijn op zeer acceptabele snelheid met veel detail te spelen. Wat betreft overclocken is er niet veel ruimte meer, maar zelfs zonder aanpassingen aan de koeling is er nog een beetje extra snelheid uit te persen. Uiteindelijk wordt de Zogis tot winnaar van de vergelijking uitgeroepen, omdat hij iets beter presteert, minder geluid maakt en iets betere overklokprestaties levert.