Op de London Games Developers Conference heeft het bedrijf Allegorithmic software gepresenteerd waarmee de grootte van gametextures zeer fors kan worden gereduceerd. Het zogeheten ProFX-programma maakt gebruik van een techniek die 'procedural texturing' wordt genoemd, en waarmee textures zonder kwaliteitsverlies zeventig procent kleiner gemaakt kunnen worden. De officiële site rept zelfs van een compressieverhouding van 1:300. De technologie is met name bruikbaar voor spellen die online worden aangeboden, omdat de gamegraphics een belangrijk deel van de downloadtijd voor hun rekening nemen. Ook de laadtijden van spellen zouden dankzij ProFX verkort kunnen worden; de makers claimen dat het opbouwen van textures met hun software sneller gaat dan het uitlezen van ongecomprimeerde graphics van 'courante' harde schijven.

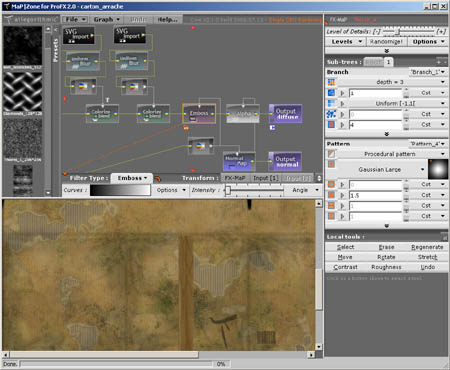

Het compressiesysteem werd gedemonstreerd met behulp van de game Roboblitz. Dit spel, dat op de Unreal 3-engine draait, mocht niet groter dan 50MB zijn om via Xbox Live Arcade verspreid te worden. De ProFX-auteurs slaagden daar naar eigen zeggen probleemloos in: de 80MB aan textures die voor het eerste level van het spel nodig zijn, werden in vier seconden gegenereerd met behulp van een bestand van slechts 280KB. Op de vraag waarom niet iedereen van deze software gebruik maakt, liet woordvoerder Sébastien Deguy weten dat ProFX-editor MapZone niet al te eenvoudig in het gebruik is, maar diverse scholingsprogramma's moeten dat probleem verhelpen. Volgens Deguy is het dan ook een kwestie van tijd voordat de grote gamestudio's zijn product in gebruik nemen. De Allegorithmic-software is beschikbaar voor Xbox- en Windows-games; ondersteuning voor de PlayStation 3 komt 'binnenkort' op de markt.