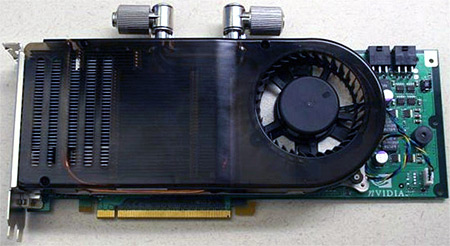

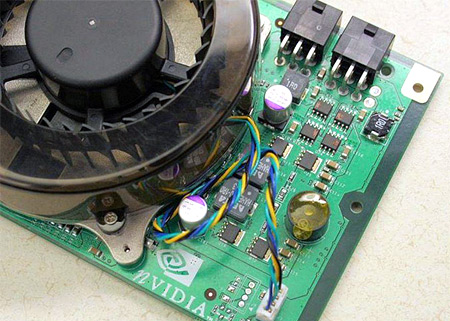

Het Chineestalige PCOnline heeft een aantal foto’s gepubliceerd van nVidia’s nieuwe generatie videochip, de G80. De specificaties van de chip zijn momenteel nog niet geheel bekend, maar uit de foto’s lijkt in ieder geval opgemaakt te kunnen worden dat het energieverbruik niet mals zal zijn. Op de foto’s zijn aansluitingen zichtbaar voor waterkoeling en verder heeft de kaart niet één, maar twee externe PCIe-stroomaansluitingen. Ook ATi’s nieuwe generatie videokaarten zal waarschijnlijk een flinke hoeveelheid energie verbruiken, de laatste geruchten spreken over 180 watt. Hoeveel watt de G80 maximaal verbruikt is onbekend. Verwacht wordt dat de G80 nog dit jaar, in november, geïntroduceerd zal worden.