Onderzoek naar het effect van zoekmachines op de hoeveelheid verkeer richting een website heeft een verrassend resultaat opgeleverd. Uit een omstreden onderzoek blijkt namelijk dat de gangbare aanname dat Google en consorten ervoor zorgen dat bekende websites exponentieel toenemende bezoekersaantallen mogen verwelkomen en daarom steeds beter vindbaar worden, niet waar is. Zoekmachines blijken juist een nivellerend effect te hebben op de bereikbaarheid van websites. Nieuwe en onbekende websites hebben vanwege zoekmachines een grotere ontdekkingskans dan het geval is wanneer de vindbaarheid alleen veroorzaakt zou worden door onderlinge links tussen websites. De gangbare ‘Googlearchy’-hypothese dat bekende sites vanwege hun hoge notering in zoekmachines alsmaar beter bezocht worden ten koste van minder bekende websites, wordt door dit onderzoek dan ook afgewezen. Volgens de wetenschappers van de Indiana University in de VS en de Duitse Bielefeld universiteit zorgen zoekmachines juist voor verkeer richting minder populaire websites dat daar anders nooit terecht zou komen.

Onder leiding van Santo Fortunato vergeleken de onderzoekers het aantal websites dat naar een bepaalde locatie linkt en de hoeveelheid verkeer die naar de website toegaat. Dit werd gedaan voor bijna dertigduizend websites. Vervolgens werd er een model opgesteld dat de factoren combineert die van toepassing zijn tijdens het zoeken naar informatie op internet. Deze factoren waren onder andere de zoektermen die mensen gebruiken, de manier waarop zoekmachines resultaten verkrijgen en ordenen en de manier waarop mensen met die resultaten omgaan. Dit model werd vervolgens vergeleken met het gemeten verkeer naar websites toe. In tegenstelling tot hun hypothese dat er een exponentiële relatie zou bestaan tussen het aantal hyperlinks naar de website toe en de hoeveelheid verkeer, bleek deze relatie gewoon lineair te zijn. Het eindigt daarom met de conclusie dat de ‘rich-get-richer’-aanname geen bestaansrecht heeft.

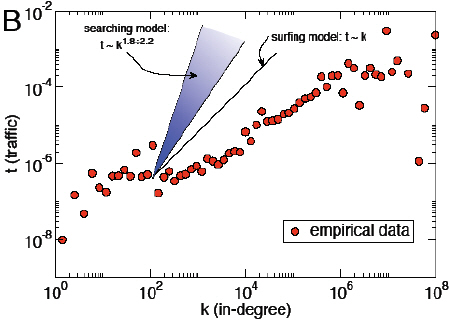

Relatie tussen het aantal links dat naar een website verwijst (horizontale schaal) en de gemeten hoeveelheid verkeer die de website bereikt (verticale schaal). De paarse grafiek ('searching model') geeft het aantal bezoekers weer dat in het gebruikte model theoretisch via zoekmachines de website zou bezoeken; de zwarte lijn ('surfing model') geeft aan hoeveel dit er theoretisch zouden zijn als het verkeer alleen door onderlinge hyperlinks veroorzaakt wordt. De rode punten ('empirical data') geven het daadwerkelijk gemeten verkeer weer.

Relatie tussen het aantal links dat naar een website verwijst (horizontale schaal) en de gemeten hoeveelheid verkeer die de website bereikt (verticale schaal). De paarse grafiek ('searching model') geeft het aantal bezoekers weer dat in het gebruikte model theoretisch via zoekmachines de website zou bezoeken; de zwarte lijn ('surfing model') geeft aan hoeveel dit er theoretisch zouden zijn als het verkeer alleen door onderlinge hyperlinks veroorzaakt wordt. De rode punten ('empirical data') geven het daadwerkelijk gemeten verkeer weer.

De uitkomsten van het onderzoek blijken niettemin verre van onomstreden. De conclusies zouden namelijk verkregen zijn op basis van een experimentele opzet die meerdere oorzaken voor het gemeten effect toestaat. Volgens Matthew Hindman van de Arizona State University staat het bijvoorbeeld niet vast dat zoekmachines ervoor zorgen dat het exponentiële model tegengesproken wordt door het daadwerkelijke verkeer naar grote websites toe. Ook is er onderzoek dat juist het tegenovergestelde beweert (.pdf-formaat) en claimt data te hebben die bewijst dat het rich-get-richer-effect wél optreedt. Ook zouden de methodes voor het bepalen van het aantal links naar een website toe en de belangrijkheid van een website, namelijk via het ‘link:’-commando in Google en de website-classificatie van Alexa, verre van foutloos zijn. Het blijft dus gissen naar de impactfactor van de zoekmachinekolossen op de richting van het internetverkeer.