Intel heeft op IDF het Mitosis Project onthuld, een onderzoeksteam dat zich bezighoudt met speculatieve multithreading. Zoals iedereen inmiddels wel weet is het toevoegen van een of meer extra cores in theorie een goede manier op de prestaties te verhogen, maar loopt men in de praktijk vaak tegen het probleem aan dat (makers van) applicaties niet weten hoe ze er gebruik van kunnen maken. Intel bestrijdt dit probleem op verschillende manieren, onder andere door de programmeurs bij te staan met advies en geavanceerde ontwikkelsoftware, zoals de nieuwste versie van de ICC-compiler met helper threads.

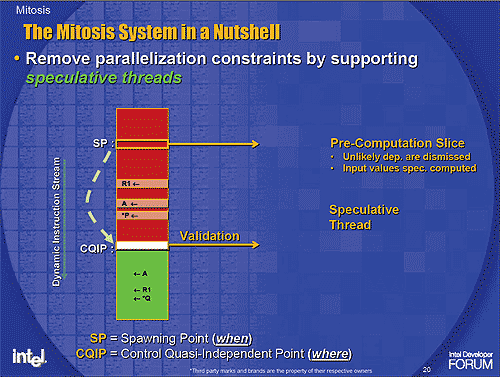

Het bedrijf is ondertussen ook druk op zoek naar manieren om de hardware zelf mee te laten werken aan het oplossen van dit probleem, en Project Mitosis is daar een voorbeeld van. Het idee is om de hardware net zoals bij normale multithreading twee of meer stukken code tegelijk uit te laten voeren, maar dan op een 'agressieve' manier, dus eigenlijk zonder zeker te weten of het wel correcte resultaten oplevert. Net als bij andere features om de prestaties te verhogen zoals branch prediction wordt het risico dat er fouten worden gemaakt (in dit geval door onderling afhankelijke code parallel uit te voeren) voor lief genomen. Pas na de executie wordt gecontroleerd of de resultaten van de speculatieve thread bruikbaar zijn, en op dat moment wordt besloten of de effecten ervan 'committed' (geaccepteerd) danwel 'squashed' (genegeerd) worden.

Simulaties hebben aangetoond dat een processor met Mitosis-technologie aan boord alle single-threaded benchmarks op zijn minst iets sneller uitvoert dan een normale chip, en in sommige gevallen zelfs meerdere malen zo snel is. De grootste winsten zijn te behalen in situaties waarin parrallellisme wel aanwezig is, maar de progammeur het om wat voor reden dan ook niet expliciet in zijn code heeft ingebouwd. Het is niet duidelijk wanneer Intel verwacht dat speculatieve threads klaar zijn voor commerciële producten, maar wellicht zien we het concept binnen enkele jaren terug in een van de opvolgers van de Merom-core.