Falanx heeft de Mali200 grafische processor IP-core geïntroduceerd. De Mali200 is een GPU met maar één pipeline die meer functies heeft dan Shader Model 3.0 en daarmee gebruikt kan worden met onder andere OpenGL ES 2.0, OpenVG en DirectX 9.0. De Mali200 IP zou maar weinig transistors bevatten en zou ook maar weinig energie verbruiken, waardoor deze in eerste instantie vooral geschikt is voor mobiele applicaties. Zo zou de IP op een SoC voor mobiele telefoons geplaatst kunnen worden zodat er 3D-spellen mee gespeeld kunnen worden.

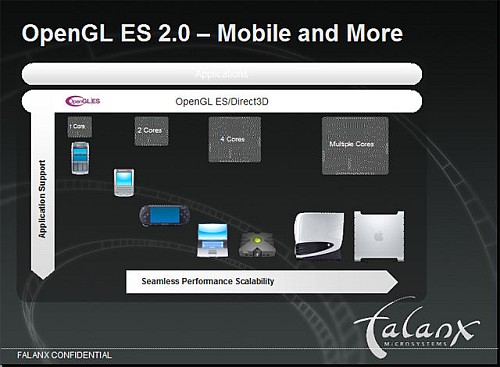

De nieuwe GPU van Falanx heeft een architectuur die gebaseerd is op tile-based-rendering. De voordelen van tile-based-rendering zijn onder andere dat 4X anti-aliasing 'gratis' is (16X is ook mogelijk) en de IP 80% minder geheugenbandbreedte nodig heeft. Daarnaast is het mogelijk om meerder IP's op een chip te combineren, waardoor de Mali200 ook geschikt wordt voor applicaties waarin meer kracht nodig is. Zo zouden twee Mali200-cores samen even krachtig zijn als de GPU in Sony's PSP. Als er nog meer IP's op een chip worden gecombineerd zou er zelfs een GPU mee gebouwd kunnen worden die kan concurreren met de snelste nVidia en ATi GPU's.

Of de Mali200 succesvol zal zijn is moeilijk te zeggen. Falanx levert alleen de IP. Deze zal echter door micro-elektronicafabrikanten geïntegreerd moeten worden in hun producten. Het is dan ook nog maar de vraag of deze IP uiteindelijk ook op de desktop terecht zal komen. Sommige micro-elektronicafabrikanten, waaronder NEC en ST Microelectronics hebben al eerder geprobeerd om een GPU voor de desktop, gebaseerd op een door derden geleverde IP, op de markt te zetten, maar echt succesvol waren ze daarin niet. Daarnaast gaat Falanx concurrentie krijgen van Lucid, een Israëlisch bedrijf dat bezig is geld te verzamelen om een grafische processor te ontwerpen, die ook parallel kan werken.

/i/1250064595.png?f=fpa)

/i/1229874428.png?f=fpa)