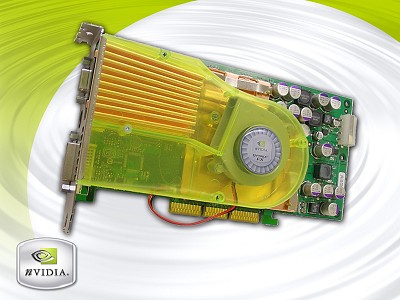

Bij X-Bit Labs is een kort bericht verschenen waarin wordt gemeld dat nVidia heeft bevestigd dat de officiële introductie van de NV31 en NV34 op 6 maart zal plaats vinden tijdens de Game Developer Conference te San Jose. De NV31 is een afgeleide van de GeForce FX met 80 miljoen transistors en vier in plaats van acht rendering pipelines. Er zullen drie versies op de markt komen met kloksnelheden van 250, 300 en 350MHz. De NV34 wordt gebouwd met 45 miljoen transitors en krijgt een kloksnelheid tussen de 300 en 375MHz. Meer informatie zal ongetwijfeld over enkele dagen beschikbaar komen.

:strip_exif()/i/1046991372.jpg?f=fpa)