Google heeft een beveiligingsmaatregel ingeschakeld voor het overgrote deel van de desktopgebruikers van zijn Chrome-browser. Het gaat om de feature site isolation, die moet voorkomen dat kwaadaardige websites gevoelige informatie stelen.

Google meldt dat de functie inmiddels voor 99 procent van de Chrome-gebruikers standaard is ingeschakeld, waarbij de laatste 1 procent wordt gebruikt om prestaties in de gaten te houden en zo nodig te verbeteren. De introductie van de functie vond plaats in versie 67 van Chrome, die eind mei uitkwam. In versie 66 van de browser voerde Google een beperkte test van de functie uit onder gebruikers, maakte het bekend bij de release van die versie. Het was voor zakelijke gebruikers al langer mogelijk om site isolation in te schakelen via een flag. Die mogelijkheid bestond sinds Chrome 63.

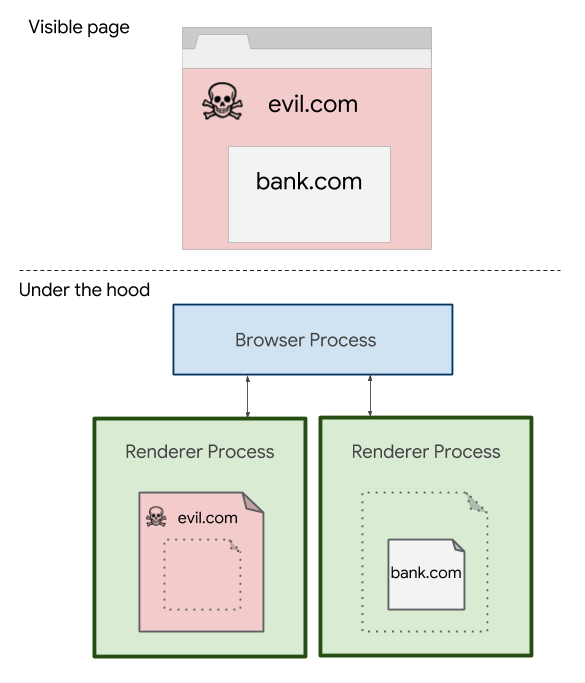

De functie moet voorkomen dat een kwaadaardige website in staat is om gevoelige informatie te stelen van een andere website die geopend is in de browser, aldus Google. Het is een soort 'tweedelijnsverdediging', omdat same origin policy in principe al voorkomt dat websites gegevens van elkaar kunnen inzien. Site isolation gaat verder dan dat, doordat pagina's van verschillende websites in aparte processen en eigen sandboxes worden ondergebracht. Dat geldt onder meer voor tabs en iframes. Volgens Google heeft de maatregel tot gevolg dat Chrome ongeveer tien tot dertien procent meer geheugen gebruikt.

Het bedrijf schrijft dat het door het isoleren van renderer processes per site afhankelijk is van het besturingssysteem om daadwerkelijk aanvallen tussen processen te voorkomen. Voordat de functie in Chrome aanwezig was, werd een iframe van een andere site in hetzelfde proces ondergebracht als dat van de site waarop de gebruiker op dat moment aanwezig was. Dat kon ertoe leiden dat een aanvaller een succesvolle Spectre-aanval kon uitvoeren. Een dergelijke aanval maakt het uitlezen van gevoelige gegevens mogelijk, in de browser bijvoorbeeld cookies of wachtwoorden.

Google zegt dat het nu gaat onderzoeken op welke manier site isolation te integreren is in de mobiele Android-Chrome-browser. Of dat ook in de iOS-versie gebeurt, vermeldt de zoekgigant niet. Google start een experimentele implementatie voor zakelijke gebruikers in versie 68 van de Android-versie. Het bedrijf had al tegenmaatregelen in Chrome geïntroduceerd bij de publicatie van Meltdown en Spectre in januari, bijvoorbeeld door timers minder precies te maken. Deze maatregelen draait het nu weer terug, omdat die dankzij site isolation niet meer nodig zijn.

/i/2003074078.png?f=fpa)

/i/1369161125.png?f=fpa)

/i/2001719489.png?f=fpa)

/i/2001845683.png?f=fpa)

/i/2001665377.png?f=fpa)