Het probleem is dat deze test een niet representatieve test is. Als er vanaf het begin al geargumenteerd wordt dat men onder de < 700watt niet gaat testen, omdat iemand wel eens een tweede vga kaart kan bij stoppen.

Het feit is, 95% van de PC gebruikers hebben genoeg aan een licht systeem. Zelf een Atom330 ( 8Watt ) + Ion GPU ( 12Watt ), waarbij enige 1080p films kunnen gedecodeerd worden door de GPU ( en nu ook al flash ), hebben als effect dat de meeste mensen meer dan genoeg hebben met een 70Watt stroom gebruik.

Dit is ook één van de redenen dat de verkoop van notebooks die van desktops overneemt. Notebooks hebben over het algemeen minder krachtige cpu's / gpu's, maar bieden 100% wat de meeste mensen nodig hebben. Of het nu Atom's, of Mobile Core2's zijn ...

Wat deze test doet, is enkel de tendens van mensen naar zwaardere en zwaardere voedingen te pushen, wanneer het niet eens nodig is.

Wat belangrijk is, is de beste verhouding van het systeem stroom verbruik, vs de efficiëntie van de voeding bij die minimale & maximale verhouding dat het systeem nodig heeft.

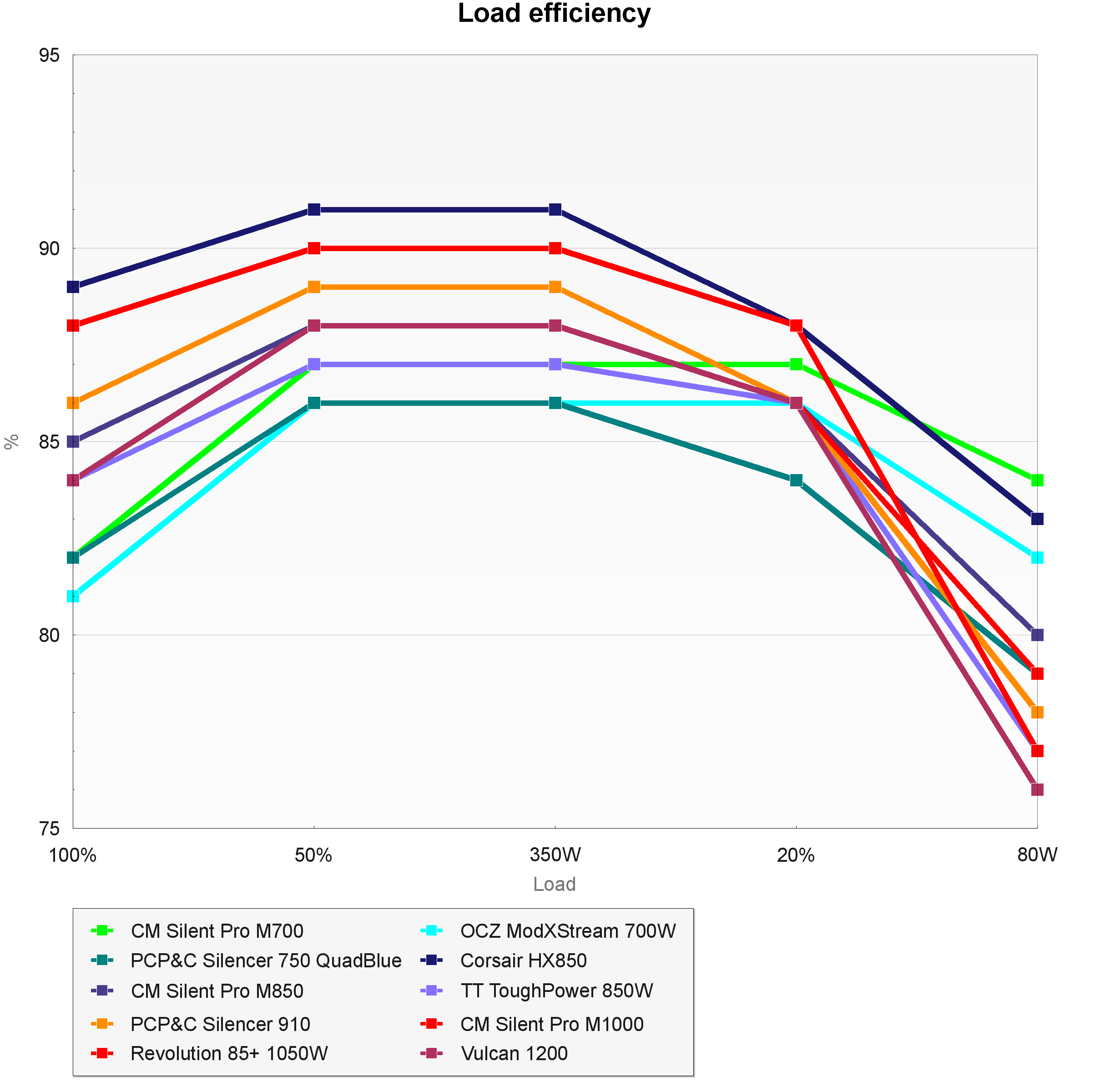

Ik zie hier mensen argumenteren dat een 700Watt voeding nog altijd beter is dan een 450Watt voeding, omdat het een betere curve heeft. Wat is het argument weeral? De 700Watt voeding kan 75% efficiënt maar de 450Watt voeding maar 60% ... Dit is eerste klas BS verhaal.

De verhouding tussen de power curves hangen meer af van de merk, en hoe deftige de voeding in elkaar gestoken is. Je dient deze waarden te nemen, en dan te vergelijken met wat je systeem gebruikt.

De meest systemen gebruiken 100watt a 125watt in idle. En met een zware gpu, mogelijk 200 a 250watt. Welke "idioot" gaat hier een 700Watt voeding in stoppen. De 700Watt voeding, zal op idle, op zijn slechte efficiëntie curve zitten, en bij 250Watt, niet in de buurt zijn van zijn beste performance.

Waartegen een 350 a 400Watt voeding, perfect is voor de setup, dat bijna 99% van de gebruikers draaien.

Ik ben ook geen alledaagse pc gebruiker, maar over de jaren ben ik enorm gefocusseerd geworden voor meer efficiënte pc systemen. Met als gevolg dat ik dozijn pc's getest hebt met mijn trouwe energie meter. Je zou verbaast zijn, dat als je de evolutie van de pc's bekijkt met oudere ( enkel jaren oud ), dat het stroom gebruik niet zoveel verschilt, van de tijden waarin we met 300 a 350watt voedingen zaten.

De grote boosdoener is meer de GPU geworden deze dagen. En zelf die proberen ze nu grondig aan te pakken met betere idle stroom verbruik. Maar in praktijk, zitten de meeste systemen, zelf als je er een SLI zou opzetten, nog onder de 450Watt.

Wat mensen hier ook vergeten, is het feit dat de meest systemen, voor 90% van de tijd, vaak idle draaien! Technische gezien ben je zelf beter af met een voeding, van een laag wattage, welke een goede lage punt curve efficiëntie heeft, en dat in staat is de pieken op te vangen van gaming. Op die pieken moet de voeding daarom niet perfect zijn. Zelf een paar procent op die pieken, gaan vaan niet doorwegen op de meer efficiëntie dat op de idle tijden eruit komt!

Zo dus, gans deze review is letterlijk nutteloos in mijn boekje... 700, 1000, 1200Watt voeding. *zuchts* Als ze een deftige review wenste te doen, had men ook de 300, 350, 450, 500 Watt voedingen moeten testen.

En neem van mij aan, het verschil van voeding tot voeding kan enorm zijn... Een elcheapo 300Watt voeding, was 8Watt minder efficiëntie, en had een in uitstand van de pc, stroom verbruik van 6.5Watt!!! Een andere voeding van 400Watt van iets beter kwaliteit, was dus 8Watt efficiënter op dezelfde stroom verbruik, en had een uitstand gebruik van 1.5Watt. Nog een andere voeding was zelf 0.5Watt in uitstand van de pc.

Dit zijn de gegevens wat mensen nodig hebben. Niet die larie & apekool van 700 a 1200Watt monsters.

Ergste van als is, dat men mensen dat niet beter weten, en zelf mensen dat beter dienen te weten, zoals de helft van de tweakers, het idee verkoopt dat men duurdere voedingen moet pakken... Om toch maar toekomst gericht zeker te zijn.

Zal ik iets vertellen. PC spullen veranderen om de zoveel jaar. Als ik de evolutie bekijk, zijn er genoeg momenten geweest waar zelf de voeding standaard "uitgebreid" is geworden. De 4pin P4 connectors, de 20 naar 24Pin voeding kabel connectors, de IDE naar SATA voedings kabels, de 6 & 8 Pin GPU kabels.

Vaak zal een voeding voor één pc generatie extra kunnen meegaan, voor er weer iets nieuws op de markt komt, waardoor je ofwel moet spelen met convertie stukken, of een nieuwe voeding mag kopen. En zelf dan nog. Om de zoveel jaar wordt de efficiëntie van de voedingen beter. Je koop een 700Watt power monster voor de toekomst.

Binnen 2 jaar komt Nvidia met een 12Pin connector uit voor hun GPU. Of wordt de volgende i7x voorzien van weer een nieuwe connector. En tegen die tijd, zijn de voeding weer iets efficiënter. Al lang geleerd, koop nooit overkill voor een PC, want je betaald je blut.

Of het nu een extreem cpu is, of een extreem gpu... Binnen de 6 maand komt er altijd een goedkopere versie uit van die extreem "toekomst" gerichten producten, dat een pak goedkoper is, met dezelfde of zelf betere prestaties ( en mogelijk minder bugs ).

En laten we eerlijk zijn, ik heb dezelfde discussie gehad met mijn vader. PC's hebben het punt bereikt dat ze gewoon overkill zijn voor 95% van de mensen. En dan spreek ik nog niet over de nieuwe i7 cpu generatie, maar de quad core cpu's etc. Vooral wanneer men begint met het offloaden van de gespecialiseerde taken naar de gpu ( welke ook overkill zijn deze dagen ), is de cpu van bijna werkloos, en is de HD over het algemeen de beperkende factor op de snelheid.

Idem met gpu's... Vaak laat men lekker kwijl benchmarks zien van top prestaties, en kwijl demo's. Koop onze 450€ gpu, zie wat het aankan.. Maar in praktijk gebruik je die kracht voor één game, of zo ( crysis comes to mind ), en de meeste andere games draaien perfect op de wat oudere generatie. En daar zit je met je monster gpu. En 6 maand later, komt de xxx+ versie of whatever uit, dat stroom efficiënter is, even snel, of zelf sneller, en bijna de helft van de prijs kost. En uiteindelijk betaalden die mensen 200€ meer, voor één of twee games te kunnen spelen op een hogere resolutie, en 6 maand later voelen ze zich gepakt...

Idem met voedingen. Wat nodig is, is een goede review voor de gewone man, met de mogelijk uitschieters ( de 500 a 600 Watt range, voor zijn die dubbel of trippel sli willen gaan ). Maar iets zegt me, als je het geld hebt voor dubbel of trippel video kaarten te steken, dat stroom efficiëntie nu ook niet echt je belangrijkste motief is.

Laat dit een les wezen aan de tweaker reviewers. Ken je markt! Leer ook efficiënter review maken, ipv je tijd te verspillen aan iets dat uiteindelijk niemand van nut is, in de "real world".

/i/1260457109.jpeg?f=imagenormal)

:fill(white):strip_exif()/i/1260472441.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260472453.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260472464.jpeg?f=thumbmedium)

/i/1260459909.jpeg?f=imagenormal)

/i/1260459796.jpeg?f=imagenormal)

/i/1260459850.jpeg?f=imagenormal)

/i/1260459890.jpeg?f=imagenormal)

/i/1260459873.jpeg?f=imagenormal)

/i/1260459827.jpeg?f=imagenormal)

/i/1260459764.jpeg?f=imagenormal)

/i/1260459568.jpeg?f=imagenormal)

:fill(white):strip_exif()/i/1260457109.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260459568.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260459764.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260459796.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260459827.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260459850.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260459873.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260459890.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1260459909.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1231159528.jpg?f=thumbmedium)

:fill(white):strip_exif()/i/1252595511.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1257428554.jpeg?f=thumbmedium)

/i/1279783256.png?f=fpa)

:strip_icc():strip_exif()/u/167062/1777paard.jpg?f=community)

:fill(white):strip_exif()/i/1243588728.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1228669245.jpg?f=thumbmedium)

:strip_exif()/i/1242823859.png?f=thumbmedium)

:fill(white):strip_exif()/i/1228765932.jpg?f=thumbmedium)

:fill(white):strip_exif()/i/1247137684.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1240912119.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1251818446.jpeg?f=thumbmedium)