Van al het verkeer op websites, bestaat het overgrote deel uit bots. Dat blijkt uit statistieken die het beveiligingsbedrijf Incapsula onder zijn klanten heeft verzameld. Van de bots heeft slechts de helft goede bedoelingen, stelt Incapsula.

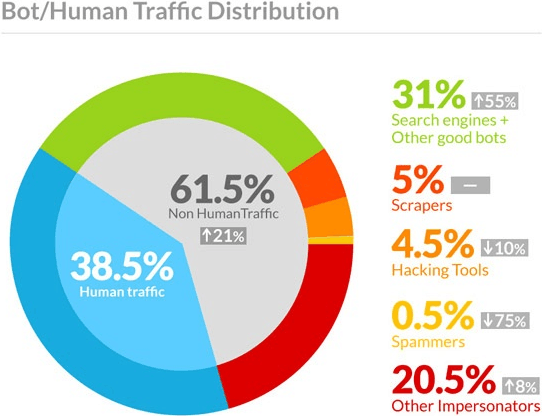

Dit jaar bestond slechts 38,5 procent van het verkeer op websites uit bezoeken van mensen, stelt Incapsula. Vorig jaar was dat nog 49 procent: het verkeer van bots is dus toegenomen van 51 naar 61,5 procent. Het bedrijf, dat als cdn en 'beschermlaag' voor een website fungeert en vergelijkbaar is met het bekendere Cloudflare, verzamelde de gegevens onder zijn klanten, waardoor de gegevens dus niet representatief hoeven te zijn voor alle websites.

Volgens Incapsula bestond 31 procent van het verkeer uit bots met goede bedoelingen. Dan gaat het bijvoorbeeld om bots van zoekmachines, zoals Google. Het verkeer van 'goede' bots nam in het afgelopen jaar bovendien met 55 procent toe. Bij 5 procent gaat het om scrapers. Die kunnen bijvoorbeeld content stelen of e-mailadressen harvesten, waarschuwt Incapsula. Er zijn echter ook scrapers die weinig kwaad in de zin hebben: of die zijn meegerekend met de goede bots of met de scrapers, is onbekend.

Van het verkeer bestaat 4,5 procent uit hackingtools, stelt Incapsula, die bijvoorbeeld sql-injecties proberen te plegen of data proberen buit te maken. In 0,5 procent van de gevallen zou het om spammers gaan, die bijvoorbeeld malafide links in reactievelden dumpen. Twintig procent bestaat volgens Incapsula uit andere 'impersonators', die bijvoorbeeld geavanceerdere ddos-attacks uitvoeren of de bandbreedte van een site opsouperen.

/i/1249634131.png?f=fpa)

/i/1386259508.png?f=fpa)

/i/1292240761.png?f=fpa)

/i/1363774165.png?f=fpa)