Volgens Robison is DirectX 10 vanwege de verplichte combinatie met Windows Vista niet aangeslagen, maar hij zei dat hij verwachtte dat DirectX 11 positiever wordt onthaald. Dat vermoeden baseert hij vooral op de positieve berichten over Windows 7.

Het grote probleem was dat DirectX10 niet voor Windows XP geschikt was. Vooral de overstap op het usermode driver model voor de videokaart (WDDM), maakte het lastig voor Microsoft om DX10 ook voor WinXP uit te brengen. En ook al had het eventueel mogelijk geweest om het toch voor elkaar te krijgen (er zijn namelijk versies door andere uitgebracht die dicht in de buurt komen), was het Microsoft de investering niet waard. Die wil natuurlijk liever nieuwe produkten verkopen, en was op dat moment al lang bezig met Windows 7.

Maar nu DirectX11 voor Win7 uitkomt, en deze dezelfde WDDM gebruikt, is het nu wel mogelijk om het vorige OS van een DX update te voorzien. Er zijn natuurlijk zat gebruikers die vasthouden aan WinXP, maar de meeste gebruikers met een $1k computer gebouwd na 2006 draaien momenteel VistaSP2. Een hoop gamers met wat OS ervaring, draaien momenteel al Windows 7 RC (of RTM), omdat de prestaties hoger liggen door een betere implementatie van WDDM (en andere optimalisaties).

De prestaties van de nVidia G300 series zijn op papier schrikbarend snel, en nVidia is druk bezig om de lancering van daadwerkelijke produkten zo gauw mogelijk te versnellen. Het ziet er namelijk op dit moment naar uit dat ze pas op zijn vroegst klaar zijn in April 2010, en dat zou AMD/ATi een zeer grote voorsprong geven met de Evergreen lancering. De rollen worden dan eigenlijk omgedraaid, omdat nVidia een soortgelijke voorsprong had met de GeForce 8800 series ten tijde van de Vista launch. Echter nVidia heeft de financiële middelen om haast te maken. De normale gang van zaken bij nVidia is nog steeds om eerst met een topmodel op de markt te komen, en daarna de ondermarkt te voorzien. Als de prestaties van Evergreen in verhouding met de G300 echter zwaar meevallen, dan kan nVidia eventueel beslissen om alvast te werken aan een aangepaste G300 versie met minder shaders/etc, die eventueel trager draait en DirectX11 geschikt is.

Daarom is AMD/ATi zo scheutig met daadwerkelijke details en onafhankelijke prestaties. Er wordt dus geen methode getoont die ook door andere gebruikt kan worden, maar wat eigen gemaakte demos. Op het moment dat de NDA wordt opgeheven en talloze websites met benchmark resultaten zullen komen, is het geen paperlaunch, maar zijn produkten vaak meteen te koop in de winkels. AMD/ATi is namelijk al een tijdje bezig met volle produktie, al zullen ze aardig last hebben gehad van de produktieproblemen waar TSMC mee te maken had. Die problemen zijn echter al gedeeltelijk opgelost (yields zijn al 60%+ dacht ik), en er is nog een redelijke tijd voordat de NDA wordt opgeheven.

Het zal niet de eerste keer zijn dat AMD/ATi een launch vervroegt, maar dat zal sterk afhangen op DirectX9 en DirectX10(.1) ook een goede verbetering tonen. De eerste kaart zal eventueel als HD5850 door het leven gaan, omdat de eerste RV7xx GPU als HD4850 werd verkocht, maar dat blijft gissen. Krijgt AMD/ATi het dan echter voor elkaar om met de eerste DirectX11 kaart de top modellen van nVidia te verslaan in DX9/DX10 benchmarks, dan zal er natuurlijk een stormloop ontstaan deze kerst.

Helemaal omdat als het goed is ze nog steeds de intentie hebben om de nieuwe kaart voor $199/€199 in de verkoop te plaatsen. Die prijs zal vast naar de $/€249 oplopen of eventueel nog meer, en er zullen ook talloze OC/custom varianten komen die meer gaan kosten, maar we zullen een zware prijsverlaging gaan zien van vele nVidia topmodellen dan.

Op zijn beurt kan nVidia dan weer terugslaan met de eerste G300 series videokaart, maar dat hangt dus allemaal af van de tijd die ze nodig hebben om hem af te maken. Het is gewoon een zeer trage bokswedstrijd en AMD/ATi heeft de kans voor een goede rechtse hoek

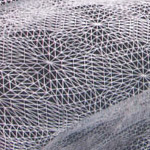

Met een 3d-render van een futuristische tank op een zandheuvel werd gedemonstreerd hoe met de hdao-techniek realistischer schaduwen konden worden weergegeven. Deze rekenintensieve berekening leverde bij het demonstratiesysteem een framerate van ongeveer 20fps op, maar dat kon met de nieuwe compute shaders worden opgekrikt naar ongeveer 44fps. Een parallax occlusion mapping-demo van een soort kasseien leverde een framerate van ongeveer 70fps op, maar de Evergreen-gpu is in staat tot hardware tesselation. Met deze techniek, waarbij polygonen iteratief worden opgesplitst om vloeiender details te krijgen, kon de framerate bijna worden verviervoudigd tot 270fps.

Met een 3d-render van een futuristische tank op een zandheuvel werd gedemonstreerd hoe met de hdao-techniek realistischer schaduwen konden worden weergegeven. Deze rekenintensieve berekening leverde bij het demonstratiesysteem een framerate van ongeveer 20fps op, maar dat kon met de nieuwe compute shaders worden opgekrikt naar ongeveer 44fps. Een parallax occlusion mapping-demo van een soort kasseien leverde een framerate van ongeveer 70fps op, maar de Evergreen-gpu is in staat tot hardware tesselation. Met deze techniek, waarbij polygonen iteratief worden opgesplitst om vloeiender details te krijgen, kon de framerate bijna worden verviervoudigd tot 270fps.

/i/1206089508.png?f=fpa)

:strip_exif()/i/1123776957.jpg?f=fpa)

/i/1252928626.png?f=fpa)

/i/1208164214.png?f=fpa)

:strip_exif()/i/1177429341.jpg?f=fpa)