Het Amerikaanse bedrijf Caustic Graphics claimt dat het raytracing met een factor tweehonderd kan versnellen. Daarvoor heeft het jonge bedrijf een grafische versnellerkaart ontwikkeld die met OpenGL-extensies wordt bediend.

Caustic Graphics, dat is opgericht door een aantal voormalig Apple-medewerkers, heeft de CausticOne-kaart ontwikkeld om het afhandelen van raytracing-opdrachten grotendeels van de cpu over te nemen. De versnellerkaart zou het raytrace-proces - waarbij de weergave van een 3d-omgeving wordt berekend aan de hand van zaken als lichtinval en kijkhoek - met een factor twintig kunnen versnellen. De winst wordt behaald door de benodigde berekeningen efficiënter naar de beschikbare cpu's en gpu's te sturen. Daarvoor heeft Caustic naar eigen zeggen verbeterde raytracing-algoritmen ontwikkeld en deze ondergebracht in een speciale grafische co-processor op de kaart, die nog dit jaar op de markt moet komen. Begin 2010 verwacht het bedrijf met een tweedegeneratie-acceleratorkaart de rendersnelheid zelfs met een factor tweehonderd te kunnen verhogen, wat onder bepaalde omstandigheden betekent dat raytracing-beelden realtime gerenderd kunnen worden.

Caustic Graphics, dat is opgericht door een aantal voormalig Apple-medewerkers, heeft de CausticOne-kaart ontwikkeld om het afhandelen van raytracing-opdrachten grotendeels van de cpu over te nemen. De versnellerkaart zou het raytrace-proces - waarbij de weergave van een 3d-omgeving wordt berekend aan de hand van zaken als lichtinval en kijkhoek - met een factor twintig kunnen versnellen. De winst wordt behaald door de benodigde berekeningen efficiënter naar de beschikbare cpu's en gpu's te sturen. Daarvoor heeft Caustic naar eigen zeggen verbeterde raytracing-algoritmen ontwikkeld en deze ondergebracht in een speciale grafische co-processor op de kaart, die nog dit jaar op de markt moet komen. Begin 2010 verwacht het bedrijf met een tweedegeneratie-acceleratorkaart de rendersnelheid zelfs met een factor tweehonderd te kunnen verhogen, wat onder bepaalde omstandigheden betekent dat raytracing-beelden realtime gerenderd kunnen worden.

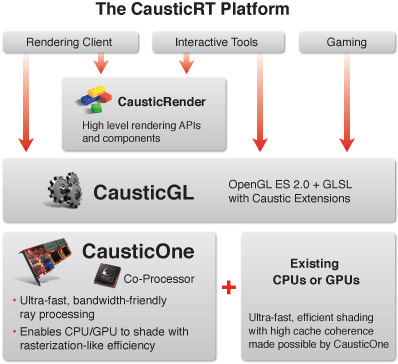

Om zijn nieuwe raytracing-platform geaccepteerd te krijgen, moet Caustic Graphics proberen om in korte tijd belangrijke spelers uit de game- en 3d-wereld achter zijn CausticRT-platform te krijgen. Daarvoor heeft het bedrijf onder andere de CausticGL-api ontwikkeld, die op OpenGL ES 2.0 is gebaseerd. De api moet ontwikkelaars onder andere in staat stellen om de hardware direct vanuit games aan te spreken. Toch zal het voor de startup nog een hele toer worden om juist deze markt voor zich te winnen, aangezien de belichting in veel spellen pas bij de vertaalslag naar 2d-beelden wordt toegevoegd. Bovendien werd bijvoorbeeld de PhysX-technologie, die in eerste instantie eveneens aparte hardware vereiste, pas succesvol toen Nvidia ontwikkelaar Ageia overnam en de physics-code vertaalde naar gpu-instructies. Overigens is deze fabrikant met de overname van de firma Raytracing ook actief in dit vakgebied.

:strip_icc():strip_exif()/i/1291899088.jpeg?f=fpa_thumb)

:strip_exif()/i/1268300776.jpeg?f=fpa)

/i/1242207182.png?f=fpa)