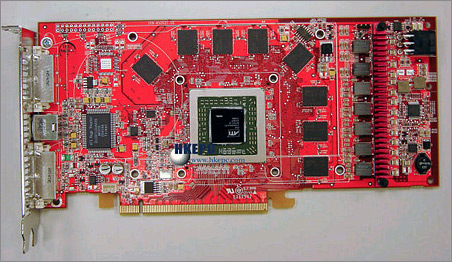

Op de Chineestalige website HKEPC zijn de eerste foto’s verschenen van ATi’s nieuwste videokaart, de Radeon X1900. Deze kaart is gebaseerd op de R580-chip en zal naar verwachting rond 24 januari officieel geïntroduceerd worden. Uit de foto blijkt dat de chip aanzienlijk groter is dan zijn voorganger, de R520, iets dat geen verrassing is gezien de specificaties. De chip krijgt namelijk de beschikking over 48 pixel processors en 8 of meer vertex processors. De exacte specificaties zijn nog niet bekend, maar verwacht wordt dat het topmodel een kloksnelheid krijgt van 650MHz en het geheugen zijn werk zal doen op 1550MHz. ATi zal initieel enkele verschillende modellen X1900-kaarten introduceren, waaronder één CrossFire-model.