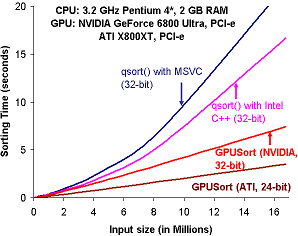

Onderzoekers van de University of North Carolina in de Verenigde Staten hebben de snelheid waarmee GPU's en CPU's kunnen sorteren vergeleken. Hiervoor hebben de onderzoekers zelf een sorteeralgoritme voor de GPU geschreven, GPUSort genaamd. Dit algoritme kan 32bits drijvende komma getallen sorteren. Uit de resultaten blijkt dat een PCI Express nVidia GeForce Ultra 6800 Ultra met gemak een 3,2GHz Pentium 4 met 2GB aan geheugen verslaat. Nog indrukwekkender is de snelheid van een PCI Express ATi Radeon X800XT, deze sorteert namelijk twee keer zo snel als de GeForce 6800 Ultra.

Verder hebben de onderzoekers het nieuwe sorteeralgoritme vergeleken met andere algoritmen, Purcel en Kipfer, voor GPU's. Hieruit blijkt dat GPUSort het snelste sorteeralgoritme voor GPU's is, dat op dit moment bestaat. Purcel en Kipfer gebruikten echter de normale pipeline van de GPU om te sorteren. GPUSort maakt echter alleen gebruik van simpele texture mapping instructies. Daarnaast is de toegang tot het videogeheugen in GPUSort geoptimaliseerd. Het lijkt er dus op dat de toepassing van een GPU voor andere zaken dan het renderen van beelden weer een stap dichterbij is gekomen.