Iedereen kent wel het beeld van een sciencefictionserie met pratende computers die de moeilijkste berekeningen en ingewikkeldste data in enkele milliseconden uitrekenen en die aangedreven worden door ingewikkelde energiebronnen zoals warppower of ruimte-energiegolven. Zoals de naam van dit genre al aangeeft, is deze fictie sterrenstelsels verwijderd van hoe het in de huidige ruimte-expedities daadwerkelijk met de computerkracht gesteld is. Op het gebied van processors is het juist zo dat simpelheid wordt geprefereerd boven snelheid en rekenkracht. Om een raket recht de lucht in te krijgen is niet enorm veel rekenkracht nodig en de precieze baan is altijd nog bij te stellen wanneer deze in de lucht is. Hiervoor is het wel belangrijk dat de berekeningen enorm precies zijn, maar snelheid is geen probleem.

Bovendien moeten de computers enorme versnellingskrachten weerstaan; dit is makkelijker wanneer ze zo simpel mogelijk gehouden worden. Een aantal decennia na de eerste bemande ruimtevluchten zou men verwachten dat de gebruikte apparatuur enorm up to date zou moeten zijn. Niets is minder waar: de vandaag de dag gebruikte Orbiter heeft de beschikking over vier parallelle redundante IBM AP101S-computers, met een vijfde als onafhankelijke backup. Deze allroundcomputers worden al gebruikt sinds het begin van de jaren tachtig. Het nieuwe ruimtestation ISS maakt gebruik van een even zo moderne technologie en beschikt over een aantal “hypermoderne” 80-386SX processors. Dat er voor de berekeningen van de koers van het schip geen modernere apparatuur nodig is, wil niet zeggen dat er geen snellere apparaten aan boord zijn.

De snellere computers aan boord worden meegebracht door de astronauten zelf: het zijn de laptops die zij onder andere gebruiken voor hun experimenten. Een aantal redenen om de boordcomputer niet up te graden zijn ten eerste het feit dat een upgrade niet nodig is: de oude computers doen nog prima hun werk. Bovendien hebben de nieuwere processors vele malen meer energie nodig dan hun oudere voorgangers, en energie is een schaars goed in de ruimte. Een derde punt is dat de oude rekenkernen minder warmte produceren en ook hier minder energie nodig hebben om deze warmte af te drijven. Ten slotte ondervinden de CPU’s last van de verhoogde straling in de ruimte in vergelijking met de straling op aarde. Hoe minder componenten een chip heeft, hoe minder last hij zal ondervinden van deze straling.

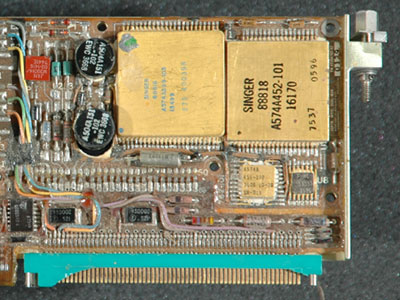

Dit is een extra reden om de chips zo simpel mogelijk te houden. Bipolaire transistors worden ook gebruikt in deze componenten, omdat zij beter bestand zijn tegen de straling. Een voorbeeld van deze verharde chips is te vinden in de Marsverkenners Spirit en Opportunity, die werkzaam zijn op de RAD6000, een verharde versie van IBM’s Power CPU. De derde verkenner Pathfinder maakt gebruikt van een verharde CMOS-versie van de Intel 8085. Voor wat betreft de dataopslag heeft de ruimtevaartindustrie de afgelopen jaren ook een beetje stil gezeten. In plaats van de op de grond gebruikte harde schijven, die niet werken in een vacuüm, maakt men buiten de dampkring nog gebruik van tapedrives.

Dit is een extra reden om de chips zo simpel mogelijk te houden. Bipolaire transistors worden ook gebruikt in deze componenten, omdat zij beter bestand zijn tegen de straling. Een voorbeeld van deze verharde chips is te vinden in de Marsverkenners Spirit en Opportunity, die werkzaam zijn op de RAD6000, een verharde versie van IBM’s Power CPU. De derde verkenner Pathfinder maakt gebruikt van een verharde CMOS-versie van de Intel 8085. Voor wat betreft de dataopslag heeft de ruimtevaartindustrie de afgelopen jaren ook een beetje stil gezeten. In plaats van de op de grond gebruikte harde schijven, die niet werken in een vacuüm, maakt men buiten de dampkring nog gebruik van tapedrives.

In de nieuwe Cassini, die op dit moment rond Saturnus cirkelt, wordt echter gebruikgemaakt solid state recorders. Als werkgeheugen wordt magnetic core geheugen gebruikt, omdat dit bestand is tegen straling. Voor de toekomst is het echter nog maar de vraag of de trend van oude computers in de ruimte zal blijven voortbestaan. Veel individuen en bedrijven ontwikkelen ruimtecomputers die zijn opgebouwd uit hedendaagse hardware. Bij de satellieten Pong en Cube is gebleken dat deze moderne hardware beter bestand is tegen de ruimte-invloeden dan voorheen werd gedacht. Dit zou de deur kunnen openen tot een revolutie wat betreft het gebruik van moderne computers buiten de Aarde.

:strip_icc():strip_exif()/i/1344009829.jpeg?f=fpa_thumb)

/i/1261474170.png?f=fpa)

/i/1296553521.png?f=fpa)