Facebook heeft de software die het in zijn apps gebruikt om de bestandsgrootte van foto's voor het uploaden te verkleinen, open source gemaakt. Andere ontwikkelaars mogen Spectrum ook gebruiken, als zij dat willen.

De software heeft de naam Spectrum en staat op GitHub. De software maakt bestanden voor het uploaden kleiner om zo het uploaden betrouwbaarder te maken en het datagebruik van de app te verminderen, meldt Facebook. De software is nu meer nodig dan voorheen, omdat de bestandsgrootte van foto's van smartphones steeds meer toeneemt, met de komst van camera's met hoge resoluties.

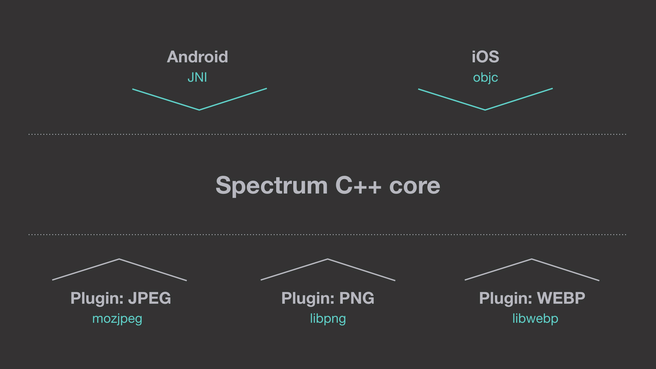

Facebook heeft de software ontwikkeld in C++, met een klein laagje Java voor Android-apps en Objective-C voor iOS. Daardoor moet het makkelijk zijn om aanpassingen in de code naar beide besturingssystemen te pushen zonder al te veel moeite. Afbeeldingen zouden 15 procent kleiner worden met de encoding van Spectrum, claimt het bedrijf. Het is niet de eerste keer dat Facebook code van een project op GitHub zet. Het heeft afgelopen jaren tientallen projecten open source beschikbaar gemaakt.

/i/1278589047.png?f=fpa)

/i/2001904313.png?f=fpa)

:strip_exif()/i/1294081930.gif?f=fpa)

/i/2000593550.png?f=fpa)