Volgens Belgische beveiligingsonderzoekers bevat https een lek dat het mogelijk maakt om met een javascript persoonlijke gegevens te achterhalen. Het script zou in een advertentie verwerkt kunnen worden. De onderzoekers presenteren hun bevindingen op Black Hat.

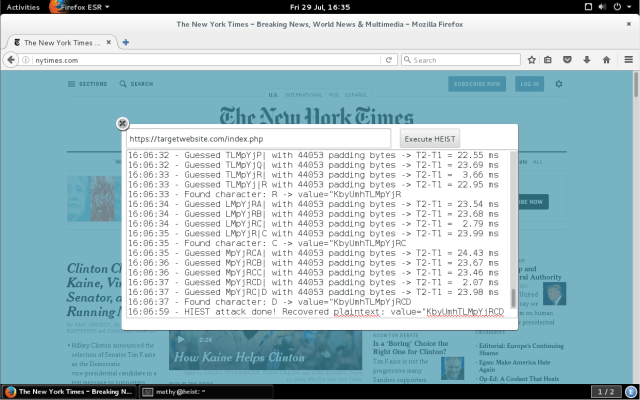

Voor de aanval is geen man-in-the-middle-positie nodig. Kwaadwillenden kunnen volgens onderzoekers Tom Van Goethem en Mathy Vanhoef van KU Leuven simpelweg een advertentie plaatsen met daarin een kwaadaardig javascript. De code kan vervolgens op de beveiligde pagina's exact meten hoe groot de versleutelde data is die wordt verstuurd.

Met de hulp van twee andere exploits, bekend als Breach en Crime, is het mogelijk om aan de hand van de grootte sommige data te ontsleutelen. Dat is mogelijk door kwetsbaarheden die zitten in de manier waarop websites data comprimeren om ze sneller te laten laden.

De onderzoekers geven de methode de naam Heist, wat staat voor HTTP Encrypted Information can be Stolen Through TCP-Windows. Op de Black Hat-beveiligingsconferentie zullen de onderzoekers hun bevindingen demonstreren aan de hand van een kwaadaardige advertentie op de New York Times-website.

Van Goethem stelt dat hij als hij er tijd in zou steken met de methode 'een hoop ellende' zou kunnen veroorzaken. Volgens de onderzoeker zou de combinatie van Heist en Breach het voor aanvallers mogelijk maken om csrf-tokens uit te lezen. Afhankelijk van de functionaliteit die de website aanbiedt, zou dat de aanvaller toegang kunnen geven tot het volledige account van het slachtoffer.

Het lijkt onwaarschijnlijk dat de kwetsbaarheid eenvoudig ingezet kan worden voor aanvallen op grote schaal. De code moet specifiek per website zijn geschreven en de methode vereist een groot aantal requests. Websites die dergelijke verzoeken in de gaten houden, zullen deze vermoedelijk tegenhouden.

De onderzoekers hebben Google en Microsoft vooraf ingelicht over hun bevindingen. Volgens Van Goethem is de exploit op dit moment enkel tegen te houden door third-party-cookies te blokkeren.

Update 15.23 uur: De onderzoekers hebben hun presentatie en het volledige onderzoek online gezet.

:strip_exif()/i/1185182814.gif?f=fpa)

/i/1316504693.png?f=fpa)

/i/1355322651.png?f=fpa)

:strip_exif()/i/1260262875.gif?f=fpa)

:strip_exif()/i/1263563744.gif?f=fpa)

:strip_exif()/i/1134409850.gif?f=fpa)

:strip_exif()/i/1297080812.gif?f=fpa)

:strip_exif()/i/1298020644.gif?f=fpa)

/i/2000900259.png?f=fpa)

/i/2000809531.png?f=fpa)