Google zet zijn compressie-algoritme in de aankomende release van zijn browser Chrome. Brotli moet vooral statische content op https-sites efficiënter kunnen inpakken. De integratie van Brotli zal echter voorlopig het browsen niet sneller maken, zoals veel media beweren.

Dat de aankomende integratie van Brotli in Chrome het laden van websites sneller zal maken, staat onder meer op Nu.nl en Android Planet, die dat op hun beurt lijken te hebben overgenomen van Engadget. Dat kan echter alleen gelden als bezoekers sites bezoeken die content aanbieden die gecomprimeerd is met Brotli. Dat geldt momenteel voor vrijwel geen enkele site. Bovendien werkt Brotli alleen voor https-verkeer en niet voor regulier bezoek aan veel sites. Google zou wel snel zijn eigen servers kunnen uitrusten met Brotli-ondersteuning.

Dat de aankomende integratie van Brotli in Chrome het laden van websites sneller zal maken, staat onder meer op Nu.nl en Android Planet, die dat op hun beurt lijken te hebben overgenomen van Engadget. Dat kan echter alleen gelden als bezoekers sites bezoeken die content aanbieden die gecomprimeerd is met Brotli. Dat geldt momenteel voor vrijwel geen enkele site. Bovendien werkt Brotli alleen voor https-verkeer en niet voor regulier bezoek aan veel sites. Google zou wel snel zijn eigen servers kunnen uitrusten met Brotli-ondersteuning.

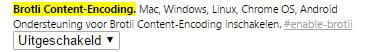

Er lijkt Brotli-ondersteuning te komen in nginx. Veel sites gebruiken niet nginx, maar Apache of IIS, die beide dus voorlopig geen ondersteuning voor Brotli lijken te krijgen. Google zal zijn compressie-algoritme inbouwen in versie 49 van Chrome en nu is de functie dus al te gebruiken in de Canary-versie van de browser, die bij versie 50 zit. Brotli is daarin handmatig aan te zetten door het typen van chrome://flags#enable-brotli in de adresbalk en in de dropdown 'ingeschakeld' of 'enabled' te selecteren.

Als veel servers Brotli gaan ondersteunen, kan dat wel degelijk een positief effect hebben op onder meer de tijd die het kost om pagina's te laden bij trage verbindingen en het dataverbruik. Onder meer Cloudflare heeft al benchmarks gedaan op een testserver om de prestaties van Brotli te meten ten opzichte van onder meer gzip. Wanneer een groot deel van de servers content gaan comprimeren met Brotli, is momenteel niet duidelijk. Wel is bekend dat ook Mozilla het algoritme wil gaan gebruiken in Firefox.

Google kondigde zijn algoritme voor compressie in september aan, terwijl een Google-engineer op Google+ liet weten dat het in Chrome zou komen.

/i/2000609487.png?f=fpa)

/i/1349947172.png?f=fpa)

/i/1361875630.png?f=fpa)

/i/1380353962.png?f=fpa)

/i/1300877312.png?f=fpa)

/i/1375792693.png?f=fpa)

/i/2000658159.png?f=fpa)