Inleiding: het volgende station

De vooruitgang in de telecomsector heeft wel wat weg van een hogesnelheidstrein zonder remmen. De eerste telefoon met een dualcore-soc werd in januari 2011 gepresenteerd en ging in april in de verkoop. Naar alle waarschijnlijkheid gaan we nog deze maand de eerste telefoons met quadcore-socs zien: onder meer HTC en LG staan op het punt om hun eerste quadcoretoestellen uit te brengen.

De snelheid waarmee de quadcores de dualcores opvolgen, wijst erop dat de telefoonfabrikanten elkaar de loef proberen af te steken met de indrukwekkendste specificaties. Hoe de quadcoretelefoons ten opzichte van eerdere toestellen presteren, zullen we echter moeten afwachten. We hebben tot dusver alleen nog maar benchmarkresultaten van de Asus Transformer Prime-tablet, de eerste Android-tablet met een quadcoreprocessor.

In dit verhaal staan we even stil bij de ontwikkelingen. Want: waarom zijn telefoons met quadcoreprocessor nodig? Bieden ze wel iets extra's ten opzichte van dualcores?

De weg naar quadcore

Een paar jaar geleden waren er nog maar nauwelijks smartphones en degenen die er waren, verkochten maar matig. Bedrijven investeerden daarom minder in smartphones dan nu, en dat had weer tot gevolg dat de innovaties op hard- en softwaregebied elkaar maar langzaam opvolgden.

Dat is nu wel anders: de ontwikkelingen in de telecomindustrie gaan zo hard, dat het nog maar de vraag is hoe lang de fabrikanten dit volhouden. Er komt een punt waarop smartphoneverkopen stabiliseren en de inkomsten daardoor stagneren. Zowel fabrikanten als chipmakers zullen hun r&d-budgetten dan vermoedelijk bijstellen.

Daar komt bij dat vernieuwende toestellen lang niet altijd goed verkopen. Toestellen als de Toshiba TG01 - de eerste smartphone met een 1GHz-processor - en de LG Optimus 2X Speed - de eerste smartphone met een dualcore-processor - waren niet erg succesvol.

Daar komt bij dat vernieuwende toestellen lang niet altijd goed verkopen. Toestellen als de Toshiba TG01 - de eerste smartphone met een 1GHz-processor - en de LG Optimus 2X Speed - de eerste smartphone met een dualcore-processor - waren niet erg succesvol.

Toch zijn die twee toestellen mijlpalen in de telecomgeschiedenis. De Qualcomm QSD8250 uit de TG01 was niet alleen de eerste soc die de 1GHz-barrière doorbrak, maar ook de eerste soc op basis van de Scorpion-processorcore, die nog steeds in nieuwe processors wordt gebruikt. Pas dit jaar zal Scorpion worden afgelost door de Krait, een ontwerp dat zuiniger en sneller moet zijn.

/i/1235639907.jpeg?f=imagenormal)

Ongeveer tegelijkertijd kwam ARM met de Cortex A8. Deze markeerde de overgang van de ARMv6- naar de efficiëntere en zuinigere ARMv7-architectuur.

ARM heeft diverse processorcores op basis van de ARMv7-architectuur ontwikkeld. De Cortex A8 is bekend van onder meer de Samsung Hummingbird van de Galaxy S en de Apple A4 van de iPhone 4. De Cortex A9, het eerste ontwerp dat multicore-processors ondersteunt, werd gebruikt voor chips als de Samsung Exynos 4210 uit de Galaxy S II en de Apple A5 uit de iPhone 4S. De Cortex A15, de opvolger van de A9, zal vermoedelijk medio dit jaar voor het eerst in hardware opduiken. De eerste quadcores, die we deze maand gaan zien, zullen nog geen Cortex A15-processors zijn, maar quadcore-varianten van de Cortex A9.

De soc: het hart van een smartphone

Als er gesproken wordt over dualcore, quadcore en kloksnelheden, gaat het alleen over de applicatieprocessors. Maar er is veel meer: alle moderne smartphones beschikken over een zogenoemde system on-a chip, afgekort tot soc.

Op deze soc zitten naast de applicatieprocessor(s) ook de grafische processor, een geheugencontroller, een i/o-controller, signaalprocessors voor multimedia en, afhankelijk van de chip, onderdelen die de ontvangst van gsm, 3g, wifi, bluetooth, gps, fm-radio en dergelijke regelen.

Door deze onderdelen in een enkele chip te integreren, is het mogelijk om een kleinere behuizing te gebruiken. Ook zijn de afstanden tussen de onderdelen kleiner, wat het stroomverbruik kan verminderen. Een nadeel is dat de fabrikant een soc niet zelf kan aanpassen aan de specifieke eisen van een telefoon.

Daarmee bepaalt een soc niet alleen wat een smartphone kan, maar ook wat hij niet kan. De soc dicteert de maximale resolutie van het scherm, de maximale resolutie van foto's en video's die de camera kan produceren en vaak ook welke netwerken worden ondersteund.

/i/1256225012.jpg?f=imagenormal)

Een stiekeme vijfde core

Dit artikel gaat over quadcores, maar schijn bedriegt: alle quadcore-socs lijken een vijfde processorkern te krijgen. Deze companion core is lager geklokt en gebruikt minder energie dan de andere vier. Hij wordt ingezet voor lichte taken, die dan kunnen worden afgehandeld zonder dat een van de snelle cores een aanslag op de accu pleegt.

De implementatie van de vijfde core is bij alle socs anders. De Nvidia Tegra 3 heeft een vijfde Cortex A9-core. Deze draait maximaal op 500MHz en heeft een ander type transistors, waardoor het stroomverbruik lager is dan dat van de andere cores op dezelfde kloksnelheid. Als deze kern hoger zou worden geklokt, zou het stroomverbruik echter hoger zijn; vandaar dat Nvidia in dezelfde soc verschillende transistortypes toepast.

Samsung gaat waarschijnlijk de standaardimplementatie van ARM gebruiken, waarbij voor de vijfde core een Cortex A7 wordt gebruikt. Die is veel minder krachtig dan een Cortex A9, maar ook weer zuiniger. Dit concept is 'big.Little' gedoopt.

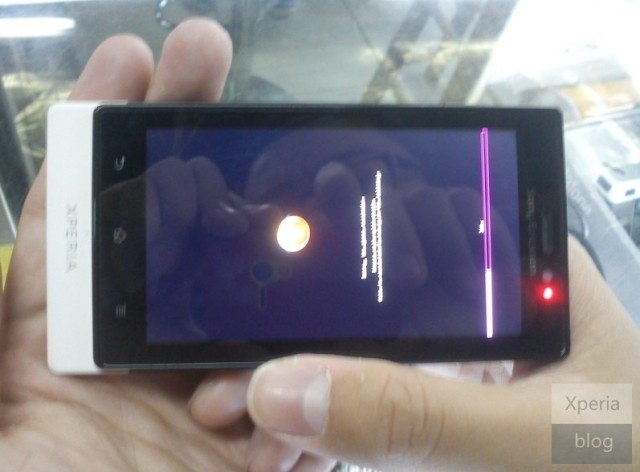

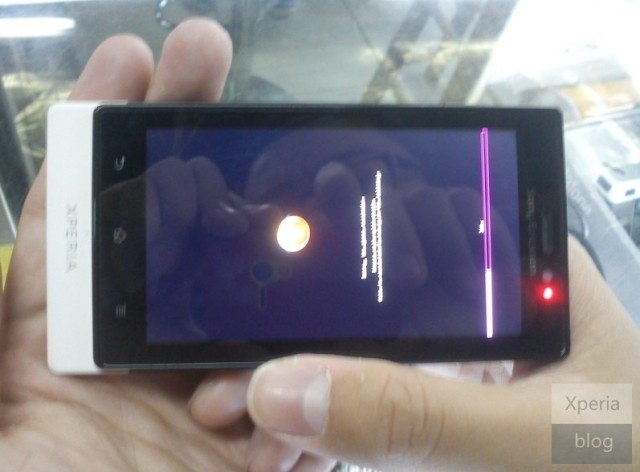

/i/1328020478.jpeg?f=imagenormal)

Texas Instruments heeft het concept met verschillende cores op een soc nog wat verder doorgevoerd. In de dualcore Omap4470 zitten twee Cortex A9-cores maar ook twee Cortex M3-cores om lichte taken van de A9's over te nemen. In de nog te verschijnen Omap5-serie worden twee Cortex A15-cores en twee Cortex M4-cores gebruikt. TI heeft echter nog geen 'echte' quadcores aangekondigd en loopt daarmee enigszins uit de pas.

De extra cores maken in elk geval dat de energiehongerige Cortex A9-cores niet gebruikt worden als dat niet nodig is. Dat levert uiteraard vooral voordeel op als de smartphone niet gebruikt wordt, maar het is nog onduidelijk hoe groot dat voordeel is.

De eerste quadcores

Nvidia's Tegra 2, bekend van onder meer de LG Optimus 2X Speed en Android Honeycomb-tablets als de Samsung Galaxy Tab 10.1 en de Asus Transformer, was de eerste dualcore die in productie werd genomen.

De Tegra 3 was op zijn beurt de eerste quadcore die zijn weg naar de winkel vond: vorige maand kwam de Asus Transformer Prime uit, de eerste tablet met een quadcore-soc. Het grootste verschil tussen de Tegra 2 en de Tegra 3 - naast het aantal cores - is dat de Tegra 3 dynamische kloksnelheden heeft: niet alle cores draaien altijd op dezelfde kloksnelheid. Bij de Tegra 2 is dat wel het geval, met een hoger energieverbruik als gevolg. Daarnaast heeft de Tegra 3 dus een zuinige companion core voor achtergrondtaken.

De gpu is nog altijd een ultra low power-GeForce, die drie keer zo krachtig zou zijn als de grafische processor van de Tegra 2. Dat is een behoorlijke, maar geen wereldschokkende verbetering. De Tegra 3 ondersteunt verder ddr3-geheugen en de maximale grootte daarvan is opgeschroefd van 1GB naar 2GB. De soc wordt nog altijd op 40nm gebakken, wat weer een nadeel op het gebied van vooral energieverbruik is.

Andere fabrikanten werken uiteraard ook aan quadcores in ontwikkeling. Samsung komt binnenkort met de Exynos 4412, een soc met vier Cortex A9-cores. Het typenummer wijst erop dat deze soc op 32nm wordt gebakken, en niet op 45nm, zoals de Exynos 4210. De gpu is vermoedelijk een Mali T604-quadcore.

Ook Apple zou aan een quadcore-soc werken. Deze A6 zou vier Cortex A9-kernen bevatten en met 28nm-technologie worden geproduceerd, maar verder is nog niks over deze chip bekend. De gpu zal vermoedelijk een PowerVR SGX544MP4 worden, die tot 16 cores kan omvatten. De Apple A5, die in de iPhone 4S en de iPad 2 wordt gebruikt, heeft twee Cortex A9-kernen een SGX543MP2-gpu.

Nieuwe dualcores

De komende tijd zullen we nog vooral nieuwe dualcores zien. Dat lijkt geen stap vooruit ten opzichte van de socs als de Tegra 2 en de Qualcomm MSM8260, maar deze chips zijn wel degelijk beter dan de huidige dualcores.

De MSM8960 en de MSM8260A van Qualcomm zijn bijvoorbeeld dualcores met de Krait-core. Deze chips worden gebakken op 28nm en krijgen met de Adreno 225 een nieuwe gpu. De overstap naar quadcores maakt Qualcomm pas met de APQ8064, maar die is niet voor gebruik in smartphones. Qualcomm heeft nog geen quadcores voor smartphones aangekondigd.

Texas Instruments is eveneens nog niet klaar om quadcores te leveren. De Omap5-serie ondersteunt weliswaar vier processorkernen, maar de aangekondigde modellen hebben er maar twee. De socs zijn wel al gebaseerd op het Cortex A15-ontwerp. Samsung heeft de dualcore Exynos 5250 in de coulissen staan. Deze 32nm-soc heeft net als de Omap5 twee Cortex A15-kernen.

Ook minder bekende fabrikanten zijn bezig met nieuwe dualcores. Halfgeleiderfabrikant ST-Ericsson wil dit jaar bijvoorbeeld zijn NovaThor-dualcores groots lanceren. Onder andere Samsung en Sony zullen de NovaThor U8500-soc voor goedkopere modellen gebruiken.

Het nut van meer cores

Je zou kunnen denken dat een quadcore-processor in een telefoon overkill is. We vragen echter steeds meer van onze smartphones, dus het is nog maar de vraag of een viertal kernen echt overbodige luxe is. Een telefoon met een quadcore kan simpelweg meer werk verzetten. Daar staat tegenover dat, als alle cores tegelijk voluit worden belast, de accu in minder dan geen tijd leeg is.

Algemeen wordt verondersteld dat vier processorkernen de interface vloeiender maken: apps zullen sneller starten en multitasken werkt beter. En het lijkt tegenstrijdig, maar bij gelijke belasting zou een quadcore ook langer met een acculading moeten doen.

Systeemprocessen op de achtergrond

Android - de specsheetrace vindt vooral plaats op Googles mobiele platform, omdat de andere besturingssystemen met een enkele processor in het achterhoofd worden ontwikkeld - handelt veel systeemtaken op de achtergrond af.

Een van die taken is garbage collection. Hiermee gaat het systeem na of geheugen dat door programma's is gebruikt, alweer is vrijgekomen. Dat vraagt uiteraard aandacht van de processor en gebeurt met grote regelmaat, en op de achtergrond. Als het goed is heeft de gebruiker hier geen last van, al gaat dat niet altijd goed: bij Android Honeycomb kreeg garbage collection soms voorrang boven het renderen van de interface, waardoor lag optrad. Extra cores zorgen ervoor dat dit proces op het juiste moment kan worden uitgevoerd, en zonder dat de telefoon de hik krijgt.

Als je maar een enkele core tot je beschikking hebt, moeten zulke taken zeer zorgvuldig geprioriteerd worden. Dan nog heeft de processor minder tijd voor andere taken, zoals het draaien van een browser of het ophalen van gegevens. Met twee cores is dat probleem al deels uit de weg, omdat het werk over beide kernen kan worden verdeeld. Met vier kernen is er uiteraard nog minder kans dat er werk in een wachtrij moet worden gezet.

'Snel' of 'snel leeg'?

Het liefst zou iedereen willen dat een telefoon het een week of langer met een acculading uithoudt. Voor een apparaat waarmee je belt, sms't, mailt, browset, chat en gamet, is dat echter wel wat veel gevraagd. Veel smartphones moeten elke avond aan de lader.

Op het eerste gezicht zou je denken dat een telefoon alleen maar sneller leeg gaat als er nog meer energieverbruikende cores in worden gestopt. Dat is dus te kort door de bocht: quadcore-socs zouden juist minder van de accu vragen.

Op het eerste gezicht zou je denken dat een telefoon alleen maar sneller leeg gaat als er nog meer energieverbruikende cores in worden gestopt. Dat is dus te kort door de bocht: quadcore-socs zouden juist minder van de accu vragen.

Ten eerste kan bij zware taken de last verdeeld worden over meerdere cores, die daardoor op een lagere kloksnelheid en een lager wattage kunnen werken. Daardoor vragen ze elk minder energie van de accu.

Daar komt bij dat een companion core voor een lager verbruik zorgt als de telefoon niet wordt gebruikt. Omdat telefoons gedurende school- en werkdagen vaak urenlang ongebruikt blijven, kan dat een verschil maken. Uiteraard kan dit concept ook bij singlecore- en dualcore-soc worden gebruikt, zoals met de Cortex M3-cores in Texas Instruments' Omap4470.

Hoe nieuwer de soc, hoe beter vaak ook de procestechnologie waarmee de chips worden gebakken. Een kleinere feature length zorgt ervoor dat componenten en afstanden kleiner zijn en dus minder energie nodig hebben. De Qualcomm MSM8960 heeft bijvoorbeeld kleinste details van 28nm, en dat leidt direct tot een langere accuduur dan bijvoorbeeld bij een 45nm-chip.

Toch betekent zuinigheid niet dat je ineens dagenlang je smartphone kan gebruiken zonder naar een stopcontact te hoeven. Een krachtigere, snellere telefoon nodigt immers ook uit tot meer gebruik - en high-end smartphones worden meestal toch al gekocht door intensieve gebruikers.

Tot slot is de accuduur voor een flink deel afhankelijk van de kwaliteit van de software. Telefoonfabrikanten brengen nieuwe hardware graag zo snel mogelijk op de markt, en het is niet ongebruikelijk dat de bijbehorende software bij de release nog bugs bevat. Een goed voorbeeld is de Nokia Lumia 800: Nokia gebruikte daarin voor het eerst een Qualcomm-processor, en er moesten twee updates aan te pas komen om de accuduur te verlengen.

De eerste benchmarks

We kunnen nog geen goede indicatie geven van de prestaties van quadcores in smartphones: de toestellen zijn nog amper aangekondigd, laat staan dat we al benchmarks hebben kunnen draaien.

Het enige wat in de buurt komt zijn de benchmarks van de Transformer Prime: die heeft bijna dezelfde specificaties en dezelfde software als de originele Transformer, maar beschikt over een Tegra 3 in plaats van Tegra 2. Jammer genoeg is de kloksnelheid hoger: 1,4GHz voor de Prime tegen 1GHz voor zijn voorganger. De soc is echter het belangrijkste verschilpunt.

De AnTuTu-benchmark test de rekenkracht en de grafische prestaties, en voert een database-i/o-test uit. Het verschil wordt hier direct duidelijk: de Tegra 3-tablet presteert meer dan twee keer zo goed als de Tegra 2-tablet.

GLBenchmark is een gpu-test en meet daardoor dus niet de processorkernen zelf. De gpu van de Tegra 3 is echter flink verbeterd en dat is duidelijk te zien in de benchmarks.

Invloed op software

BrowserMark meet de snelheid van de browser aan de hand van een aantal tests met animaties. De Prime scoort hier fiks hoger dan de originele Transformer met dezelfde software, en we mogen concluderen dat de quadcore wel degelijke een significante invloed op de prestaties van de browser heeft.

Die invloed zien we minder terug in de in de test waarbij onze frontpage wordt geladen. De scores zijn sowieso niet denderend, maar de Prime is slechts een fractie sneller. De Tweakers.net-frontpage leunt overigens behoorlijk zwaar op Javascript.

Invloed op accu

Op papier is de accucapaciteit zo goed als gelijk: rond 6600mAh. Bij het afspelen van een film heeft de Prime duidelijk baat bij zijn companion core, die alle taken behalve het afspelen van de film op zich neemt: de Prime houdt het veel langer uit dan de Transformer.

In onze browsertest botst de theorie met de praktijk: de Prime gaat juist minder lang mee. Vermoedelijk worden de cores na het laden van de pagina niet meteen uitgeschakeld. Als dit een bug in Android is die bij de release van de eerste quadcoretelefoons niet is opgelost, is dat op zijn minst reden tot zorg. Daar moet wel bij worden gezegd dat de geteste Transformers op Android 3.2 draaien, terwijl de telefoons Android 2.3 of 4.0 aan boord zullen hebben.

Tot slot: afwachten

De eerste smartphones met quadcoreprocessors zullen niet lang meer op zich laten wachten. HTC zal op de telecombeurs Mobile World Congress, die eind deze maand in Barcelona wordt gehouden, vermoedelijk zijn eerste Tegra 3-toestel presenteren. Ook van LG verwachten we op deze beurs enkele toestellen met deze soc. Samsung zal wat later zijn Galaxy S III uitbrengen en ook dat toestel krijgt waarschijnlijk een quadcore aan boord.

Quadcores zijn volgens ons geen overbodige luxe voor de high-end smartphones van de toekomst. Er zit nog genoeg rek in dualcores, maar de extra processorkernen maken meer mogelijk en de opzet met de companion core kan voor de nodige extra accuduur zorgen. Daarnaast maken de nieuwe socs 3d-gaming op hogere resolutie en met meer frames per seconde mogelijk.

De eerste benchmarks met de Tegra 3 wijzen op een behoorlijke verbetering ten opzichte van de huidige generatie dualcores. Vermoedelijk wordt de Tegra 3 voor smartphones wel wat teruggeklokt, maar we rekenen alsnog op fors betere prestaties. Of die verwachtingen worden bewaarheid, zal blijken als de eerste quadcores in de winkel liggen. Dat zal naar alle waarschijnlijkheid al dit voorjaar het geval zijn.

Daar komt bij dat vernieuwende toestellen lang niet altijd goed verkopen. Toestellen als de Toshiba TG01 - de

Daar komt bij dat vernieuwende toestellen lang niet altijd goed verkopen. Toestellen als de Toshiba TG01 - de /i/1235639907.jpeg?f=imagenormal)

/i/1256225012.jpg?f=imagenormal)

/i/1328020478.jpeg?f=imagenormal)

Op het eerste gezicht zou je denken dat een telefoon alleen maar sneller leeg gaat als er nog meer energieverbruikende cores in worden gestopt. Dat is dus te kort door de bocht: quadcore-socs zouden juist minder van de accu vragen.

Op het eerste gezicht zou je denken dat een telefoon alleen maar sneller leeg gaat als er nog meer energieverbruikende cores in worden gestopt. Dat is dus te kort door de bocht: quadcore-socs zouden juist minder van de accu vragen./i/1329116594.png?f=fpa)

/i/1245747816.png?f=fpa)

/i/1310456666.png?f=fpa)