Inleiding

Onlangs besprak Tweakers.net de GTX 460. Deze DirectX 11-kaart bleek een betere prijs-prestatieverhouding te bieden dan de dure GTX 480, terwijl de prestaties ook in absolute zin van een zeer behoorlijk niveau zijn. In deze review bekijken we hoe de kaart zich in sli-opstellingen gedraagt. In theorie is het mogelijk dat twee GTX 460-kaarten de GTX 480 verslaan, terwijl een tweetal GTX 460's vaak goedkoper is. Uiteraard vergelijken we de GTX 460-tandem ook met AMD's topmodellen.

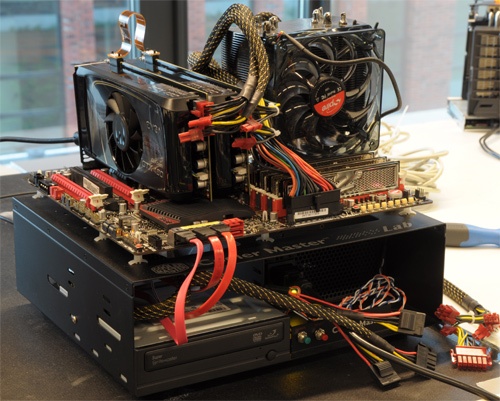

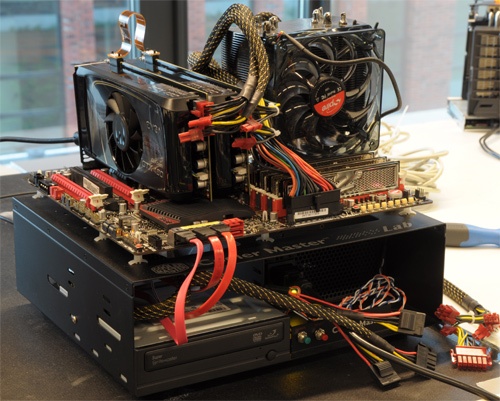

EVGA voorzag Tweakers.net van twee GTX 460 768MB-kaarten, die we in onze tests terug klokten naar 675MHz in plaats van 763MHz. In onze GTX 460-review bleek het 1GB-model van de kaart weinig meerwaarde te bieden, maar met het 1GB-model van Zotac en een referentiekaart van Nvidia met evenveel geheugen bouwden we ook een sli-opstelling. Om de cijfers nog wat beter in perspectief te zetten, hebben we vier van de acht gamebenchmarks ook met de HD 4890 en de GTX 295 uitgevoerd.

Net zoals in de voorgaande review kijken we niet alleen naar de rekencapaciteit, maar ook naar de geluidsproductie en de energieconsumptie van de videokaarten. Tot slot proberen we met twee GTX 460's in sli zo ver mogelijk te overklokken.

De videokaarten

De EVGA-kaarten zijn dezelfde exemplaren als die uit de GTX 460-review. De videokaarten zijn gebouwd aan de hand van Nvidia's referentie-exemplaar, maar werden door EVGA wel van 675MHz naar 763MHz overgeklokt. De fan bevindt zich in het midden van de videokaart en blaast de warme lucht naar twee kanten weg. Deze EVGA's beschikken over twee dvi-poorten en een mini-hdmi-poort. Voor de review werden de gpu's op 675MHz geklokt, om een goede vergelijking met de 1GB-kaarten mogelijk te maken.

/i/1279749517.jpeg?f=imagenormal)

:fill(white)/i/1279749516.jpeg?f=thumb)

:fill(white)/i/1279749518.jpeg?f=thumb)

Ook Zotac's exemplaar werd in de voorgaande review al getest. De videokaart onderscheidt zich met vier video-uitgangen: twee dvi-poorten, een hdmi-poort en een displayport. Daarvoor moest wel een deel van het ventilatierooster aan de achterkant worden opgeofferd, wat de geluidsproductie niet ten goede kwam. Wel blaast de koeler, dankzij zijn positie aan het uiteinde van de kaart, alle warme lucht de behuizing uit. Zotac liet de kloksnelheden van de gpu en het geheugen ongemoeid.

/i/1279749514.jpeg?f=imagenormal)

:fill(white)/i/1279749513.jpeg?f=thumb)

:fill(white)/i/1279749515.jpeg?f=thumb)

Specificaties en prijzen

De GTX 460 is voorzien van de GF104-chip, die op een aantal punten afwijkt van de GF100. Zo heeft de GF104 384 Cuda-cores, al zijn er bij de GTX 460 maar 336 geactiveerd. De gpu wordt door Nvidia op 675MHz geklokt, waardoor de shaderklok automatisch 1350MHz bedraagt.

De GTX 460 is in twee varianten verkrijgbaar, met een 192bit- en een 256bit-geheugenbus, waarmee respectievelijk 768MB en 1024MB gddr5-geheugen wordt aangestuurd. Dat geheugen is standaard op 3600MHz geklokt.

Beide varianten hebben genoeg aan twee zespins pci-e-connectors, maar door het extra geheugen verbruikt de 1GB-variant 160W, terwijl een GTX 460 met 768MB geheugen 10W minder zou verstoken. Om de hitte af te voeren zijn de 21 centimeter lange videokaarten steevast voorzien van een dubbelslots-koeler. Aan de achterkant van het referentie-exemplaar bevinden zich, zoals we van de GTX 4x0-serie gewend zijn, twee dvi-poorten en een mini-hdmi-poort.

| Merk en Productserie |

Zotac |

EVGA |

| Type |

GeForce GTX 460 1GB |

GTX 460 SuperClocked |

| |

:fill(white)/i/1278937480.jpeg?f=thumb) |

:fill(white)/i/1279709433.jpeg?f=thumb) |

| Prijs en waardering |

| Prijs |

€ 229,82 |

€ 204,64 |

| Eerste prijsvermelding |

donderdag 15 juli 2010 |

donderdag 22 juli 2010 |

| Technische Specificaties |

| Videochip |

GeForce GTX 460 |

GeForce GTX 460 |

| Kloksnelheid |

675MHz |

763MHz |

| Shader clock |

1350MHz |

1526MHz |

| Geheugengrootte |

1GB |

768MB |

Geheugentype

|

gddr5 |

gddr5 |

| Geheugensnelheid |

3600MHz |

3800MHz |

| Geheugenbandbreedte |

256bit |

192bit |

| Interfaces |

| Card Interface (Video) |

PCI-e 16x |

PCI-e 16x |

| Video uit |

D-sub, 2x dvi-i, hdmi, mini-hdmi |

2x dvi-i, Mini-hdmi |

| Koeling |

Actieve koeling |

Actieve koeling |

| Adapter |

dvi-naar-D-sub, dvi-naar-hdmi |

dvi-naar-D-sub |

| Ondersteuning |

| Link Interface |

Nvidia sli |

Nvidia sli |

| DirectX |

11 |

11 |

| OpenGL |

4.0 |

4.0 |

| Drm |

hdcp |

hdcp |

| Verkoopstatus |

| Fabrieksgarantie |

2 jaar |

2 jaar |

Testsysteem

Het testsysteem werd opgetrokken rond een Core i7 920-processor, die op 3,8GHz werd geklokt door de bclk tot 180MHz te verhogen. We streven ernaar om altijd de nieuwste drivers te gebruiken, en als er bèta-drivers gebruikt zijn, wordt dat apart vermeld. Bij deze review werden de ATI-kaarten met versie 10.6 van de Catalyst-drivers aangestuurd en de Nvidia-kaarten met versie 257.21 van de Geforce-drivers.

Als benchmarks dienen Call of Duty: Modern Warfare 2, Far Cry 2, Stalker: Call of Prippyat, DiRT 2, Tom Clancy's H.A.W.X, Dawn of War II: Chaos Rising en Battlefield: Bad Company 2. Ook van deze games werden, voor zover beschikbaar, alle patches geïnstalleerd. Waar mogelijk zijn de interne benchmarks van de games gebruikt.

| Testsysteem |

| Moederbord |

Asus Rampage Extreme III

|

| Processor |

Intel Core i7 920 @ 3,8GHz |

| Geheugen |

6GB ddr3: 3x OCZ3X1333LV6GK 8-8-8 |

| Harde schijven |

500GB Samsung Spinpoint F1 HD502IJ |

| Videokaarten |

Zotac GTX 460 1GB

Sapphire HD 5970

Asus GTX 470

EVGA GTX 460 768MB

Asus GTX 480

Asus HD 5830

Gigabyte HD 5850

Asus HD 5870

|

| Koeler |

Thermalright Ultra Extreme 120

|

| Voeding |

Corsair 850HX

|

Intels X58-platform zal naar verwachting nog geruime tijd de prestatiekroon in handen houden. Dit systeem zal bij het uitvoeren van de benchmarks dan ook niet snel een bottleneck zijn.

Elke game is getest op de resoluties 1920x1200 en 2560x1600. De instellingen verschillen per game en zullen daarom telkens vermeld worden. In principe wordt altijd anti-aliasing toegepast, tenzij dit resulteert in onspeelbaar lage framerates. Hetzelfde geldt voor sommige in-game-settings, die naar beneden worden bijgesteld als de videokaart anders onvoldoende fps produceert. Ook wordt er altijd 16xAF toegepast, behalve bij HAWX; bij games die dat niet ondersteunen is deze instelling afgedwongen met behulp van ATI's CCC of Nvidia's Control Panel.

In het Catalyst Control Center staat de adaptive aliasing op multi-sampling, wordt de toepassing van AA/AF waar mogelijk aan de applicatie overgelaten, en is mipmapping op de hoogste kwaliteit ingesteld. In Nvidia's Control Panel staat de anti-aliasing transparancy-modus op multisampling en is de texture quality op high quality ingesteld. Ook hier wordt AA/AF waar mogelijk door de applicatie verzorgd.

Bij alle tests wordt zowel het minimale als het gemiddelde aantal frames per seconde gegeven, waarbij een hogere score uiteraard altijd beter is.

3DMark Vantage & Unigine Heaven 2.0

Vantage is een synthetische benchmark en kan vooral gebruikt worden om videokaarten onderling te vergelijken. We maken alleen gebruik van de gpu-score.

We zien dat de GTX 460's in sli net niet twee keer zoveel punten scoren als een enkele GTX 460, wat een goed teken voor de te verwachten sli-schaling in spellen is. De GTX 480 wordt met gemak verslagen.

De Heaven 2.0-benchmark van Unigine maakt hevig gebruik van tesselation en ook hier schalen de 460-sli-opstellingen dan ook uitstekend: we noteren rond de 90 procent betere resultaten dan bij een enkele GTX 460. Vergeleken met Vantage is het verschil tussen de GTX 460's en de GTX 480 wel wat kleiner.

Far Cry 2 & Dawn of War II

Far Cry 2 is een spel waar sli zeer goed in schaalt en is dan ook een ideale test om te kijken hoe de twee GTX 460's zich verhouden ten opzichte van duurdere Nvidia-kaarten.

| Far Cry 2 - 1920x1200 - Ultra high - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 460 1GB SLI |

******

+

**

95,4 / 118,8 |

| GTX 460 768MB SLI |

******

+

**

90,7 / 115,2 |

| HD 5970 |

*****

+

**

78,6 / 105,1 |

| GTX 480 |

*****

+

*

73,6 / 93,4 |

| GTX 295 |

****

+

**

59,4 / 80,4 |

| GTX 470 |

****

+

*

58,0 / 74,7 |

| HD 5870 |

***

+

*

49,8 / 67,5 |

| GTX 460 1GB |

***

+

*

51,8 / 66,0 |

| GTX 460 768MB |

***

+

*

47,6 / 61,4 |

| HD 5850 |

***

+

*

43,5 / 59,9 |

| Asus HD 5830 |

**

+

*

35,2 / 49,6 |

| HD 4890 |

**

+

*

35,1 / 45,4 |

In Far Cry 2 gebeurt meteen waar we al op hoopten: twee GTX 460's verslaan een GTX 480, en ook nog eens met speels gemak. Ook de HD 5970 wordt opzij gezet, maar dat viel in Far Cry 2 wel te verwachten. Ten opzichte van een GTX 295 met zijn twee gpu's is het tweetal GTX 460's in sli anderhalf keer zo snel.

| Far Cry 2 - 2560x1600 - Ultra high - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 460 1GB SLI |

******

+

**

62,7 / 83,7 |

| HD 5970 |

*****

+

**

52,4 / 73,5 |

| GTX 460 768MB SLI |

**

+

*****

25,3/ 71,6 |

| GTX 480 |

****

+

**

47,6 / 62,8 |

| GTX 295 |

****

+

**

41,1/ 59,6 |

| HD 5870 |

***

+

*

33,7 / 47,8 |

| HD 5850 |

***

+

*

27,1 / 40,0 |

| HD 4890 |

**

+

*

23,0 / 30,9 |

| HD 5830 |

**

+

*

19,4 / 28,6 |

Op 2560x1600 lopen de GTX 460's met 768MB geheugen tegen een limiet aan: het tweetal heeft een tekort aan vram en omdat er textures van het werkgeheugen naar de videokaart geswapped moeten worden, storten de framerates zo nu en dan in. Vooral de minimale scores stellen daardoor zwaar teleur. De twee 1GB-kaarten zetten de GTX 480 op grotere achterstand.

Dawn of War II

| DoW II: Chaos Rising - 1920x1200 - max - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

****

+

****

46,0 / 84,2 |

| GTX 460 1GB SLI |

***

+

*****

33,3 / 82,4 |

| GTX 460 768MB SLI |

***

+

*****

32,0 / 78,9 |

| GTX 295 |

**

+

*****

18,2 / 73,0 |

| GTX 480 |

**

+

*****

23,0 / 71,9 |

| GTX 460 768MB |

**

+

****

20,0 / 64,2 |

| GTX 460 1GB |

**

+

****

19,3 / 62,9 |

| HD 5870 |

**

+

****

19,3 / 59,3 |

| GTX 470 |

**

+

****

17,0 / 56,0 |

| HD 5850 |

**

+

****

18,0 / 54,2 |

| GTX 465 |

*

+

***

12,8 / 46,7 |

| HD 5830 |

*

+

***

11,0 / 40,0 |

| HD 4890 |

*

+

**

12,0 / 33,2 |

In Dawn of War schalen de GTX 460's in sli niet erg goed: twee kaarten produceren maar anderhalf keer zo veel frames als een enkel exemplaar. Desondanks weten ze de GTX 480 te deklasseren.

| DoW II: Chaos Rising - 2560x1600 - max - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

***

+

*****

32,3 / 80,5 |

| GTX 460 1GB SLI |

**

+

*****

22,8 / 72,4 |

| GTX 460 768MB SLI |

**

+

*****

22,0 / 71,7 |

| GTX 480 |

**

+

****

16,8 / 55,3 |

| GTX 295 |

*

+

****

11,3 / 49,5 |

| HD 5870 |

*

+

***

11,7 / 41,2 |

Ook op 2560x1600 zijn de GTX 460's de GTX 480 te snel af en zijn ze maar liefst twee keer zo snel als de HD 5870. De minima zijn echter eigenlijk te laag om soepel te gamen. De HD 5970 gaat er bij deze game duidelijk met de hoofdprijs vandoor.

DiRT 2 & CoD: MW2

De engine van het racespel DiRT 2 gebruikt enkele DirectX 11-features, waaronder tesselation. We maakten gebruik van de ingebouwde benchmark, waarbij met een achttal auto's over het London-circuit wordt gescheurd.

| DiRT 2 - 1920x1200 - DX11 - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

*******

+

*

78,6 / 92,2 |

| GTX 460 1GB SLI |

******

+

**

72,3 / 90,0 |

| GTX 460 768MB SLI |

******

+

**

67,4 / 84,6 |

| GTX 480 |

*****

+

*

56,5 / 69,4 |

| HD 5870 |

*****

+

*

53,1 / 64,8 |

| HD 5850 |

****

+

*

51,7 / 60,8 |

| GTX 460 1GB |

***

+

*

38,1 / 48,5 |

| HD 5830 |

***

+

*

37,3 / 45,3 |

| GTX 460 768MB |

***

+

*

35,0 / 44,8 |

| HD 5770 |

**

+

*

29,4 / 36,7 |

Ook in DiRT 2 maken twee GTX 460's gehakt van de GTX 480, ongeacht de hoeveelheid geheugen. Alleen in de HD 5970 moeten ze hun meerdere erkennen. De 1GB-kaarten weten wel significant meer fps uit te spugen dan de 768MB-modellen; de schaling is in beide gevallen weer uitstekend.

| DiRT 2 - 2560x1600 - DX11 - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

*******

+

*

59,0 / 67,3 |

| GTX 460 1GB SLI |

******

+

**

48,9 / 63,6 |

| HD 5870 |

*****

+

*

38,8 / 47,3 |

| GTX 480 |

****

+

*

35,5 / 46,7 |

| GTX 460 768MB SLI |

**

+

***

20,3 / 46,4 |

| HD 5830 |

**

+

*

21,6 / 29,7 |

| HD 5770 |

**

+

*

18,7 / 23,0 |

Net als bij Dawn of War laten de GTX 460's met 768MB geheugen het hier op de hoogste resolutie afweten. Een minimumframerate van 20fps maakt DiRT domweg onspeelbaar. De 1GB-kaarten hebben hier wederom geen last van en zijn ruimschoots sneller dan de GTX 480.

Call of Duty: Modern Warfare 2

CoD: MW2 is op lagere resoluties niet echt een uitdaging voor de meeste videokaarten, maar op 1920x1200 en met name op 2560x1600 moeten twee GTX 460's alsnog aan de bak.

| Call of Duty: Modern Warfare 2 - 1920x1200 - Max - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

******

+

**

94,3/ 128,9 |

| GTX 295 |

*****

+

***

78,5 / 116,4 |

| GTX 460 1GB SLI |

****

+

***

68,3 / 107,3 |

| GTX 460 768MB SLI |

****

+

***

67,5 / 106,9 |

| GTX 480 |

****

+

**

61,0 / 98,6 |

| HD 5870 |

***

+

**

55,8 / 83,4 |

| HD 5850 |

***

+

**

47,5 / 75,3 |

| GTX 460 768MB |

***

+

**

42,8 / 71,6 |

| GTX 460 1GB |

***

+

**

43,3 / 71,0 |

| GTX 470 |

***

+

*

52,0 / 70,1 |

| GTX 465 |

**

+

**

40,3 / 65,1 |

| HD 5830 |

**

+

**

37,6 / 63,8 |

| HD 4890 |

**

+

**

35,3 / 61,6 |

| HD 5770 |

**

+

**

34,5 / 56,7 |

De tweekoppige GTX 295 is een tweetal GTX 460's hier te snel af. Het verschil tussen de GTX 460's en de GTX 480 is ook 'slechts' tien procent. De kaarten schalen redelijk, maar niet zo goed als in DiRT 2 en Far Cry 2.

| Call of Duty: Modern Warfare 2 - 2560x1600 - Max - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

*****

+

***

68,0 / 100,8 |

| GTX 295 |

*****

+

**

58,6 / 85,3 |

| GTX 460 1GB SLI |

****

+

***

45,5 / 79,7 |

| GTX 460 768MB SLI |

****

+

**

48,5 / 76,8 |

| GTX 480 |

***

+

**

39,0 / 63,8 |

| HD 5870 |

***

+

**

34,8 / 60,7 |

| HD 5850 |

**

+

**

30,6 / 54,5 |

| HD 5830 |

**

+

**

24,0 / 44,4 |

| HD 4890 |

**

+

**

22,3 / 41,8 |

| HD 5770 |

**

+

**

22,0 / 39,4 |

Op 2560x1600 wordt het gat tussen de GTX 460's en de GTX 480 onverwacht iets groter, in plaats van kleiner. De achterstand op de GTX 295 wordt juist groter.

Bad Company 2 & H.A.W.X.

Battlefield: Bad Company 2 is gebaseerd op de Frostbite-engine, die subtiel van enkele DirectX 11-functies gebruikmaakt.

| Bad Company 2 - 1920x1200 - max - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

******

+

**

61,1 / 83,2 |

| GTX 460 768MB SLI |

*****

+

**

53,8 / 69,8 |

| GTX 460 1GB SLI |

*****

+

**

54,5 / 69,1 |

| GTX 480 |

*****

+

*

48,3 / 59,2 |

| GTX 295 |

***

+

**

35,8 / 52,7 |

| HD 5870 |

***

+

**

37,0 / 52,1 |

| GTX 470 |

****

+

*

38,3 / 48,1 |

| HD 5850 |

***

+

*

33,2 / 45,8 |

| GTX 460 768MB |

***

+

*

33,0 / 40,8 |

| GTX 460 1GB |

***

+

*

31,0 / 40,1 |

| HD 5830 |

**

+

*

24,9 / 34,2 |

| HD 5770 |

**

+

*

20,4 / 30,4 |

Terwijl een enkele GTX 460 op 1920x1200 nog maar net speelbare framerates weet te produceren, laten twee exemplaren in sli de GTX 480 met zeer speelbare framerates achter zich. De schaling ligt rond de 75 procent en dat is wederom goed te noemen.

| Bad Company 2 - 2560x1600 - max - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

*****

+

***

38,1 / 57,5 |

| GTX 460 1GB SLI |

****

+

**

32,3 / 46,1 |

| GTX 460 768MB SLI |

****

+

**

29,0 / 43,8 |

| GTX 480 |

****

+

*

29,7 / 38,2 |

| HD 5870 |

***

+

**

25,3 / 36,3 |

| GTX 295 |

***

+

**

22,2 / 35,4 |

| HD 5850 |

***

+

**

19,5 / 29,7 |

Ook op 2560x1600 zijn de GTX 460-duo's de GTX 480 nog wel te snel af, maar de verschillen zijn niet groot. Het extra geheugen van de 1GB-kaarten helpt iets, maar in elk geval storten de 768MB-kaarten niet volledig in.

Tom Clancy's H.A.W.X.

HAWX is een vliegspel, dat gebruik maakt van DirectX 10.1-features. Alle geteste kaarten, behalve de GTX 295, ondersteunen dit.

| HAWX - 1920x1200 - Maximum - 4xAA/0xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

******

+

**

101,7 / 138,4 |

| GTX 460 1GB SLI |

******

+

**

105,3 / 135,4 |

| GTX 460 768MB SLI |

******

+

**

101,0 / 131,2 |

| GTX 480 |

****

+

**

78,8 / 106,4 |

| GTX 470 |

*****

+

*

80,3 / 100,2 |

| GTX 295 |

****

+

*

70,6 / 93,6 |

| HD 5870 |

****

+

**

63,5 / 91,0 |

| HD 5850 |

***

+

*

55,4 / 76,6 |

| GTX 460 1GB |

***

+

*

51,5 / 70,3 |

| GTX 460 768MB |

***

+

*

51,1 / 70,1 |

| HD 4890 |

***

+

*

48,6 / 64,1 |

| HD 5830 |

**

+

*

40,0 / 58,9 |

| HD 5770 |

**

+

*

31,5 / 46,3 |

Moderne high-end videokaarten hebben geen kind aan HAWX, maar het spel is wel een goede showcase voor sli-schaling: onze sli-opstellingen halen rond de 90 procent winst. De GTX 480 krijgt - het wordt saai - weer stevig klop.

| HAWX - 2560x1600 - Maximum - 4xAA/0xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

******

+

**

74,6 / 96,1 |

| GTX 460 1GB SLI |

******

+

**

68,2 / 93,7 |

| GTX 460 768MB SLI |

*****

+

**

62,0 / 87,5 |

| GTX 480 |

****

+

**

55,0 / 72,2 |

| HD 5870 |

****

+

**

48,2 / 71,8 |

| GTX 295 |

****

+

**

48,2 / 64,9 |

| HD 5850 |

***

+

**

35,3 / 56,3 |

| HD 4890 |

**

+

*

28,2 / 42,8 |

| HD 5830 |

**

+

*

25,0 / 38,0 |

| HD 5770 |

**

+

*

19,8 / 28,6 |

Op 2560x1600 weten de 1GB-kaarten iets afstand te nemen van de 768MB-kaarten en het verschil met de GTX 480 blijft goeddeels gehandhaafd. Wel is de gemiddelde framerate van de HD 5970, net als bij de 1920x1200-test, nog een paar procent beter.

Stalker: Call of Pripyat & Alien vs Predator

Bij Stalker: Call of Pripyat gebruiken we alleen de resultaten van de Sunray-benchmark, omdat dit het zwaarste onderdeel is. De preset staat op Extreme terwijl alle DX11-functies zijn ingeschakeld.

| Stalker: CoP - 1920x1200 - DX11 - max - 0xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

*****

+

***

37,4 / 57,4 |

| GTX 460 1GB SLI |

****

+

***

27,5 / 46,0 |

| GTX 460 768MB SLI |

****

+

***

26,5 / 45,0 |

| GTX 480 |

****

+

**

30,0 / 43,0 |

| GTX 470 |

***

+

**

24,0 / 34,0 |

| HD 5870 |

****

+

*

26,7 / 33,5 |

| HD 5850 |

***

+

*

22,3 / 30,5 |

| GTX 460 1GB |

***

+

*

21,0 / 27,0 |

| GTX 460 768MB |

***

+

*

19,0 / 26,0 |

| HD 5830 |

***

+

*

18,9 / 25,6 |

| HD 5770 |

**

+

*

15,3 / 20,2 |

Op 1920x1200 lijken de GTX 460's in sli onder de maat te presteren. De GTX 480 wordt nipt verslagen, maar alleen bij de gemiddelde framerate: de minima van de sli-opstellingen zijn slechter. De schaling ten opzichte van een enkele GTX 460 is ronduit beroerd.

| Stalker: CoP - 2560x1600 - DX11 - max - 0xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

******

+

***

25,5 / 36,4 |

| GTX 480 |

****

+

**

18,0 / 26,0 |

| GTX 460 1GB SLI |

****

+

**

18,2 / 24,9 |

| GTX 460 768MB SLI |

***

+

**

15,5 / 23,3 |

| HD 5870 |

****

+

*

18,0 / 22,5 |

| HD 5850 |

***

+

*

14,9 / 18,2 |

Hoewel deze benchmark op 2560x1600 voor elke videokaart een enorme kluif is, maken de GTX 460's hier erg weinig klaar. Ook de GTX 480 en de HD 5970 maken echter geen indruk.

Alien vs. Predator

Alien vs. Predator is een vrij recente toevoeging aan onze benchmarksuite. Bij de vorige review moesten we constateren dat de framerates van ATI-kaarten met ruim de helft afnemen als Anisotropic Filtering in ATI CCC wordt afgedwongen. De benchmark gebruikt zelf echter ook AF en vreemd genoeg zorgt dat niet voor problemen.

| Alien vs Predator - 1920x1200 - High - 0xAA |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

*****

+

***

49,5 / 79,3 |

| GTX 460 1GB SLI |

***

+

***

34,0 / 58,8 |

| GTX 460 768MB SLI |

***

+

***

33,0 / 56,7 |

| HD 5870 |

***

+

**

30,5 / 49,8 |

| GTX 480 |

***

+

**

28,0 / 45,7 |

| GTX 470 |

**

+

**

22,0 / 36,4 |

| GTX 460 1GB |

**

+

*

18,0 / 31,4 |

| GTX 460 768MB |

**

+

*

17,0 / 29,8 |

Ook in AvP zien we dat de GTX 460's in sli uitstekend schalen. Vermoedelijk ligt dat weer aan de rol die tesselation in deze benchmark speelt: bij Nvidia zijn de Cuda-cores grotendeels verantwoordelijk voor deze feature. Met dezelfde hoeveelheid tesselation en het dubbele aantal Cuda-cores heeft een sli-opstelling dus meer Cuda-cores beschikbaar voor andere taken. Toch valt het op dat ook ATI's HD 5870 het in deze test goed doet.

| Alien vs Predator - 2560x1600 - High - 0xAA |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

*****

+

***

29,0 / 49,1 |

| GTX 460 1GB SLI |

***

+

***

20,3 / 36,9 |

| GTX 460 768MB SLI |

***

+

***

19,2 / 35,2 |

| HD 5870 |

***

+

**

17,7 / 31,0 |

| GTX 480 |

***

+

**

16,0 / 27,7 |

Op de 4-megapixelresolutie presteren de GTX 460-tandems naar behoren; de verhoudingen blijven ongeveer gelijk. We moeten echter wel vaststellen dat geen enkele videokaart tegen deze benchmark is opgewassen, ook de HD 5970 niet.

Energieverbruik

De GTX 460's, met hun GF104-chip, lieten in de vorige review al zien dat ze een stuk minder energie verstoken dan videokaarten op basis van de GF100. Nu is het de vraag wat er gebeurt na de toevoeging van een extra videokaart. AMD wist het al voor elkaar te krijgen om een tweede gpu in de idle-modus bijna volledig uit te schakelen, waardoor het energieverbruik met meer gpu's in CrossFireX amper stijgt.

| Vermogensopname systeem - Idle |

| | Watt (minder is beter) |

| HD 5970 |

**********

145 |

| GTX 460 768MB SLI |

**********

144 |

| GTX 460 1GB SLI |

**********

143 |

| GTX 480 |

**********

140 |

| HD 5870 |

*********

134 |

| GTX 470 |

*********

134 |

| HD 5850 |

*********

130 |

| GTX 460 768M |

*********

128 |

| GTX 460 1GB |

*********

127 |

Nvidia lijkt hetzelfde voor elkaar te hebben gekregen: de tweede gpu zorgt bij een onbelast systeem voor een verbruikstoename van slechts 15W. Daarbij moet worden aangetekend dat de kloksnelheid van Nvidia-gpu's meteen wordt verhoogd zodra er een applicatie zoals GPU-Z wordt gestart, en vervolgens duurt het wel even voordat de cores weer omlaag worden geklokt. ATI-kaarten hebben hier veel minder last van.

| Vermogensopname systeem - Load |

| | Watt (minder is beter) |

| GTX 460 1GB SLI |

**********

493 |

| GTX 480 |

**********

470 |

| HD 5970 |

*********

450 |

| GTX 460 768MB SLI |

*********

450 |

| GTX 470 |

*******

368 |

| HD 5870 |

*******

359 |

| HD 5850 |

*******

321 |

| GTX 460 1GB |

******

309 |

| GTX 460 768M |

******

277 |

Wanneer de videokaarten met Furmark voluit belast worden, zien we dat de 1GB-sli-opstelling ruim 20W meer verbruikt dan een GTX 480. De twee GF104's zijn met 675MHz weliswaar 25MHz lager geklokt dan de ene GTX 480, maar bevatten samen ook 192 extra Cuda-cores en een halve gigabyte extra geheugen.

De 768-modellen van EVGA trekken samen een goede 40W minder uit de voeding dan de 1GB-modellen. De kaarten beschikken samen weliswaar over 512MB minder geheugen, maar volgens Nvidia verbruiken de 1GB-modellen slechts 10W meer, en geen 20W zoals hier gemeten wordt.

Al met al bewijst Nvidia hier weer dat het de balans tussen stroomverbruik en prestaties veel beter getroffen heeft dan bij de GTX 480, maar bijna 500W voor een draaiend systeem blijft natuurlijk wel veel.

Geluidsproductie

Naast het energieverbruik werd ook de geluidsproductie gemeten, op een afstand van 20 centimeter. In een behuizing zal het geluid natuurlijk altijd anders uitvallen.

| Geluidsproductie systeem - Idle |

| | Geluidsproductie (dBA) |

| GTX 460 1GB SLI |

**********

48,2 |

| GTX 480 |

*********

45,4 |

| GTX 460 768MB SLI |

*********

44,9 |

| GTX 470 |

*********

44,1 |

| GTX 460 768M |

*********

43,7 |

| GTX 460 1GB |

*********

42,6 |

| HD 5850 |

*********

42,6 |

| HD 5870 |

*********

42,4 |

| HD 5970 |

*********

41,3 |

De GTX 460 1GB-combinatie is verreweg het meest luidruchtige stel videokaarten, maar dat komt deels door het Zotac-exemplaar, die in onze vorige test als de luidruchtigste GTX 460 uit de bus kwam. De twee EVGA-exemplaren zijn daarentegen redelijk stil en zullen in een goede behuizing maar weinig geluid voortbrengen.

| Geluidsproductie systeem - Load |

| | Geluidsproductie (dBA) |

| HD 5970 |

**********

62,4 |

| GTX 480 |

**********

61,8 |

| GTX 460 1GB SLI |

*********

56,0 |

| GTX 470 |

*********

55,6 |

| HD 5870 |

*********

53,1 |

| HD 5850 |

********

51,9 |

| GTX 460 768MB SLI |

********

50,3 |

| GTX 460 1GB |

*******

45,6 |

| GTX 460 768M |

*******

44,2 |

Onder load is de geluidsproductie van de twee 1GB-exemplaren nog acceptabel, terwijl de twee 768MB-kaarten zeker voor een sli-opstelling erg stil zijn. Zowel de Nvidia- als de ATI-kaarten maken in enkelvoud al meer herrie. Wederom moeten we opmerken dat de geluidsproductie van het 2x1GB-setje lager zou uitvallen als de Zotac-kaart door een exemplaar van de concurrentie wordt vervangen.

Overklokken (1)

In de GTX 460-review werd al geconstateerd dat de GTX 460's zich goed lenen voor een flinke overklok. We probeerden de videokaarten wederom over te klokken, maar in sli-modus is het wel zo dat de langzaamste videokaart de zwakste schakel is, omdat beide videokaarten op dezelfde kloksnelheid moeten lopen. Met behulp van Furmark werd bepaald of een overklok stabiel was of niet.

Behalve op de hoogst haalbare snelheid klokten we de kaarten ook op 763MHz. Dat is de snelheid waarop de EVGA SuperClocked-kaarten uit de fabriek rollen en deze kloksnelheid is praktisch voor elke GTX 460 haalbaar.

| | EVGA x2 | Nvidia / Zotac |

| Stock |

675MHz / 763MHz |

675MHz |

| Overklok |

850MHz |

840MHz |

| Winst |

26% / 11%

|

24% |

| Alien vs Predator - 1920x1200 - High - 0xAA |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

*****

+

***

49,5 / 79,3 |

| GTX 460 1GB SLI @840MHz |

****

+

***

40,3 / 70,0 |

| GTX 460 768MB SLI @850MHz |

****

+

***

37,3 / 65,8 |

| GTX 460 1GB SLI @763MHz |

****

+

***

36,7 / 64,3 |

| GTX 460 768MB SLI @763MHz |

***

+

***

35,0 / 61,4 |

| GTX 460 1GB SLI |

***

+

***

34,0 / 58,8 |

| GTX 460 768MB SLI |

***

+

***

33,0 / 56,7 |

| HD 5870 |

***

+

**

30,5 / 49,8 |

| GTX 480 |

***

+

**

28,0 / 45,7 |

Met de GTX 460 768MB-kaarten valt de prestatiewinst in AvP enigszins tegen. Tussen 675MHz en 850MHz nemen de minima en de gemiddelden respectievelijk met 13 procent en 16 procent toe, terwijl de kloksnelheid met 26 procent stijgt. Bij de 1GB-kaarten op 840MHz stijgen de minimale en gemiddelde framerates met respectievelijk 18,5 procent en 19 procent, wat bij een overklok van 24 procent zeker acceptabel is.

| DiRT 2 - 1920x1200 - DX11 - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 460 1GB SLI 840MHz |

******

+

**

79,2 / 97,6 |

| GTX 460 768MB SLI 850MHz |

******

+

**

74,1 / 92,5 |

| GTX 460 1GB SLI 763MHz |

******

+

*

76,6 / 92,2 |

| HD 5970 |

******

+

*

78,6 / 92,2 |

| GTX 460 1GB SLI |

******

+

**

72,3 / 90,0 |

| GTX 460 768MB SLI 763MHz |

******

+

**

71,4 / 88,6 |

| GTX 460 768MB SLI |

*****

+

**

67,4 / 84,6 |

| GTX 480 |

*****

+

*

56,5 / 69,4 |

| HD 5870 |

****

+

*

53,1 / 64,8 |

In DiRT 2 zien we wat wisselende resultaten, wat met name komt door het gebrek aan geheugen bij de 768MB-kaarten. Het overklokken levert een prestatiewinst van iets meer dan 10 procent op, en dat is relatief weinig in vergelijking met AvP.

Overklokken (2)

Ook de spellen Far Cry 2 en Stalker: Call of Pripyat zijn met de overgeklokte videokaarten getest.

| Far Cry 2 - 1920x1200 - Ultra high - 4xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| GTX 460 1GB SLI 840MHz |

******

+

**

111,2 / 140,6 |

| GTX 460 768MB SLI 850MHz |

******

+

**

100,7 / 129,5 |

| GTX 460 1GB SLI 763MHz |

******

+

**

98,8 / 123,7 |

| GTX 460 768MB SLI 763MHz |

*****

+

**

96,6 / 123,6 |

| GTX 460 1GB SLI |

*****

+

*

95,4 / 118,8 |

| GTX 460 768MB SLI |

*****

+

**

90,7 / 115,2 |

| HD 5970 |

****

+

**

78,6 / 105,1 |

| GTX 480 |

****

+

*

73,4 / 93,4 |

| HD 5870 |

***

+

*

49,8 / 67,5 |

In Far Cry 2 zien we dat de overklok naar 763MHz weinig effect sorteert. De overklok naar 850MHz met de GTX 460 768MB-kaarten levert iets meer dan 10 procent winst op. Bij de 1GB-kaarten op 840MHz gaat het minimum met 17 procent omhoog en stijgt de gemiddelde framerate met 22 procent.

| Stalker: CoP - 1920x1200 - DX11 - max - 0xAA/16xAF |

| GPU | Minimum » Gemiddelde Score (fps) |

| HD 5970 |

*****

+

***

37,4 / 57,4 |

| GTX 460 1GB SLI 840MHz |

*****

+

***

33,5 / 54,0 |

| GTX 460 768MB SLI 850MHz |

****

+

***

30,0 / 53,0 |

| GTX 460 768MB SLI 763MHz |

****

+

***

29,0 / 49,5 |

| GTX 460 1GB SLI 763MHz |

****

+

**

29,5 / 46,0 |

| GTX 460 1GB SLI |

****

+

***

27,5 / 46,0 |

| GTX 460 768MB SLI |

****

+

***

26,5 / 45,0 |

| GTX 480 |

****

+

**

30,0 / 43,0 |

| HD 5870 |

****

+

*

26,7 / 33,5 |

Bij Stalker: CoP zien we hetzelfde als bij Far Cry 2: de overklok naar 763MHz levert weinig op, met prestatiewinsten van hooguit 10 procent. De overklok naar 840MHz daarentegen geeft de 1GB-kaarten een boost van 22 procent voor de minimale framerate en 17 procent voor het gemiddelde.

Het mag duidelijk zijn dat overklokken altijd winst met zich meebrengt, maar dat het van het spel afhangt hoe groot die winst is.

Overklokken (3)

Het verhogen van de kloksnelheden is natuurlijk niet zonder gevolgen. De transistors moeten vaker schakelen en dus neemt ook het energieverbruik toe. De koelers moeten daarom harder werken om de extra hitte af te voeren. We keken dus nogmaals naar het energieverbruik en geluidsproductie van de videokaarten, die ditmaal maximaal waren overgeklokt.

| Vermogensopname systeem - Load |

| | Watt (minder is beter) |

| GTX 460 1GB SLI - 840MHz |

**********

567 |

| GTX 460 1GB SLI |

*********

493 |

| GTX 460 768MB SLI - 850MHz |

********

478 |

| GTX 480 |

********

470 |

| HD 5970 |

********

450 |

| GTX 460 768MB SLI |

********

450 |

| HD 5870 |

******

359 |

We zien dat het extra energieverbruik van de GTX 460's 768MB binnen de perken blijft met een toename van slechts 28W. Bij de 1GB-kaarten valt daarentegen een toename in het energieverbruik te noteren van 74W.

Het is dan ook niet vreemd dat de kaart die effectief door de andere wordt afgedekt in onze opstelling een temperatuur van 100 graden Celsius bereikte. Deze kaart paste daarop automatisch zijn kloksnelheid aan om oververhitting te voorkomen. Goede airflow is dus een must. Met een extra 120mm-fan nam de temperatuur af naar 89 graden Celsius, en die waarde bleef stabiel.

| Geluidsproductie systeem - Load |

| | Geluidsproductie (dBA) |

| HD 5970 |

**********

62,4 |

| GTX 480 |

**********

61,8 |

| GTX 460 1GB SLI - 840MHz |

*********

57,4 |

| GTX 460 1GB SLI |

*********

56,0 |

| HD 5870 |

*********

53,1 |

| GTX 460 768MB SLI - 850MHz |

********

51,6 |

| GTX 460 768MB SLI |

********

50,3 |

De toename van de geluidsproductie bleek in beide gevallen minder dan anderhalve decibel te bedragen. Zelfs als onze sli-setjes stevig worden overgeklokt, zijn ze stiller dan de GTX 480 en de HD 5970.

Conclusie

Twee GTX 460's in sli blijken erg snel te zijn - zo snel zelfs, dat een GTX 480 met grote regelmaat billenkoek krijgt. Alleen bij Stalker: Call of Pripyat bleef in onze test de meerwaarde van de tweede 460 achter bij de verwachtingen. Het energieverbruik bleef relatief gezien binnen de perken, evenals de geluidsproductie, mits de juiste kaarten aangeschaft worden.

Opvallend genoeg was de meerwaarde van de 1GB-kaarten in onze vorige test maar klein, maar omdat er nu ook op de resolutie van 2560x1600 beeldpunten werd getest, wat bijna twee keer zoveel pixels oplevert als 1920x1200, zien we dat het extra geheugen ten opzichte van de 768MB-kaarten zeker wel van nut kan zijn.

Er zitten echter ook nadelen aan een sli-opstelling verbonden. Zo moet je natuurlijk over een moederbord met sli-ondersteuning en een voeding met vier zespins pci-e-connectors beschikken. Tevens zullen er spellen zijn, zoals Stalker: Call of Pripyat, waar sli niet goed uit de verf komt. Ook nieuwe spellen hebben soms last van slechte sli-schaling, maar Nvidia brengt over het algemeen snel updates uit die daar verandering in brengen.

De tweaker die momenteel over aanschaf van een GTX 480 twijfelt, raden we beslist aan om de voor- en nadelen van een systeem met twee GTX 460's te onderzoeken. Dat kan namelijk heel lonend zijn, maar bedenk wel goed of je voor de 768MB- of 1GB-variant gaat.

/i/1279749517.jpeg?f=imagenormal)

:fill(white)/i/1279749516.jpeg?f=thumb)

:fill(white)/i/1279749518.jpeg?f=thumb)

/i/1279749514.jpeg?f=imagenormal)

:fill(white)/i/1279749513.jpeg?f=thumb)

:fill(white)/i/1279749515.jpeg?f=thumb)

:fill(white)/i/1278937480.jpeg?f=thumb)

:fill(white)/i/1279709433.jpeg?f=thumb)

:fill(white):strip_exif()/i/1279709433.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1278937480.jpeg?f=thumbmedium)

:strip_icc():strip_exif()/i/1284042160.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/1279749167.jpeg?f=fpa_thumb)

/i/1262682951.png?f=fpa)

/i/1278936534.png?f=fpa)

/i/1278924491.png?f=fpa)