Janne, een Zweed die werkt voor Svensk Film Effekt, heeft een 30 euro kostende Ikea-kast gebruikt als behuizing voor een krachtige Linux-cluster. Hij gebruikt de goedkope en energiezuinige cluster als een renderfarm.

Janne zocht veel rekenkracht om 3d-animaties sneller te laten renderen. Die paardenkrachten zou moeten komen uit een Linux-cluster. De opdracht die Janne zichzelf gaf: bouw een krachtige, maar ook goedkope en energiezuinige Linux-cluster.

Het vinden van de benodigde hardware bleek vrij eenvoudig. De Zweed wist de hand te leggen op een zestal Intel Core 2 Quad Q6600-cpu's die op 2,4GHz worden geklokt. Een goedkoop moederbord dat de quadcores kon huisvesten bleek de GA-G33M-DS2R van Gigabyte te zijn. Verder kocht de Zweed 24 ddr2-geheugenrepen van 2GB per stuk.

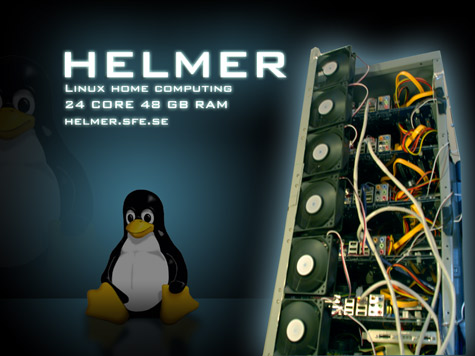

Het vinden van de juiste behuizing bleek echter minder eenvoudig. Specialistische systeemkasten vielen buiten het beschikbare budget. De redding werd uiteindelijk gevonden in een Zweeds massaproduct: de Helmer-ladenkast van Ikea. De zes atx-moederborden bleken met enig zaagwerk en een stukje plexiglas als ondergrond prima in de 30 euro kostende Helmer te passen. Door de voedingen verspringend boven elkaar te monteren, werd bovendien de benodigde luchtstroom voor het koelen van de cpu's gecreëerd.

Om de cluster tot leven te wekken, maakte Janne gebruik van de opensourcetool DrQueue. Deze software draait op een energiezuinige pc, voorzien van een 1,5GHz VIA C7-cpu, die de te berekenen data via een 8-poorts gigabit-switch naar de cluster stuurt. De gerenderde graphics die door de cluster worden teruggestuurd, worden weggeschreven op een nas-systeem met twee harddisks.

Volgens Janne kunnen de 24 cores een rekencapaciteit van ongeveer 186 gigaflops behalen. Daarmee duren renderklussen die voorheen een hele nacht in beslag namen, nog maar tien minuten. De gehele Linux-cluster zou in bedrijf niet meer dan 600W aan stroom verstoken, terwijl in idlestand ongeveer 400W wordt verbruikt.

Nu de cluster in bedrijf is, heeft Janne zijn zinnen gezet op de bouw van een nog krachtiger rekenmonster: de Helmer II. Weliswaar heeft de tweaker het geld niet om het systeem te bouwen, maar het verlanglijstje van de Zweed is helder. Hij wil zes moederborden elk beplanten met één quadcore-cpu en vier exemplaren van ofwel de Radeon HD4870X2 ofwel de Nvidia 9800GX2. In totaal levert dat 48 gpu's op. Met de opkomst van gpgpu-computing en 3d-rendersoftware die de parallele rekenkracht kan benutten, kan met bovenstaande hardware in theorie 40 tot 50 teraflops behaald worden. Janne heeft inmiddels ook een aantal 3d-tekeningen gemaakt die tonen hoe de Helmer II-behuizing eruit zou moeten zien. De bedelactie van de Zweed lijkt al enig succes te hebben gehad: AMD heeft aangeboden om de handige knutselaar van een nog onbekende hoeveelheid hardware te voorzien.

/i/1334660199.png?f=fpa)

/i/1260721357.png?f=fpa)

/i/1231688942.png?f=fpa)

/i/1208164214.png?f=fpa)