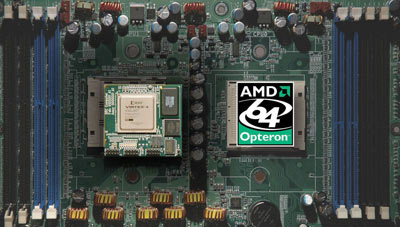

Het kleine Amerikaanse DRC Computers heeft een FPGA-module ontwikkeld die in een Socket 940-voetje past en die probleemloos van AMD's Hyper Transport-bus gebruik kan maken. Daarmee is het relatief eenvoudig geworden om de Opteron uit te breiden met een specialistische co-processor, zonder dat daar speciaal micro-electronica voor ontworpen en gebakken hoeft te worden. De FPGA of Field-programmable gate array bestaat uit een grid van componenten, en door softwarematig verbindingen tussen die componenten te maken of te verbreken, wordt de functionaliteit van de chip geprogrammeerd. Hoewel dergelijke programmeerbare 'accelerators' al geruime tijd gemeengoed zijn, is het voor het eerst dat een FPGA kant-en-klaar voor interactie met een mainstreamchip wordt geleverd.

Het grote voordeel van de nieuwe aanpak is de lage prijs: de DRC-ic's zijn leverbaar vanaf 4500 dollar, terwijl concurrerende programmeerbare co-processors makkelijk 15.000 dollar kosten. De concurrentie heeft meestal ook nog eens extra propriëtaire soft- en hardware nodig, waar een DRC-chip op elk moederbord dat met twee of meer Socket 940-voetjes is uitgerust, naast een Opteron kan worden geprikt. Het overbodig maken van de extra hard- en software van de FPGA-fabrikanten zorgt er bovendien voor dat de afhankelijkheid van de FPGA-producent flink afneemt. Naast de hoge kosten wordt die afhankelijkheid als een van de belangrijkste nadelen van FPGA-oplossingen gezien, reden waarom de klanten veelal de voorkeur geven aan het inzetten van meer generieke hardware. 'De gangbare accelators leveren veel te weinig extra's voor het geld wat ze kosten, dus de klant koopt liever wat extra standaardhardware. Wij proberen die hardware met een factor drie op prijsprestatieverhouding te verslaan', aldus Larry Laurich van DRC.

Het grote voordeel van de nieuwe aanpak is de lage prijs: de DRC-ic's zijn leverbaar vanaf 4500 dollar, terwijl concurrerende programmeerbare co-processors makkelijk 15.000 dollar kosten. De concurrentie heeft meestal ook nog eens extra propriëtaire soft- en hardware nodig, waar een DRC-chip op elk moederbord dat met twee of meer Socket 940-voetjes is uitgerust, naast een Opteron kan worden geprikt. Het overbodig maken van de extra hard- en software van de FPGA-fabrikanten zorgt er bovendien voor dat de afhankelijkheid van de FPGA-producent flink afneemt. Naast de hoge kosten wordt die afhankelijkheid als een van de belangrijkste nadelen van FPGA-oplossingen gezien, reden waarom de klanten veelal de voorkeur geven aan het inzetten van meer generieke hardware. 'De gangbare accelators leveren veel te weinig extra's voor het geld wat ze kosten, dus de klant koopt liever wat extra standaardhardware. Wij proberen die hardware met een factor drie op prijsprestatieverhouding te verslaan', aldus Larry Laurich van DRC.

De goedkoopste chip van DRC biedt een 8bits brede 200MHz HT-aansluiting; de twee andere modellen hebben een 400MHz 16bits interface. De co-processors hebben tussen de vijftig- en honderdveertigduizend programmeerbare componenten aan boord, en kunnen per seconde 12,8GB met het computergeheugen uitwisselen. Dankzij deze chips zou AMD wel eens een beslissende voorsprong op Intels Xeon kunnen nemen, profeteert DailyTech. Hoewel die opmerking in het licht van de huidige afzet van programmable logic wat aan de voorbarige kant lijkt te zijn, kan AMD's beslissing om van HyperTransport een open standaard te maken met zulke initiatieven fors uitbetalen: vergelijkbare functionaliteit is voor Intels Xeon-platform niet aanwezig of, zoals gezegd, aanzienlijk duurder.

:strip_exif()/i/1121262226.jpg?f=fpa)